30 % des serveurs d’un data center en moyenne ne seraient pas utilisés. C’est le résultat surprenant d’une note publiée par le cabinet Anthesis Group et le Center for Energy Policy and Finance de l’université de Stanford.

Outre une plus grande flexibilité, la virtualisation et maintenant la conteneurisation permettent d’optimiser le fonctionnement serveurs alors que bien souvent ils n’étaient pas utilisés à plus de 20 % de leur capacité. Mais ces deux avancées technologiques n’ont, semble-t-il, pas résolu tous les problèmes.

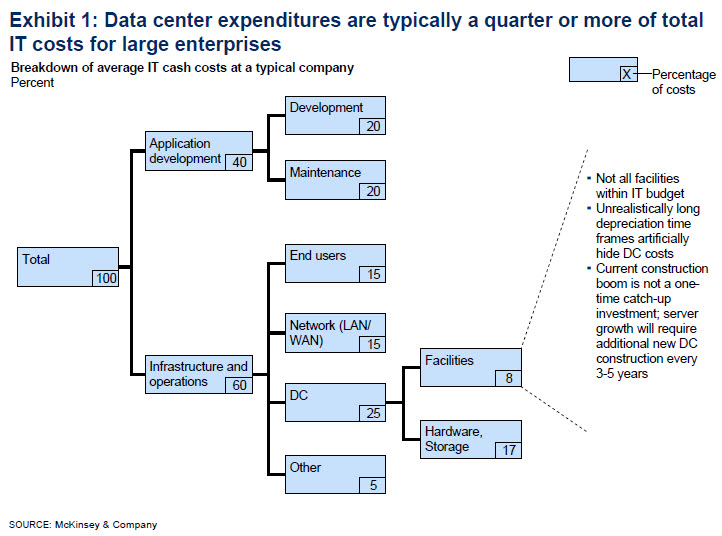

Plusieurs études successives sur les data centers ont montré l’étendue des dégâts. Une première réalisée par le cabinet McKinsey (Revolutionizing Data Center Energy Efficiency) avait révélé que l’utilisation des serveurs dans un data centers dépassait rarement 6 %, c’est-à-dire que sur une année en moyenne, le serveur ne fournissait que 6 % de sa puissance maximale et que jusqu’à 30 % d’entre eux étaient « comateux » c’est-à-dire qu’ils consommaient de l’électricité mais ne rendaient aucun service. C’était en 2008 et on pourrait penser qu’avec le temps et le progrès des technologies, la situation allait s’améliorer significativement.

Malheureusement, une nouvelle compilation de données anonymisées provenant de la société TSO Logic aux Etats-Unis dans différents secteurs et sur plus de 4000 serveurs, virtualisés et non virtualisées, montrent à nouveau un ratio de 30 % de serveurs « comateux. On voit difficilement pourquoi la situation serait significativement différente en Europe. En se basant sur ce ratio, il y a aurait donc quelque 10 millions de serveurs dormants dans le monde.

« Les data centers offrent une capacité supérieure aux besoins notamment parce que l’identification des serveurs comateux n’est pas si facile avec les outils conventionnels », expliquent Jonathan Koomey et Jon Taylor, auteurs de la note. Gérer les ressources à partir des simples indicateurs d’utilisation CPU ou mémoire n’est pas suffisant pour s’assurer qu’un serveur peut être comateux[1]. Il faut aller plus loin en analysant le trafic en sortie des serveurs, les accès des utilisateurs à chaque serveur, la distribution des tâches, l’évolution de la virtualisation afin de savoir l’état exact d’un serveur et le cas échéant de prendre la décision d’un décommissionnement sans impact sur l’activité.

La virtualisation en facilitant la mise en service et l’arrêt de machines virtuelles sur des serveurs physiques n’améliore apparemment pas la situation. Il existe des outils tels que System Center Virtual Machine Manager ou des outils comparables chez VMWare, mais toutes les DSI n’ont pas investi dans de tels outils et, lorsqu’ils le sont, ils ne sont pas toujours utilisés de manière optimale.

« L’existence d’une proportion aussi élevé de serveurs en état de non fonctionnement est une indication claire que la manière avec laquelle les ressources IT sont conçues, déployées, provisionnées et administrées doit être changée radicalement », considèrent Jonathan Koomey et Jon Taylor. Les changements nécessaires ne sont pas en priorité techniques, mais concernent plutôt les pratiques en matière de management, le suivi des flux d’informations et les incitations pour les personnes en charge de ces questions.

[1] Un serveur est défini comateux s’il ne fournit pas de service pendant six mois ou plus.

puis

puis