« Ceux qui s’occupent des bases de données ne sont pas ceux qui exploitent les résultats issus des bases de données ».

C’est l’une des facettes du discours de Christian Chabot, PDG et fondateur de l’éditeur de logiciel américain, tableau Software, une firme de Seattle qui emploie près de 1 300 personnes. La firme s’est fait une spécialité de la représentation des données.

La firme de Seattle progresse actuellement à la vitesse de sociétés comme ServiceNow ou Sales force à leurs débuts. Elle aussi a mis en avant un nouveau mode d’utilisation, dans le cloud et sur les mobiles, dont les écrans sont de plus en plus grands; ce qui rend l’outil plus accessible financièrement et plus simple à manipuler. Ce dernier est même facile à téléchargé rapidement et déclencherait, selon ses concurrents, l’arrivée rapide d’ingénieurs commerciaux prêts à vous faire signer un contrat » longue durée ». Mais cela ne retire en rien le côté attractif du logiciel.Lors de sa conférence annuelle, Christian Chabot mettait en avant l’idée de « l’expérimentation rapide des données » comme force motrice de son logiciel. Le deuxième attribut, clé de ce type de logiciels serait la vitesse, puisque les analystes comme les artistes ont besoin « retour immédiat » afin de garder l’accent sur leurs idées et ne pas se distraire de leurs objectif en évitant de se heurter à la complexité de l’outil.

La concurrence joue aussi la carte de la simplification

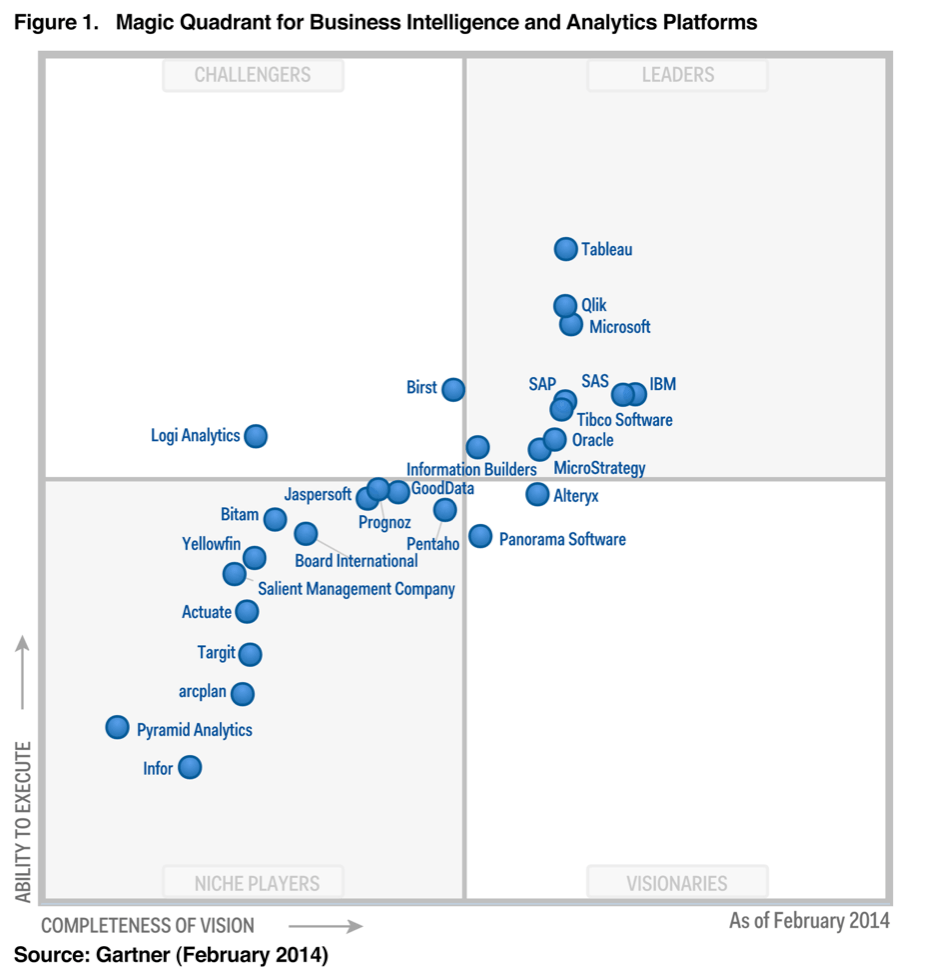

Les dernières firmes à argumenter autour des outils de représentation simplifiées étaient celles qui intégraient des outils de présentation à leurs outils classiques. SAP (Lumira), Oracle (BI), Salesforce et surtout Microsoft avec son SQL Server 2014. (image ci-dessous)

Ceux qui font les démonstrations ne sont pas toujours les analystes

Car la progression des outils de Big data, d’analyse comportementales, de business Intelligence se heurtent au mur de la représentation. A quoi bon dérouler des dizaines de pages si c’est pour laisser les spectateurs sceptiques ou pire, à moitié endormis ? Expliquer méthodiquement des choses complexes est souvent plus simple avec un dessin. Mais l’expression de Confucius « une image vaut mieux que mille mots » suppose déjà un bon dessinateur. Elle ne prend pas en compte la capacité de l’auteur a décrire, par des images, sa démonstration.Mais pour cela, faut il encore, que l’outil de dessin soit simple d’emploi ou du moins, facile à assimiler. Car le temps passé à s’approprier l’outil, fait partie de la valeur ce même outil. Dans ce sens, les nouveaux logiciels de tableau software, mais l’on pourrait parler aussi de Qlik ou même de Microstrategy démocratisent les outils d’analyse et de stats en masquant la complexité des processus. Mais pour les puristes, ces nouveaux outils permettent d’exploiter des données sans même comprendre la complexité des enjeux et cela peut être dangereux. Le cercle fermé des statisticiens dans les grands groupe du CAC 40, voient souvent avec inquiétude débarquer les requêtes des directions marketing prêts à tordre les chiffres pour fournir des tendances que l’on pourrait qualifier « d’improbables ». Désormais avec ces nouveaux outils, le marketing peut en faire à sa « tête. Cette distinction entre pro et amateurs n’est pas réservée au seul secteur des statisticiens. C’est un peu le syndrome des services métiers qui s’offrent parfois des applications à la demande via le cloud face à une informatique qui parait parfois inerte car engluée dans des procédures trop hiérarchisées.

Les trois principales type d’analyses

Comme son nom l’indique, l’analyse descriptive facilite l’organisation, le classement des données, la visualisation (leur représentation graphique) des données ; mais aussi la synthèse des données. Dans cette description, l’extraction de données du logiciel située en amont et essentielle. On va « piocher» des données qui jouent un rôle important et contribuent à la mise en forme du résultats. Mais cet écueil aurait tendance à disparaitre, tous les produits récents disposant d’une interface normalisée. C’est le premier niveau des outils de reporting, que l’on connaît bien avec Excel, qui dispose d’ailleurs d’extensions. D’autres outils sont entièrement construits sur des fonctions de statistique comme le programme open source R, un monument qui est la base de l’enseignement des Stats à l’université. Etayé par des centaines de modules complémentaires, il a d’ailleurs du susciter des vocations pour créer des outils comme Tableau ou Cliqview. On rêve de créer en un clin d’œil des représentations qui nécessitent par ailleurs des heures d’apprentissage. Dans ce domaine, il faut citer les modules MDX, Dax, les programmes Minitab, Data Discovery et des firmes de consultants comme Revolution Analytics qui sont a mis chemin entre le développement et les outils de type R fournissent des résultats sur mesure aux entreprises.

Deuxième genre de fonction, celles liées à l’analyse prédictive

Elles donnent un avantage à certains programmes spécialisés comme Rapid Miner, Kmime ou Weka et les add on de Frontline systems mais les deux références SAS et SPSS sont considérées comme incontournables. Le gartner fournit d’ailleurs à côté des produits grand public un second tableau destiné à aider le choix des spécialistes (voir ci-dessous).

Troisième domaine , celui de l’analyse prescriptive.

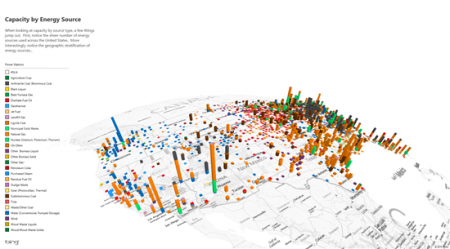

Cette aide à la décision est par exemple utilisée dans le contrôle aérien en cas de problèmes pour aider les contrôleurs à rebattre les cartes des options pour optimiser les atterrissages. En Formule 1, « l’expérience » utilisée par les programmes d’analyse prédictive permet de décider le moment le plus adéquat pour changer de pneus en fonction de leur usure, du trafic et de la météo. L’adaptation en temps réel tire simultanément parti de l’utilisation de milliers de scénarios hypothétique – de type « What if » – élaborés au préalable et couvrant des milliards de combinaisons. Selon le blog de SAS, Geoff McGrath, le Directeur général de McLaren Applied Technologies, qui exploite des données issues des capteurs de ses formules 1 : tout événement physique peut être modélisé dans un logiciel afin de faciliter son analyse. Chez Oracle,le programme de Référence s’appelle Crystal Ball, ce qui peut faire sourire mais le data mining et les outils de type solveur, les outils d’analyse de régression permettent d’associer des données géographiques à des chiffres pertinents. Cela permet de répondre de manière instantanée à des questions comme : « Où trouver une proportion d’accidents de la circulation supérieure à la normale dans une ville ? ». C’est l’argument d’Esri pour promouvoir ses cartes au travers de ses logiciels comme ArcGIS for Desktop. Bref, l’avénement d’outils de représentation graphique simple comme ceux de tableau software s’appuie sur la multiplication des sources de données. Le Big data et les objets connectés remplissent de nouveaux puits d’informations.

puis

puis