Au CES 2026, Nvidia fait de Rubin bien plus qu’un nouveau GPU mais une plateforme complète pensée pour l’industrialisation des « AI factories » où Nvidia pousse ses nouveaux modèles, frameworks et outils pour aider les DSI à traquer le coût du token, les watts et les goulots d’étranglement et passer l’IA agentique en production…

Nvidia a choisi le CES 2026 à Las Vegas pour officialiser l’entrée en pleine production de sa nouvelle génération de GPU Rubin présentée l’an dernier et qui a la lourde tâche de remplacer la génération Blackwell dans les infrastructures IA. Le fabricant a toutefois inscrit cette nouvelle génération dans un cadre plus large que celui du simple GPU et mis en avant une logique d’usine d’IA, où la métrique clé n’est plus seulement la performance brute, mais le coût du token, l’efficacité énergétique, la résilience opérationnelle et la sécurité de bout en bout. Le CEO de Nvidia, Jensen Huang, a une nouvelle fois formalisé un message devenu central dans l’industrie et qui s’annonce le grand leitmotiv de l’année 2026 : l’IA n’est plus un sujet de laboratoire, mais un sujet d’industrialisation.

Rubin est surtout une plateforme

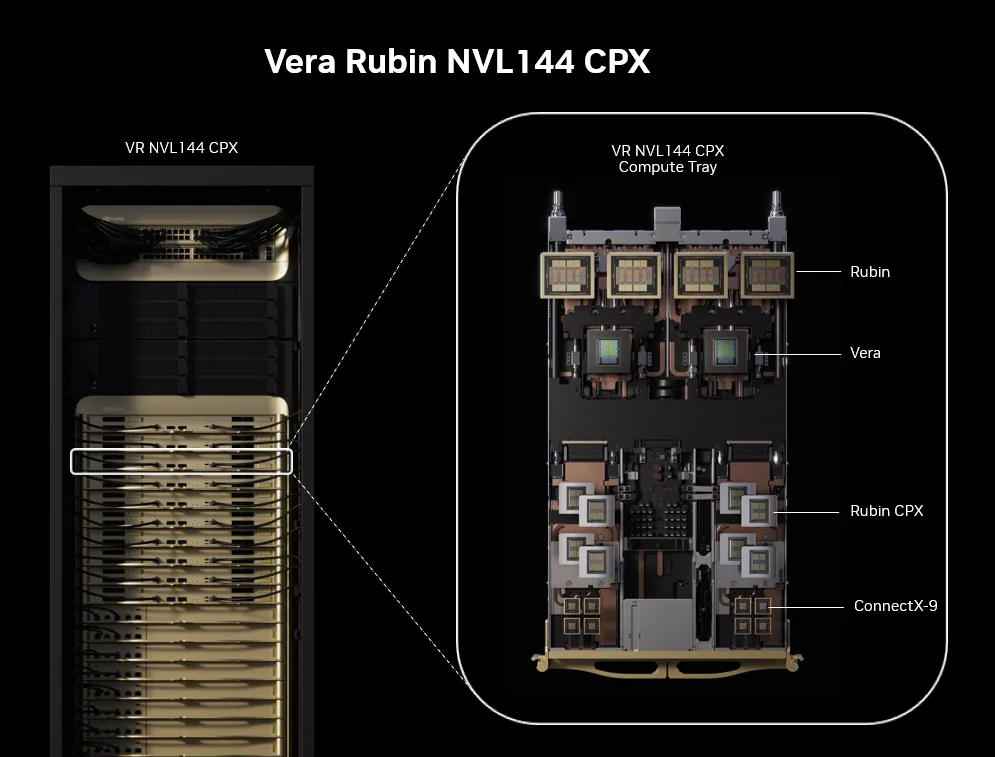

Ainsi, le GPU Rubin n’est pas annoncé comme un simple successeur de Blackwell, mais comme une plateforme assemblée autour de six briques, conçues comme un tout : GPU Rubin, CPU Vera, NVLink 6 pour le scale-up, Spectrum-X / Spectrum-6 pour le scale-out (avec une déclinaison Ethernet Photonics), SuperNIC ConnectX-9 et DPU BlueField-4. NVIDIA insiste ainsi sur l’approche « extreme codesign » qui a guidé le développement de Rubin, c’est-à-dire une co-conception matérielle et logicielle censée réduire les pertes liées à l’intégration et aux transferts de données à l’échelle du rack.

Sur la partie calcul, l’entreprise met en avant un GPU Rubin crédité de 50 pétaflops en inférence NVFP4, avec des gains internes annoncés de 3,5× sur l’entraînement et 5× sur l’inférence par rapport à Blackwell, avec jusqu’à 8× plus de calcul d’inférence par watt !

Ces chiffres, plutôt impressionnants, restent des mesures constructeur, mais ils donnent la tonalité : Rubin est vendu comme une réponse à la montée des charges d’inférence « à contexte long » et de raisonnement, là où l’efficacité énergétique et le coût unitaire deviennent structurants.

Le cœur de la promesse, martelé sur scène, vise la baisse du coût des tokens. NVIDIA évoque jusqu’à un facteur 10 sur le coût d’inférence vs Blackwell, et une réduction par 4 du nombre de GPU nécessaires pour entraîner certains modèles MoE (mixture-of-experts).

Au-delà de l’argument économique, c’est un signal adressé aux opérateurs d’infrastructures : l’optimisation « système » (CPU, interconnexions, réseau, DPU, stockage, orchestration) est désormais aussi essentielle à l’IA que le GPU.

Dans cette optique, le CPU « Vera » est considéré comme une composante essentielle. Déjà, Nvidia avait largement réussi à imposer ses superchips GB200/GB300 (combinant CPU « Grace » et GPU « Blackwell) dans les datacenters de l’IA, ceux des hyperscalers et les HPC. Nvidia a ainsi beaucoup contribué à populariser l’architecture ARM dans les datacenters ces dernières années. Dans la nouvelle plateforme « Vera Rubin », le CPU Vera est présenté par Nvidia comme la pièce qui traite un problème devenu central à l’échelle des « AI factories » : soutenir l’utilisation GPU en supprimant les goulets d’étranglement côté orchestration, flux de contrôle et mouvements de données. Vera repose sur 88 cœurs ARM “Olympus” conçus par NVIDIA, compatibles Armv9.2, avec un mécanisme de Spatial Multithreading portant l’ensemble à 176 threads. L’architecture met l’accent sur la bande passante mémoire (jusqu’à 1,2 To/s) et la capacité (jusqu’à 1,5 To de LPDDR5X, au format SOCAMM), ainsi que sur une cohérence étendue avec les GPU via NVLink-C2C (jusqu’à 1,8 To/s), afin de permettre une mémoire CPU-GPU cohérente et des usages comme le déport de KV-cache. Nvidia indique également un support natif du confidential computing sur cette génération.

DGX SuperPOD Rubin : l’industrialisation par le rack

Deux nouvelles briques fondatrices ont ainsi été annoncées : un rack DGX Vera Rubin NVL72, qui combine 36 CPU Vera, 72 GPU Rubin et 18 DPU BlueField-4 dans un même ensemble, et une variante « serveur » (en photo ci-contre) dénommée DGX Rubin NVL8 (huit GPU Rubin, NVLink de 6e génération), orientée « on-ramp » et refroidissement liquide, pour des organisations qui veulent entrer dans l’ère Rubin sans basculer immédiatement sur un rack complet de type NVL72.

Et bien évidemment la brique NVL72 sert de fondation aux fameux SuperPODS de Nvidia. Le SuperPOD « Rubin » est un « blueprint » (un modèle d’architecture reproductible) qui sert de référence aux intégrateurs et aux équipes I&O pour dimensionner, déployer à grande échelle le couple Vera Rubin et opérer un tel SuperPOD comme une « AI factory » : une configuration avec huit systèmes NVL72 totalise 576 GPU Rubin, pour 28,8 exaflops FP4 et 600 To de mémoire « fast memory », avec un débit NVLink agrégé annoncé à 260 To/s, l’objectif étant de limiter (ou éviter) les contraintes de partitionnement modèle à l’échelle du rack. La cible implicite de cette méga-architecture est l’IA « industrielle » : entraînement, inférence, raisonnement, long contexte, et opérations de plateforme (intégration, maintenance, orchestration).

En filigrane, Rubin est aussi cadré comme une plateforme de confiance : le billet DGX insiste sur la montée en puissance du « confidential computing » à l’échelle rack, et sur des mécanismes de RAS (reliability, availability, serviceability) censés accélérer les opérations de maintenance. Dans un contexte où les clusters IA deviennent des actifs critiques, ces éléments sortent du registre « HPC » pour entrer dans celui du datacenter classique.

L’autre versan Rubin : Modèles ouverts, données et outils

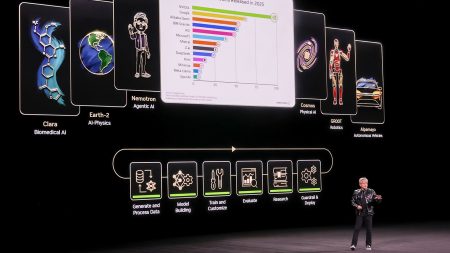

Le CES 2026 a aussi été l’occasion pour NVIDIA d’aligner clairement matériel et stratégie modèles et de dérouler son discours « bout en bout » où l’infrastructure et les modèles avancent au même rythme pour abaisser fortement le coût de génération des tokens et animent une plateforme d’exécution industrialisable proposant des briques modèles/données réutilisables, adaptées aux métiers.

Derrière l’effet d’échelle, ces chiffres signalent surtout une stratégie : accélérer l’adaptation « domaine » via des assets ouverts (modèles, datasets, code, blueprints) pour réduire le temps nécessaire à produire un modèle utile dans un contexte métier que ce soit pour des agents (recherche documentaire multimodale, reconnaissance vocale, sécurité/PII), pour des robots (raisonnement + génération de données synthétiques) ou pour l’autonomie (simulation et cas limites).

Le « continuum » entre modèles, données et exécution, poussé par Nvidia, cherche autant à ancrer la plateforme Nvidia au cœur des infrastructures d’entreprise qu’à éviter la rupture classique entre R&D et production. NVIDIA pousse ses modèles et datasets sur des canaux familiers des équipes (GitHub, Hugging Face), mais rappelle qu’une partie du portefeuille est aussi empaquetée sous forme de NIM (des microservices de déploiement) afin de standardiser la mise en production « edge-to-cloud » sur toute infrastructure accélérée Nvidia. Tout en rappelant que l’ouverture sert aussi l’adoption, la souveraineté et le fine-tuning !

Sur la brique agentique, NVIDIA met en avant sa gamme de modèles Nemotron avec des déclinaisons orientées voix, RAG multimodal et sécurité : un ensemble « Nemotron Speech », des modèles d’embedding et de reranking pour la recherche documentaire, ainsi que des modèles de content safety et de détection de données sensibles (PII). L’offre est ainsi cohérente avec les attentes des DSI : industrialiser des agents implique autant la qualité des signaux (recherche, multimodalité) que les garde-fous (sécurité, confidentialité, contrôle).

L’ère de la « Physical AI » et de la robotique

Dans le même mouvement, Isaac GR00T N1.6 est présenté comme un modèle VLA (vision-language-action) destiné aux humanoïdes, articulé avec Cosmos Reason pour améliorer le raisonnement et la compréhension contextuelle.

La différence, par rapport aux annonces de modèles génériques, se joue dans l’outillage de cycle de vie. NVIDIA ajoute Isaac Lab-Arena un framework open source d’évaluation et de benchmark pour la robotique, et surtout OSMO, un framework d’orchestration edge-to-cloud destiné à chaîner génération de données synthétiques, entraînement et tests « software-in-the-loop » sur des environnements hétérogènes (workstations, cloud, instances mixtes).

Enfin, l’intégration annoncée avec Hugging Face (LeRobot) vise à capter l’écosystème open source robotique, avec une promesse de simplification du fine-tuning et de l’évaluation.

Alpamayo, un modèle ouvert pour véhicules autonomes

Alpamayo est décrit comme une approche de type vision-langage-action : le modèle analyse ce qu’il voit, comprend le contexte, puis choisit une trajectoire. NVIDIA met aussi en avant un mécanisme de raisonnement explicite (« chain-of-thought ») censé rendre les décisions plus compréhensibles et plus robustes. L’ensemble s’inscrit dans Halos, la pile de sécurité du constructeur.

Le détail le plus concret concerne Alpamayo 1 : un modèle de 10 milliards de paramètres, alimenté par des entrées vidéo, qui produit trajectoires et traces de raisonnement, et dont l’objectif est d’être utilisé comme « teacher model » afin d’être distillé en modèles plus petits pour l’exécution.

NVIDIA ouvre également AlpaSim (simulation end-to-end) et des « Physical AI Open Datasets » revendiquant plus de 1 700 heures de données de conduite sur des géographies et conditions variées. Plusieurs acteurs (JLR, Lucid, Uber, Berkeley DeepDrive) sont cités comme soutiens ou utilisateurs potentiels dans cette trajectoire vers la conduite autonome de niveau 4.

Au final, force est de constater que le fil rouge de ces annonces est moins la surenchère de performance que la tentative d’absorber, au niveau plateforme, les contraintes d’industrialisation : coût du token, efficacité énergétique, résilience, sécurité, opérations et outillage de cycle de vie. Rubin et ses SuperPODs s’inscrivent dans une vision « usine d’IA », où réseau, DPU, stockage et orchestration deviennent des leviers au même titre que le GPU. En parallèle, Nvidia continue de peaufiner sa stratégie « open models + datasets + frameworks » qui vise à déplacer une partie de la valeur vers l’adaptation métier et la mise en production rapide (avec Nemotron pour l’agentique, Cosmos/GR00T pour la robotique et Alpamayo pour la conduite autonome). On notera néanmoins que si Nvidia a confirmé l’entrée en pleine production des GPU Rubin et des superchips Vera-Rubin, et si certains hyperscalers commencent déjà à être livrés, l’arrivée des offres partenaires « Rubin » n’est pas attendue avant le second semestre 2026.

puis

puis