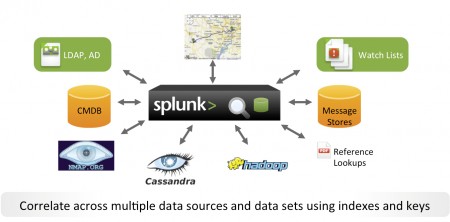

Connu depuis 2008 pour être un outil d’analyse de logs très polyvalent, Splunk est en train de faire exploser les murs qui séparaient le big data des SIEM (outils d’administration) et de la Business Intelligence.

A l’occasion de sa réunion annuelle, l’éditeur Splunk avait fait venir plusieurs de ses clients, des banques et assurances, mais aussi Auchan, dont nous avons pu interviewer un de ses représentants. Si l’on en croit tous les intervenants, plus la peine de s’inscrire à des cours de 3 mois de formation sur l’analyse prédictive et de connaître par cœur les 200 fonctions alambiquées d’un logiciel de statistiques, Splunk remet en cause pas mal de certitudes et c’est un peu dérangeant. « C’est certainement l’effet de la recherche autour de la sécurité, les fameux forensics qui ont déclenché la récente prise de conscience de l’ouverture de ce logiciel », explique Arnaud Fieffe, responsable middleware chez Euler Hermes – un des leaders mondiaux dans l’assurance crédit lors de la conférence annuelle de l’éditeur américain. « C’était au départ surtout un outil d’administrateur de réseaux qui ne faisait qu’accompagner d’autres outils. Il y a six ans, je m’en servais au début pour suivre les logs des applications, pour comprendre les problèmes des middleware MQ series. On avait du mal à l’identifier en tant qu’outil indépendant. Mais à force de s’en servir, on s’est rendu compte désormais que c’était un outil de Big data hyper efficace. On arrive très simplement à créer des rapports et des analyses sur des événements particuliers. Donc entrer dans les fondements des applicatifs pour comprendre ses liens avec l’OS n’est pas un problème.

Splunk sort des logs chez Auchan Ecommerce

Présent à la fin de la journée de présentation annuelle de Splunk à La Défense, Auchan Ecommerce, généralement extrêmement discret sur son informatique interne était représenté par Stéphane Duarte, responsable du back-office et Rached Tayech, spécialiste du BI.

Chez Auchan Ecommerce, la vente en ligne et analyse du comportement des acheteurs a toujours constitué un sujet d’études approfondies. « Notre activité informatique liée au site d’e-commerce est restée indépendante de la maison mère. On a commencé en 2000 comme un laboratoire d’E-Commerce et l’on a toujours fait travailler un bon nombre de sous-traitants spécialisés. On a progressé sans cesse depuis, et en particulier avec le rachat du site GroBill et ses 150 collaborateurs en 2006. On a tous travaillé d’arrache-pied sur des perspectives de ventes « multicanal » qui constitue un enjeu essentiel pour l’avenir ». Les canaux digitaux, des hypermarchés de la marque ou ses centres d’appels constituent des sources inépuisables d’informations : « En 2013, comme on cherchait des logiciels d’analyse de flux et d’extraction de données, on s’est rendu chez Splunk a Londres où ils nous ont montré le travail réalisé par le site de vente en ligne « John Lewis », ce qui nous a immédiatement convaincu de l’intérêt de l’ exploitation de Splunk dans des objectifs « métier ». En 2014, on a réalisé un premier pilote de monitoring métier et là on vient de terminer une étude plus large, un POC (proof of Concept) sur 80 Go capturés en un seule journée qui est très convaincant. On a désormais un outil de supervision en temps réel qui est capable d’agréger des données en volumes quel que soit le type, le format ou la source. Et cela intéresse la maison mère. Il permet un reporting rapide. Outre la restitution des résultats, on sert des API Rest pour exploiter les services d’analyse depuis des applications tierces ».

Interrogé sur les produits déjà utilisés et l’hébergeur qui abritait les serveurs du site Stéphane Duarte précisait qu’il existait des clauses de confidentialité pour les hébergeurs mais que les outils de reporting les plus courants étaient encore basés sur Clickview, car ils ne nécessitaient pas de connaissances informatiques approfondies et étaient très souples. « On utilise aussi les outils de Tableau Software. Le fait que l’on puisse utiliser les outils déjà existants et les relier avec d’autres grâce à Splunk, c’est déterminant ». Interrogé sur l’éventuelle utilisation d’outils de CRM en connexions avec Splunk, Rached Tayech précisait : « C’est un sujet qui fait l’objet d’études stratégiques dont on ne peut pas vous parler ».

Auchan, connu pour sa discrétion, n’échappe pas à priori aux tendances générales des grandes surfaces qui ne cessent de se diversifier en multipliant dans les grandes villes, jusque-là souvent mal ravitaillées, de nouveaux points de vente. Sur le site, la formule de livraison explique une bonne partie le succès : « Le client a le choix entre 6 000 à 15 000 produits de consommation quotidienne répartis en douze rubriques. Il choisit les quantités qu’il souhaite, définit la date et l’heure à laquelle il viendra récupérer ses courses. Au moment du rendez-vous, il s’identifie à une borne et un préparateur dépose directement les articles dans le coffre de sa voiture ». Sans être grand clerc, on peut imaginer que c’est l’optimisation de la logistique et des flux de produits qui doivent permettre à Auchan de se distinguer de ses concurrents directs comme Carrefour mais aussi reprendre la main sur les concurrents en ligne. Pour les spécialistes, les magasins physiques ont encore de beaux jours devant eux, l’e-commerce n’ayant généralement pas de SAV à la hauteur des « anciens».

Quid de Hadoop ?

Interrogée sur l’éventuelle utilisation d’Hadoop et d’Hunk, la surcouche que propose Splunk pour Hadoop, Rached Tayech précisait que la firme avait étudié le sujet mais que Splunk avec ses fonctions préprogrammées permettait d’aller déjà très loin. « L’utilisation de Splunk remet même en cause les critères de sélections des « data scientists », on a moins besoin de profils de haut niveau pour des tâches classiques comme écrire des requêtes, fabriquer des tableaux ; les spécialistes métiers, les administrateurs de bases de données ( DBA) qui connaissent les fichiers et la nature des données peuvent le faire ». Interrogé sur les points noirs éventuels de Splunk, Stéphane Duarte précisait : « On a quand même une connaissance récente de ce produit donc on n’a pas forcement fait tout le tour de ce produit, on est encore en pleine lune de miel ». Inquiet de n’avoir qu’une seule vison sûrement un peu trop idyllique de ce logiciel, nous avons insisté et Rached Tayech a conclu que dans le cas d’une utilisation en mode totalement virtualisée, les entrées sorties étant énormes, le reporting n’était pas très bon et qu’il valait mieux s’en servir en mode réel. Une analyse critique confirmée par Arnaud Fieffe d’Euler Hermes. Interrogé sur les produits qui auraient pu donner le même effet de « révélations », Arnaud Fieffe précisait que les outils d’analyses utilisés par les informaticiens opérationnels, les DevOps, pouvaient aussi créer des ruptures. A notre connaissance, seuls les outils de ServiceNow et Clickview avaient été capables de créer des groupes d’utilisateurs complètement passionnés. Arnaud Fieffe : « Mais Splunk permet de travailler sur les flux et s’ouvre très facilement aux autres applications et cela permet de résoudre des problèmes qui auraient nécessité d’autres outils avec des formations spécifiques ; cela représente de bonnes économies ».

puis

puis