La startup canadienne Cohere dévoile Tiny Aya, une famille de modèles d’IA multilingue open-weight capables de tourner sur un simple laptop, voire sur un smartphone, sans connexion internet. Avec la volonté de démocratiser l’IA au-delà de l’anglais, jusque dans les langues les plus sous-représentées. Un concurrent sérieux pour Mistral AI et son Ministral 3B ?

Dans la course à l’IA générative, Cohere occupe une place singulière. Fondée en 2019 à Toronto par Aidan Gomez, co-auteur du fameux article « Attention Is All You Need » qui a posé les fondations de l’architecture Transformer aux côtés de Nick Frosst et Ivan Zhang, la startup canadienne s’est forgé un positionnement résolument B2B. Là où OpenAI mise sur le grand public avec ChatGPT, où Anthropic cultive la sûreté de l’IA avec Claude, et où le Français Mistral AI joue la carte de l’open source souverain, Cohere a fait le choix stratégique de se concentrer sur les déploiements enterprise, avec une obsession : le multilingue.

Et les résultats suivent. Selon CNBC, la société a clôturé 2025 avec un revenu récurrent annuel (ARR) de 240 millions de dollars et une croissance de 50 % trimestre après trimestre. Valorisée à environ 7 milliards de dollars après sa dernière levée, Cohere est en ordre de marche pour une introduction en bourse qu’Aidan Gomez a qualifiée d’imminente.

Pourquoi Tiny Aya change la donne

En marge de l’India AI Summit, Cohere a annoncé une nouvelle famille complète de modèle open-weight, Tiny Aya. Ces modèles ouverts sont optimisés pour fonctionner directement sur des appareils du quotidien : laptops, smartphones, terminaux embarqués. Le tout sans nécessiter de connexion internet.

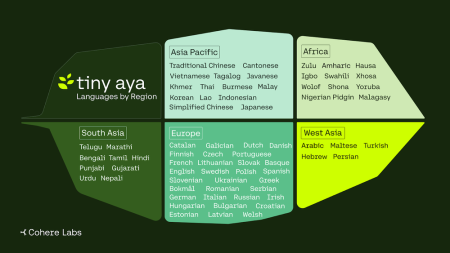

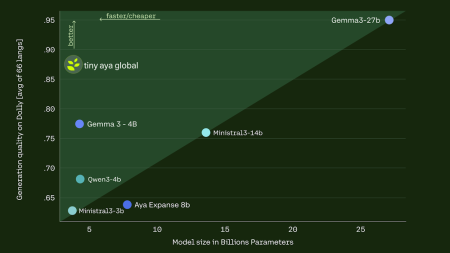

L’enjeu est considérable. Aujourd’hui, l’immense majorité des modèles d’IA performants restent centrés sur l’anglais, voire sur une poignée de langues dominantes. Pour les milliards de personnes qui s’expriment en bengali, en tamoul, en ourdou, en swahili ou en gujarati, l’IA générative reste largement inaccessible. Tiny Aya ambitionne de corriger ce déséquilibre, en couvrant plus de 70 langues avec un modèle de seulement 3,35 milliards de paramètres, une taille volontairement contenue pour permettre le déploiement en edge. Une approche qui ressemble furieusement à celle de Mistral AI et de son modèle ouvert multilingue Ministral 3B.

Une architecture pensée par régions

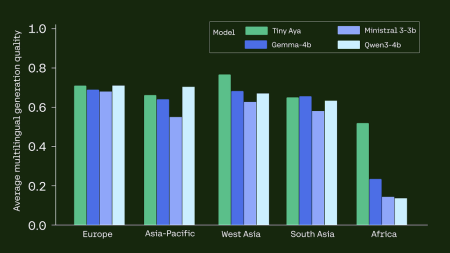

La famille Tiny Aya se décline en plusieurs variantes, chacune conçue pour répondre aux spécificités linguistiques et culturelles de grandes zones géographiques. Le modèle de base offre une couverture multilingue large. TinyAya-Global, une version fine-tunée, améliore le suivi d’instructions utilisateur pour les applications nécessitant un support linguistique étendu. Trois variantes régionales complètent le dispositif : TinyAya-Earth pour les langues africaines, TinyAya-Fire pour les langues sud-asiatiques (hindi, bengali, pendjabi, ourdou, gujarati, tamoul, télougou, marathi), et TinyAya-Water pour l’Asie-Pacifique, l’Asie occidentale et l’Europe.

« Cette approche permet à chaque modèle de développer un ancrage linguistique plus profond et des nuances culturelles plus fines, créant des systèmes qui paraissent plus naturels et fiables pour les communautés qu’ils sont censés servir. Dans le même temps, tous les modèles Tiny Aya conservent une couverture multilingue large, ce qui en fait des points de départ flexibles pour l’adaptation et la recherche », explique Cohere dans son communiqué.

Un entraînement frugal, un déploiement universel

Détail technique notable : l’ensemble de la famille Tiny Aya a été entraîné sur un unique cluster de 64 GPU Nvidia H100. Dans un secteur où les budgets d’entraînement atteignent des centaines de millions de dollars, cette frugalité est un message en soi. Cohere démontre qu’il est possible de produire des modèles multilingues performants sans mobiliser des ressources de calcul pharaoniques, un argument qui résonnera particulièrement auprès des équipes de recherche académiques, des ONG et des développeurs opérant dans des marchés émergents.

La stack logicielle sous-jacente a été conçue dès l’origine pour l’inférence on-device, avec une empreinte CPU/GPU réduite par rapport aux modèles comparables. Dans des pays à forte diversité linguistique comme l’Inde, où la connectivité reste inégale, cette capacité à fonctionner hors ligne ouvre des perspectives concrètes : traduction offline, assistants vocaux locaux, outils de terrain pour les travailleurs humanitaires ou les professionnels de santé.

Open-weight, open data, open science

Fidèle à la philosophie de Cohere Labs, les modèles Tiny Aya sont disponibles sur Hugging Face et sur la plateforme Cohere. Les développeurs peuvent les télécharger via Hugging Face, Kaggle et Ollama pour un déploiement local. Cohere publie également les datasets d’entraînement et d’évaluation sur Hugging Face, et prévoit la publication d’un rapport technique détaillant sa méthodologie.

Cette ouverture s’inscrit dans la continuité de l’initiative Aya, lancée il y a deux ans, qui a fédéré plus de 3 000 chercheurs issus de 119 pays pour faire progresser l’IA multilingue. Le programme avait déjà produit Aya Expanse (101 langues) et Aya Vision (modèle multimodal en 23 langues). Tiny Aya en constitue l’extension naturelle vers le edge computing et l’embarqué.

Un positionnement stratégique sur le marché enterprise

Le lancement de Tiny Aya place Cohere sur un terrain où un autre acteur s’est déjà solidement installé : Mistral AI. En décembre dernier, la startup française dévoilait sa famille Mistral 3, dont les modèles Ministral 3 (3B, 8B et 14B paramètres) ciblent exactement le même créneau, celui de l’IA compacte, multilingue et optimisée pour le edge d’entreprise. Comme Tiny Aya, les Ministral sont conçus pour tourner sur des appareils du quotidien sans connexion internet, et sont publiés sous licence ouverte.

Les philosophies divergent cependant sur plusieurs points. Mistral AI mise sur la polyvalence : ses Ministral sont multimodaux (texte et vision), déclinés en variantes base, instruct et reasoning, et pensés pour des cas d’usage allant de la robotique aux drones en passant par l’automobile. Guillaume Lample, cofondateur et chief scientist de Mistral AI, revendique une couverture native de plus de 40 langues, avec un accent particulier sur les langues européennes.

Cohere, de son côté, pousse la spécialisation linguistique beaucoup plus loin avec ses variantes régionales (Earth, Fire, Water) ciblant spécifiquement les langues africaines, sud-asiatiques et d’Asie-Pacifique, des territoires où Mistral est nettement moins présent (mais Mistral porte un intérêt particulier sur les langues du Moyen-Orient).

Pour les DSI et les RSSI, les deux approches présentent des atouts complémentaires. Mistral AI séduit par son ancrage européen, sa conformité native avec les exigences de souveraineté numérique et sa gamme étendue de modèles allant du edge au frontier. Cohere se distingue par sa profondeur multilingue inégalée et son écosystème de recherche ouvert (datasets d’entraînement et d’évaluation publiés sur Hugging Face). Dans un contexte où le RGPD et les réglementations sur la résidence des données se durcissent, disposer de modèles compacts, déployables on-premise et capables de traiter correctement les langues locales est devenu un impératif opérationnel.

Une chose est sûre : en démocratisant l’accès à l’IA multilingue jusque sur les terminaux les plus modestes, Cohere et Mistral AI dessinent ensemble les contours d’un marché où la prochaine bataille ne se jouera pas dans les data centers des hyperscalers, mais dans la poche de milliards d’utilisateurs qui ont difficilement accès à ces technologies dans leur propre langue.

puis

puis