Du calcul raisonné de Qwen3 aux avatars animés de Wan2.2-S2V, Alibaba multiplie les avancées IA confirmant le virage du groupe vers l’intelligence artificielle. Et pour mieux s’imposer, le groupe fait reposer toute sa stratégie sur une ouverture open source qui lui sert de levier pour défier la suprématie américaine.

Porté par une vague d’innovations et d’investissements massifs, Alibaba vit aujourd’hui une véritable effervescence autour de l’intelligence artificielle, qui s’impose comme le moteur central de sa croissance. Le groupe chinois, longtemps perçu avant tout comme un géant du e‑commerce, voit désormais ses résultats financiers dopés par l’essor fulgurant de ses activités liées à l’IA. Les revenus issus de ses produits et services dans ce domaine affichent une progression à trois chiffres, tandis que sa division cloud, étroitement liée à ces technologies, ont récemment enregistré une hausse de 26 %, dépassant les attentes des analystes.

Le CEO du groupe, Eddie Wu, a d’ailleurs récemment rappelé que l’intelligence artificielle générale (AGI) était désormais l’objectif principal de l’entreprise, son groupe investissant massivement dans des modèles de langage, des services IA et des outils comme la génération vidéo open source. Le groupe a officialisé un investissement massif qui prévoit de consacrer plus de 45 milliards d’euros à l’IA sur trois ans.

Déjà connu pour sa série de LLM publiés en open source Qwen, Alibaba a diversifié sa R&D en IA et annoncé ces derniers plusieurs innovations majeures à commencer par de nouveaux modèles à raisonnement Qwen3, de nouveaux outils agentiques, un spectaculaire modèle de génération vidéo Wan2.2-S2V et serait même en train de concevoir ses propres accélérateurs IA maison pour s’affranchir de Nvidia et des limitations américaines. De quoi repositionner le groupe comme un acteur incontournable de l’infrastructure technologique et de l’innovation IA en Chine.

Qwen gagne en raisonnement

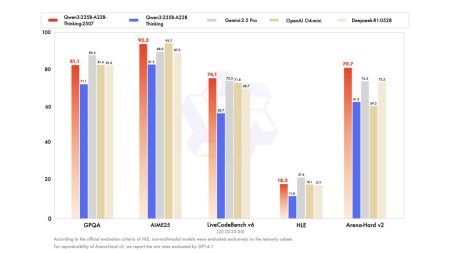

Lancé il y a quelques jours, Qwen3-235B-A22B-Thinking-2507 est une nouvelle variante du modèle frontière d’Alibaba doté de raisonnement avancé. Ce modèle, de 235 milliards de paramètres mais n’en activant qu’environ 22 milliards à la fois grâce à une architecture Mixture-of-Experts, se distingue par ses performances exceptionnelles en logique, mathématiques complexes, sciences et codage avancé. Il atteint notamment des scores de 92,3 sur AIME25 et 74,1 sur LiveCodeBench v6, surpassant ainsi les standards des modèles open-source dans ces domaines exigeants.

L’un de ses atouts majeurs réside dans sa capacité à traiter de vastes volumes d’information, avec une longueur de contexte native de 262 144 tokens. Disponible sur Hugging Face, le modèle peut être déployé via des outils comme sglang ou vllm, et s’intègre efficacement avec le framework Qwen-Agent pour exploiter ses compétences en appel d’outils. Les développeurs sont encouragés à formuler des instructions précises, comme “raisonne étape par étape”, pour maximiser la qualité des réponses. Ce lancement marque une avancée significative dans l’univers des grands modèles open source et dans l’accessibilité de l’IA de raisonnement de haut niveau, rivalisant avec les modèles propriétaires les plus performants.

Alibaba à l’ère agentique

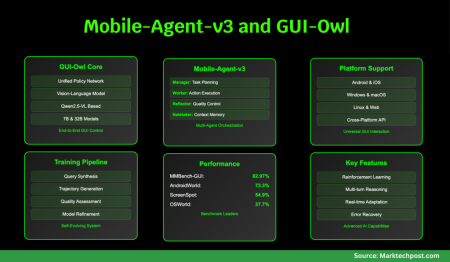

Leur méthode d’apprentissage repose sur un système qui crée automatiquement ses propres données. Les agents testent des actions dans des environnements virtuels, observent les résultats, et apprennent de leurs réussites ou de leurs erreurs. Ce processus est répété et affiné en permanence grâce à une analyse précise de chaque étape, ce qui permet aux agents de devenir de plus en plus efficaces.

Selon les chercheurs chinois, les performances de ces modèles surpassent celles des solutions open-source et propriétaires existantes, notamment dans la localisation d’éléments UI, la prise de décision et l’exécution de tâches complexes. Enfin, leur intégration dans des systèmes réels est facilitée par une compatibilité multi-plateforme et une transparence dans le raisonnement, ouvrant la voie à des agents GUI (dans la lignée des Computer Use et Claude for Chrome) véritablement autonomes et polyvalents.

Wan2.2-S2V transforme une photo en avatar animé

Enfin, cette semaine, Alibaba a également créé la surprise en dévoilant Wan2.2-S2V (Speech-to-Video), un modèle IA en open source conçu pour générer des avatars humains animés à partir d’une simple image et d’un fichier audio.

Wan2.2-S2V s’inscrit dans la série de modèles de génération vidéo Wan2.2 d’Alibaba. Sa fonction principale est de transformer des photographies de portrait en avatars animés de qualité cinématographique, capables de parler, de chanter ou d’adopter des comportements complexes. La technologie repose sur une animation guidée par l’audio pour synchroniser les mouvements des lèvres et les expressions faciales, tout en intégrant des instructions textuelles (prompts) pour diriger les mouvements corporels globaux et certains éléments de l’environnement.

Contrairement aux solutions traditionnelles de type « talking-head », ce modèle combine le contrôle des mouvements globaux par le texte et des micro-mouvements affinés par l’audio. Cette approche hybride permet de générer des animations plus naturelles et expressives, y compris dans des scènes impliquant plusieurs personnages. Le système peut animer une large gamme d’avatars, allant de figures humaines réalistes à des personnages de dessins animés ou stylisés.

Sur le plan technique, Wan2.2-S2V introduit une avancée notable dans le traitement des séquences longues. Le modèle compresse les images précédentes d’une vidéo en une représentation latente compacte, réduisant ainsi considérablement la charge de calcul. Cette optimisation assure une meilleure stabilité et cohérence pour la production de vidéos de longue durée, un défi majeur dans le domaine de la génération de contenu animé.

Pour assurer sa performance, le modèle a été entraîné sur un vaste jeu de données audio-visuelles spécifiquement constitué par les équipes de recherche d’Alibaba pour des scénarios de production cinématographique et télévisuelle. Grâce à une approche d’entraînement multi-résolution, l’outil offre une bonne flexibilité de production, avec des résolutions de sortie de 480P ou 720P et une compatibilité avec des formats variés. La génération peut se faire en mode portrait pour des contenus destinés aux smartphones et réseaux sociaux mais aussi en mode paysage pour des usages plus traditionnels et professionnels.

Dans la continuité de sa stratégie open-source, après les lancements de Wan2.1 et Wan2.2 plus tôt cette année, Alibaba Cloud a rendu Wan2.2-S2V accessible sur les plateformes Hugging Face et GitHub, ainsi que sur sa propre communauté ModelScope. La série de modèles Wan a déjà enregistré plus de 6,9 millions de téléchargements, témoignant de l’intérêt de la communauté pour ces technologies.

Une puce IA maison ?

Selon de multiples sources américaines et chinoises, Alibaba développerait également un nouvel accélérateur IA pour gagner en autonomie technologie, concurrencer Nvidia et s’affranchir des restrictions américaines qui lui interdit l’accès aux meilleures puces IA comme Blackwell. On rappellera au passage qu’après l’annonce des puces H20 de Nvidia destinée au marché chinois sous l’approbation du gouvernement Trump, Pékin a demandé à ses entreprises de cesser d’acheter des puces américaines pour des raisons de sécurité.

Ce n’est pas la première fois que le groupe chinois développe ses propres processeurs à l’instar des Yitian en technologie ARM et des Xuantie en technologie Risc-V.

Mais la nouvelle puce développée par la R&D d’Alibaba Cloud serait plus polyvalente que ses précédents modèles (Hanguang 800). Elle est conçue pour l’inférence plutôt que pour l’entraînement de modèles d’IA, et ne devrait pas être pas vendue directement : les clients pourront louer de la puissance de calcul via l’infrastructure cloud du groupe.

Selon les informations qui ont filtré, la puce serait – au moins partiellement – compatible avec l’écosystème Nvidia et les bibliothèques CUDA.

On devrait en apprendre plus à l’occasion de la grande conférence Apsara 2025 (le grand rendez-vous technologique annuel organisé par Alibaba cloud) à Hangzhou, du 24 au 26 septembre.

puis

puis