OpenAI relance le jeu avec « gpt-oss » 20B et 120B, deux modèles de raisonnement, puissants et ouverts, capables de s’exécuter localement, d’interagir avec des outils et de s’adapter aux besoins métiers. Entre stratégie d’ouverture et réponse à la pression concurrentielle, la bataille de l’IA d’entreprises vient à nouveau de s’intensifier.

C’est un peu l’Arlésienne de l’été. Tout l’écosystème de l’IA attend avec impatience l’annonce de GPT-5, un peu comme on guette un orage d’été : tout le monde sait qu’il arrive, mais personne ne connaît la date exacte. Nombreux sont ceux qui avaient parié sur le 5 Août… C’est raté. OpenAI a bien lancé hier deux nouveaux modèles. Mais aucun n’est GPT-5 ! Néanmoins, OpenAI a tenu hier une promesse faite en début d’année : dévoiler son premier LLM « ouvert » depuis son ancestral et oublié « GPT-2 ». Une annonce plus politique et stratégique qu’il n’y paraît.

Sam Altman en avait en effet fait la promesse en début d’année : OpenAI allait renouer dans l’année avec l’open-source. Et ce n’est pas un modèle, mais bien deux (l’un dérivant de l’autre) que la startup phare de l’IA a dévoilé cette semaine. En l’occurrence deux modèles de raisonnement “ouverts” — au sens open-weight — baptisés « gpt-oss-120b » et « gpt-oss-20b ».

Sous licence Apache 2.0, ils sont téléchargeables et exécutables en local, avec des performances annoncées proches des modèles « OpenAI o ». C’est donc la première fois depuis GPT-2 (2019) qu’OpenAI rouvre ainsi ses poids d’un LLM même si l’entreprise a déjà publié d’autres modèles ouverts ces dernières années à commencer par l’incontournable Whisper 3. Ces nouveaux modèles sont pensés pour fonctionner hors ligne, s’exécuter en local et même aller chercher dans le Cloud d’OpenAI – s’il le faut et si l’utilisateur le souhaite – les fonctionnalités et capacités qu’ils n’ont pas.

Avec ses nouveaux modèles « gpt-oss », OpenAI renoue donc avec son nom et sa mission initiale d’ouverture, au moins en partie. Mais ne nous y trompons pas : la pression concurrentielle des modèles ouverts (Llama, Mistral AI) et le séisme provoqué en début d’année par DeepSeek R1 ont largement contribué à ce geste, tout comme l’image écornée d’une société devenue trop fermée. Le contexte du bras de fer avec Elon Musk, qui reproche à OpenAI d’avoir trahi sa vocation, pèse aussi lourd dans cette décision : l’ouverture n’est pas qu’altruiste, c’est un repositionnement stratégique pour contrer l’argumentation du fantasque milliardaire qui multiplie les attaques et les procédures pour empêcher OpenAI d’évoluer vers une structure entièrement orientée vers les profits.

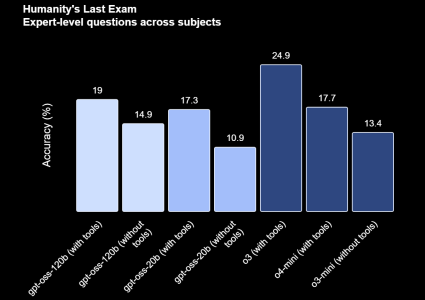

Dans le détail, gpt-oss-120b vise des déploiements data center ou stations haut de gamme, avec une exécution possible sur un seul GPU doté de 80 Go de RAM : côté performances, il se révèle très proche des excellents modèles propriétaires « OpenAI o3 » et « OpenAI o4-mini » sur les principaux benchmarks de raisonnement. L’architecture Mixture-of-Experts limite les paramètres activés par jeton (5,1 milliards de paramètres activés sur les 117 milliards de paramètres totaux di modèle), optimisant le coût d’inférence.

Le modèle gpt-oss-20B, lui, s’exécute avec 16 Go de mémoire sur un PC doté d’un NPU ou d’un GPU et vise l’itération rapide et l’usage en périphérie (edge), avec des résultats proches du niveau du modèle « OpenAI o3-mini ».

Il est cependant essentiel ici de rappeler que ces deux modèles « gpt-oss », tout comme leurs principaux concurrents LLama 4 de Meta et Magistral de Mistral, ne sont pas de vrais modèles « open source » au sens OSI. Ce sont des modèles « Open-weight », ce qui signifie que seuls les poids du modèle sont publiés et réutilisables, mais que le code d’entraînement et surtout les données utilisées pour l’entraînement restent sous le boisseau. Autrement dit, c’est ouvert pour l’usage et la personnalisation, pas pour l’audit complet de la filière d’entraînement.

Concrètement, qu’est-ce que les entreprises peuvent faire avec de tels modèles ouverts ? Héberger les modèles sur leur propre infra, garder les données sur site, ajuster finement (full-parameter fine-tuning) les modèles pour les aligner sur leurs données et leurs politiques, contrôler la latence et combiner l’IA locale avec des appels API pour des fonctions annexes (par exemple la génération d’images).

Selon OpenAI, ses deux modèles ouverts ont été optimisés pour l’utilisation d’outils (autrement dit, ils ne sont pas seulement bons à répondre à des questions et rédiger du texte, ils peuvent aussi déclencher des actions, exécuter du code et interagir avec des environnements techniques), la génération de code et l’intégration dans des workflows agentiques.

En outre, ils offrent un haut degré de personnalisation. Typiquement, ils permettent aux entreprises d’effectuer du fine-tuning complet, c’est-à-dire de réentraîner le modèle avec leurs propres données pour ajuster le ton, la spécialisation ou la manière de raisonner de l’IA. Avec un tel « fine tuning » revient à modifier les paramètres internes du modèle. Cela permet par exemple de le spécialiser dans le jargon médical, juridique, technique — ou même dans des langues et registres rares. Il est même possible de personnaliser « l’effort cognitif » et donc de moduler la profondeur de raisonnement, le style de rédaction ou le type de réponses générées, selon le contexte et l’usage.

Autre atout, ces modèles sont conçus pour une orchestration agentique. Cela signifie qu’ils peuvent collaborer avec des outils externes, exécuter du code, utiliser des plugins ou des APIs, et même piloter d’autres agents, comme des agents qui interrogent des bases de données ou gèrent des actions métier. L’entreprise peut notamment décider dans quelles conditions le modèle “réfléchit longtemps”, agit vite, ou délègue une tâche.

Enfin, et surtout, ils fonctionnent sans connexion, une aubaine pour la souveraineté et les cas sensibles (notamment ceux exploitant des données sensibles).

De quoi inquiéter une concurrence aussi nombreuse que farouche que ce soit du côté des modèles propriétaires (OpenAI lui-même, mais aussi Google, xAI, Anthropic…) que du côté “ouverts” où Meta (Llama) et Mistral AI occupent déjà fortement l’espace (sans oublier DeepSeek R1, Moonshot AI, IBM Granite, Microsoft Phi, Google Gemma, etc.). C’est dans ce champ de bataille intense que les modèles « gpt-oss » vont devoir faire leurs preuves et démontrer à la fois leur simplicité de déploiement, leur capacité de personnalisation et surtout le coût total de possession.

Plus concrètement, ces modèles sont disponibles dès aujourd’hui sur Hugging Face, avec des guides officiels. OpenAI a bien préparé le terrain et s’est laissé le temps de séduire les partenaires. Outre Hugging Face, l’éditeur met aussi en avant GitHub pour les ressources et Ollama pour l’exécution locale. Ces modèles peuvent dès aujourd’hui aisément être hébergés sur Azure (via Azure AI Foundry) ou AWS (via bedrock). Mais OpenAI annonce aussi des partenariats avec AI Sweden, Snowflake… et même Orange ! Oui, le Français est dans la boucle dès le premier jour et annonce déjà un déploiement dans ses infrastructures de confiance pour des usages souverains.

Pour les DSI, cette annonce change quand même un peu l’équation tant les modèles d’OpenAI sont populaires. Soudain, l’option “on-prem/edge avec un modèle de rang quasi-propriétaire” devient crédible : moins de dépendance, meilleure maîtrise de la latence, des coûts d’inférence et de la conformité. En échange, il faudra assumer la complexité MLOps, la sécurité des modèles ajustés, la gouvernance des données et le pilotage des performances. Mais aussi se méfier d’un travers. Selon OpenAI, ses deux modèles ouverts disposent de solides protections contre les usages à risques (comme les menaces biologiques par exemple) mais en revanche ont une plus forte tendance à halluciner que leurs équivalents propriétaires. Avec une bonne personnalisation et un contexte bien défini, ce problème d’hallucination devrait toutefois être bien contrôlé.

À lire également :

OpenAI lance le « Mode Étudier » dans ChatGPT pour stimuler l’apprentissage par l’IA

OpenAI officialise le mode Agent de ChatGPT en France

Mistral AI lance sa première IA de raisonnement avec Magistral

Une IA d’OpenAI obtient la médaille d’or aux Olympiades de mathématiques

Avec Qwen 3, Alibaba compte détrôner Meta et DeepSeek dans l’univers des modèles IA ouverts

Meta dévoile Llama 4, nouvelle génération d’IA multimodale

Mistral AI se met à l’audio et lance Voxtral en open source

Phi-4, le nouveau petit modèle de Microsoft qui raisonne comme un grand

Le petit Granite 3.1 d’IBM rivalise avec les modèles géants de l’IA

puis

puis