A l’occasion de sa GPU Tech Conference (GTC) 2024, NVidia a dévoilé sa nouvelle architecture GPU pour l’IA dénommée Blackwell ainsi que de nouvelles plateformes logicielles pour simplifier l’appropriation de la Gen AI par les entreprises.

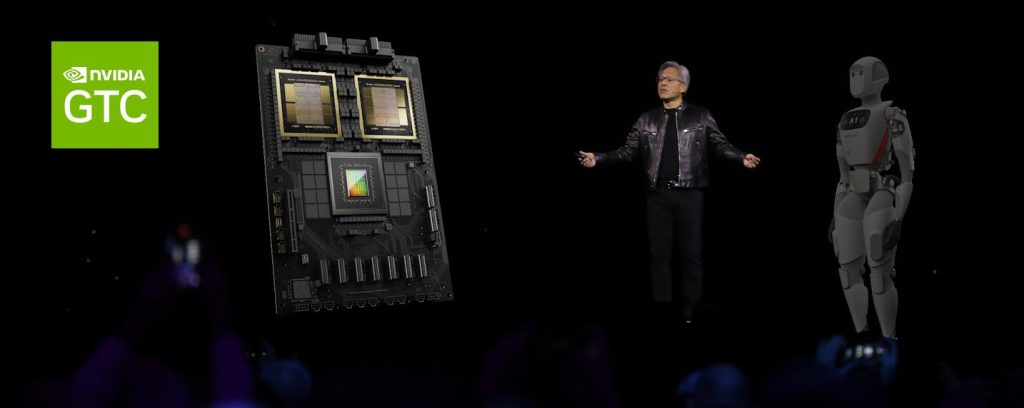

Accueilli comme une Rock Star par un public enthousiaste à l’occasion de son Keynote d’ouverture de la GTC 2024, la messe annuelle de NVidia, Jenseng Huang, CEO et fondateur de l’entreprise, a délivré une prestation hyper technique à l’exact opposé des prestations pompeuses et ultra-marketing d’un Tim Cook (CEO d’Apple). « J’espère que vous réalisez que ceci n’est pas un concert » a-t-il tancé d’emblée, ajoutant « il va y avoir beaucoup de science, d’algorithmes, d’architecture informatique et de mathématiques »…

À 61 ans, Jensen Huang n’a jamais paru aussi dynamique et plein d’énergie. Il est vrai qu’en l’espace d’une année, sa société est devenue la troisième valorisation mondiale. Mais plutôt que de célébrer les succès en Bourse et se livrer à l’autocomplaisance dont nous abreuve généralement le marketing à l’américaine, le CEO a choisi de s’adresser exclusivement aux développeurs et aux geeks. Avec du lourd, plein d’acronymes et des tas de mesures techniques…

Blackwell… The next step…

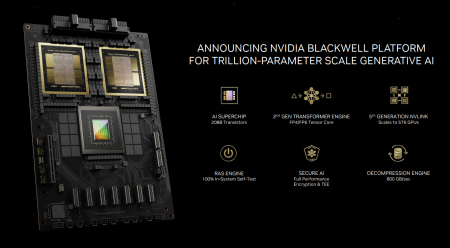

Blackwell s’annonce entre 2 et 30 fois plus rapide que Hopper, selon la façon de mesurer et les algorithmes employés. En gros, on peut s’attendre à une accélération x4 sur les phases d’apprentissage et à une accélération x30 sur les phases d’inférence.

Ainsi, alors qu’il fallait 8000 GPU H100, 15 mégawatts et 90 jours pour créer un modèle GPT de 1800 milliards de paramètres, il ne faut plus « que » 2.000 GPU et moins de 4 mégawatts pour réaliser le même entraînement avec Blackwell.

Tout comme NVidia a décliné Hopper en version H100, H200 (deux chips Hopper combinés sur une seule puce) et GH200 (deux GPU Hopper et un CPU Grace sur une seule puce), le Blackwell sera lui aussi décliné en version B100, B200 (deux GPU Blackwell réunis sur une seule puce) et GB200 (combinant deux GPU Blackwell et 1 CPU Grace sur la même puce).

On sait déjà que le B200 embarquera 192 Go de RAM HBM3e (contre 141 Go sur le H200) et offrira une bande passante interchip de 10 To/s, une bande passante mémoire de 8 To/s et une bande passante externe de 1,8 To/s.

Avec ses 208 milliards de transistors gravés en 4nm (par TSMC), le GPU Blackwell peut être qualifié de « méga chip ». Sans surprise on retrouve parmi les clients ayant déjà précommandé ces nouveaux GPU (qui ne sont pas encore disponibles) des acteurs comme AWS, Google, Microsoft, Meta, OpenAI, Oracle, Tesla et xAI… Que des américains !

Du super-computing IA à la clé

Apparemment Google Cloud devrait proposer des DGX SuperPOD à l’usage dans son nuage d’ici la fin de l’année.

Une plateforme pour unifier tous les modèles

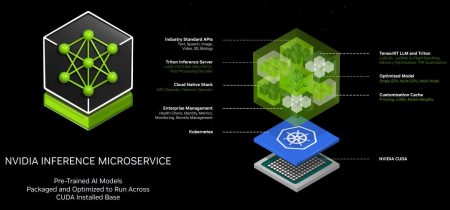

Au chapitre des grandes annonces, on retiendra du GTC 2024 l’annonce d’une plateforme « Nvidia NIM » conçue pour faciliter le déploiement de modèles d’IA personnalisés et pré-entraînés dans des environnements de production. Plus simplement, on peut voir NIM comme un conteneur rempli de microservices et que l’on peut configurer en un clic pour embarquer l’un des modèles supportés. La plateforme NIM est optimisée pour les modèles de NVidia, d’A121, d’Adept, de Cohere, de Getty Images, de Shutterstock, de Google, de Hugging Face, de Meta, de Microsoft, de Mistral AI et de Stability AI.

Par ailleurs, les microservices IA NIM devraient prochainement intégrer les plateformes Cloud de Microsoft (Azure AI Studio), de Google (Vertex AI) et d’AWS (SageMaker).

NVidia à l’ère des robots humanoïdes

Si toutes les attentions sont focalisées sur l’IA générative depuis 1 an déjà, NVidia n’en oublie par pour autant que ses GPU pourraient aussi animer l’autre révolution technologique du moment dont les progrès sont au moins aussi rapides que la Gen AI : les robots humanoïdes !

Et même un peu de quantique à la clé

NVidia a lancé son propre service cloud « NVidia Quantum Cloud » basé sur sa plateforme open-source CUDA-Q. Quantum Cloud ne donne pas encore accès à des machines physiques mais à des simulateurs permettant de développer et tester des algorithmes quantiques en Cuda-Q. Reste désormais à NVidia de convaincre les actuels créateurs de processeurs et de machines quantiques d’adopter la plateforme Cuda-Q. Et pour l’instant NVidia n’a rien de concret à proposer. La firme se contente d’expliquer que IonQ, IQM, OQC, Orca, qBraid ou encore Quantinuum ont exprimé leur intérêt pour cette plateforme. Ça n’engage à rien…

Bref, NVidia a plus que jamais le vent en poupe et le regard fixé sur le futur… Un atout alors que ses concurrents ont eux le regard tourné vers NVidia et le retard qu’ils ont à rattraper… Même s’ils ne sont pas forcément très loin techniquement parlant (AMD avec son Instinct MI300 et Intel avec ses Gaudi3 et Loihi 2).

puis

puis