NVidia annonce son nouveau GPU H200 attendu comme le messie par tous les acteurs des IA génératives en quête de nouveaux sommets de performances et de chatbots conversationnels plus réactifs.

Né avec le jeu vidéo et les applications 3D professionnelles de la CAO/DAO, NVidia est devenu un des géants mondiaux du marché des puces, et joue désormais un rôle pivot dans les datacenters et l’univers de l’intelligence artificielle (IA).

Alors qu’OpenAI et Microsoft ne cessent d’expliquer que la pénurie de GPU sur le marché freine leurs capacités à accélérer le fonctionnement de ChatGPT et de Bing AI, l’introduction du GPU H200 est perçue comme une annonce importante dans le monde de l’IA. Ce nouveau GPU, toujours basé sur l’architecture Hopper, succède au H100 et représente le sommet de la technologie AI de Nvidia. Il offre des capacités de traitement de données et une vitesse significative améliorées et essentielles pour entraîner et inférer les grands modèles de langage (LLMs) et les nouvelles IA de génération d’images (StableDiffusion, Dall-E, Midjourney, Adobe Firefly…).

Un GPU qui décoiffe les IA

Le H200 se distingue notamment par sa mémoire HBM3e, offrant une bande passante de 4,8 téraoctets par seconde et une capacité de 141 Go, ce qui représente une amélioration de 40% de la bande passante et de 80% de la capacité mémoire par rapport à son prédécesseur, le H100. NVidia annonce que le H200 se montre deux fois plus performant pour inférer LLama 2 (le LLM open source à 70 milliards de paramètres signé Meta) que le H100.

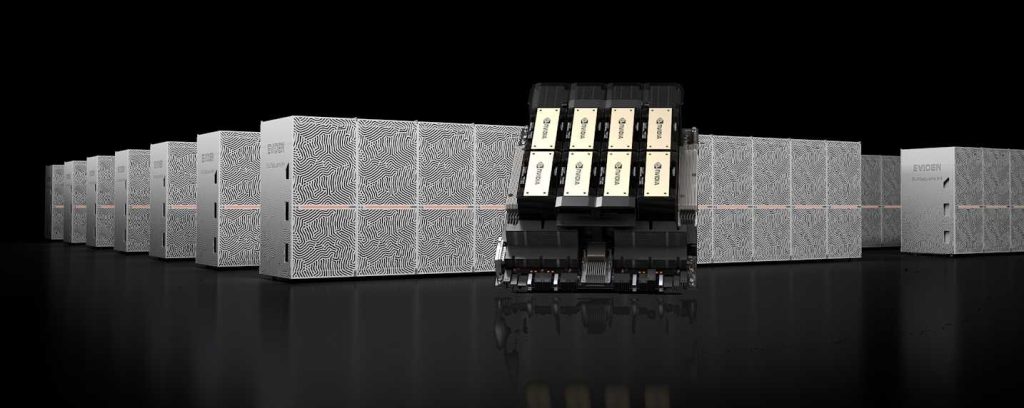

Les H200 sont principalement destinés à intégrer des cartes Nvidia HGX H200 combinant 4 à 8 GPU H200. Un HGX H200 à 8 GPU délivre plus de 32 pétaflops de calcul d’apprentissage profond FP8 et 1,1 To de mémoire agrégée à large bande passante pour les performances les plus élevées dans les applications d’IA générative et de HPC. NVidia précise que les systèmes actuels en H100 pourront aisément être upgradés en H100.

Officiellement, les H200 ne seront disponibles qu’au second trimestre 2024 pour une intégration dans les fournisseurs de serveurs. Mais certains hyperscalers cloud pourraient en bénéficier un peu avant.

Le JUPITER en GH200

Il y a quelques semaines, le consortium EuroHPC confirmait que son premier supercalculateur éxaflopique, le JUPITER du JSC de Jülich en Allemagne serait animé par le CPU novateur Rhea-1 des Français de SiPearl. Il avait également laissé entendre que ces CPU seraient secondés par des GPU NVidia sans donner de précision.

NVidia a confirmé à l’occasion du lancement des GPU H200 que le JUPITER bénéficierait effectivement de la nouvelle génération de GPU ou plus exactement de sa version dérivée « GH200 Grace Hopper Superchip ». Ce « superchip » combinant CPU « Grace » et GPU « H200 » en un seul package sera la base de ce qu’on appelle le « Booster Module » du JUPITER (dit autrement, les processeurs SiPearl n’équiperont que le General Cluster Module). Ce Booster Module se composera d’environ 24000 Superchips GH200.

Selon NVidia, ainsi équipé, le JUPITER proposera une puissance HPC de 1 exaflops (en calculs à virgule flottante sur 64 bits) mais de 90 exaflops en apprentissage IA (soit 45 fois la performance du booster de l’actuel JUWELS du JSC).

puis

puis