À l’occasion du GTC 2022, NVidia a sorti le grand jeu avec de nouveaux GPU aux performances ébouriffantes, un nouveau Soc et un super-CPU à 144 cœurs basés sur son design ARM « Grace » !

À l’occasion de sa conférence GTC 2022, NVidia a tenu à faire oublier le capotage du rachat d’ARM en noyant les participants d’annonces et leur en mettant plein la vue. Le grand jeu en somme. Mais également la preuve que l’entreprise n’est pas affectée par l’échec ARM et poursuit sa course folle à la puissance.

Un nouveau GPU aussi puissant que gourmand

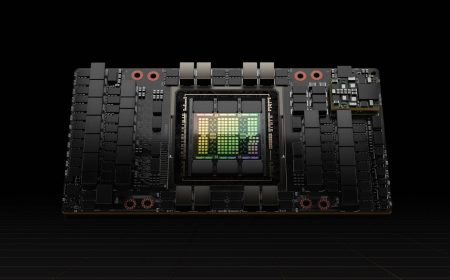

La première star de la conférence n’est autre que le GPU « H100 » destiné à remplacer les A100 dans les infrastructures de serveurs NVidia DGX spécialement pensées pour accélérer les applications Deep Learning. Le H100 s’appuie sur la nouvelle architecture GPU « Hopper » de NVidia (qui succède à l’architecture Ampère des A100). Elle embarque 16.896 cœurs CUDA-FP32 (contre 6.912 pour le A100 et 5.120 pour le V100) ainsi que 528 « Tensor Cores » (contre 432 pour le A100). La bande passante mémoire atteint les 3 To/sec. Le GPU affiche ainsi une puissance de 60 TFLOPS en FP32 (calculs en virgule flottante sur 32 bits) et 30 TFLOPS en FP64 (calculs en virgule flottante sur 32 bits).

Pour donner une idée de la performance, NVidia affirme qu’il suffirait de 20 GPU H100 pour gérer l’intégralité du trafic Internet mondial. Mais la vocation du GPU est avant tout l’intelligence artificielle et les univers 3D des métavers. Ce nouveau GPU introduit ainsi des moteurs IA pour les nouveaux modèles deep learning de type « transformeur » (aussi appelé modèles auto-attentifs) plus particulièrement utilisés en NLP (traitement du langage naturel). Grâce à ces nouveaux moteurs intégrés au GPU, les sessions d’entraînement qui prenaient plusieurs semaines se mesureront désormais en jours. Hopper introduit également un nouveau jeu d’instructions DPX pour la programmation dynamique qui accélère jusqu’à 40 fois certains algorithmes complexes comme celui du repliement des protéines.

Une telle performance se paye cependant au prix fort en termes de consommation d’énergie. Dans sa version maximale, le H100 affiche un TDP de 700 Watts ! Une telle enveloppe thermique laisse assez perplexe sur le mécanisme de refroidissement à intégrer aux serveurs qui en seront équipés !

Dans la foulée, NVidia a également annoncé sa nouvelle génération de serveurs « DGX ». Les NVidia DGX H100 embarquent 8 GPU H100 et affiche une performance de 32 Pétaflops en précision FP8.

Autre annonce, celles d’un nouveau HPC basé sur un hardware dénommé EOS basé sur les GPU H100 et des DGX SuperPOD H100. Ce nouveau système délivre une performance de 275 pétaflops en FP64 et 18,4 exaflops sur des workloads IA en FP8 ! Son assemblage sera terminé dans 7 mois.

144 cœurs ARM dans une seule puce !

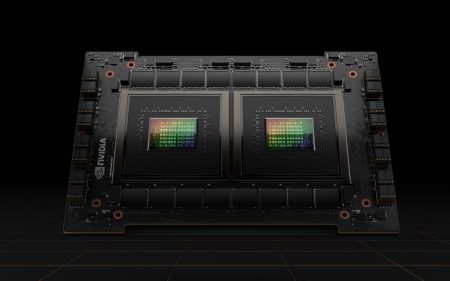

La seconde vedette du show fut le « Grace Superchip », un CPU pensé pour les serveurs et les datacenters. Le « Grace Superchip » est une version bicéphale du CPU « Grace » partiellement dévoilé en avril 2021. À l’époque NVidia affirmait que Grace était « le fruit de plus de 10 000 années de travail d’ingénierie » et allait offrir « des performances 10 fois supérieures à celles des serveurs les plus rapides d’aujourd’hui sur les charges de travail IA et les calculs haute performance les plus complexes ». Mais le fabricant n’avait pas donné plus de détails.

Désormais, on en sait beaucoup plus même si Nvidia perd un peu tout le monde dans le nommage de ces processeurs. Car le « Grace Superchip » est un CPU composé de deux CPU « Grace » relié par un mécanisme de liaison ultra-rapide NVlink-C2C. Cela vous rappelle quelque chose ? Pas surprenant. Ce Grace Superchip adopte une approche en tout point similaire à celle d’Apple dont le nouveau processeur M1 Ultra est lui aussi composé de deux CPU M1 Max packagés ensembles et reliés par un mécanisme d’interconnexion maison dénommé UltraFusion.

La comparaison s’arrête cependant là. Car le Grace Superchip est une bête de course d’un tout autre niveau qui promet de donner du fil à retordre aux dernières générations de processeurs pour serveur AMD Epyc et Intel Xeon Scalable même s’il n’arrivera pas avant 2023. Basé sur un processus de gravure 4 nm de TSMC, il s’appuie sans surprise sur l’architecture Neoverse N2 d’ARM et propose au total 144 cœurs de calcul ! NVidia annonce également une bande passante mémoire approchant les 1 To/sec (avec de la RAM LPDDR5X). Le processeur est spécialement pensé pour les Workloads d’apprentissage d’IA et une nouvelle génération de modèles NLP s’appuyant sur plus de 1.000 milliards de paramètres !

Par ailleurs, NVidia a annoncé également décliner son processeur Grace avec un SoC « Grace Hopper Superchip » composé d’un CPU « Grace » et d’un GPU « Hopper » de nouvelle génération.

Ce SoC promet de délivrer 10 fois la puissance des systèmes NVidia DGX actuels combinant des CPU x86 (AMD Epyc) et des GPU A100. Au passage on saluera le clin d’œil de NVidia à Grace Hopper, informaticienne américaine conceptrice du premier compilateur (en 1951) et créatrice du langage Flow-Matic qui inspira en 1959 le langage COBOL. Grace Hopper est souvent désignée sous le nom de « mère du Cobol ».

À lire également :

ARM confirme l’échec de son rachat par NVidia

CES 2022 : NVidia veut donner vie au Metaverse avec son Omniverse…

NVidia annonce » Grace « , son processeur ARM pour serveurs

Windows sur ARM : encore beaucoup de chemin à parcourir

Apple lance un nouveau Mac Studio avec un processeur « M1 Ultra »

puis

puis