Toujours en attente de validation du rachat d’ARM, NVidia se lance officiellement sur le marché des CPU pour datacenters avec un processeur « Grace » spécialisé pour les workloads IA et les HPC ?

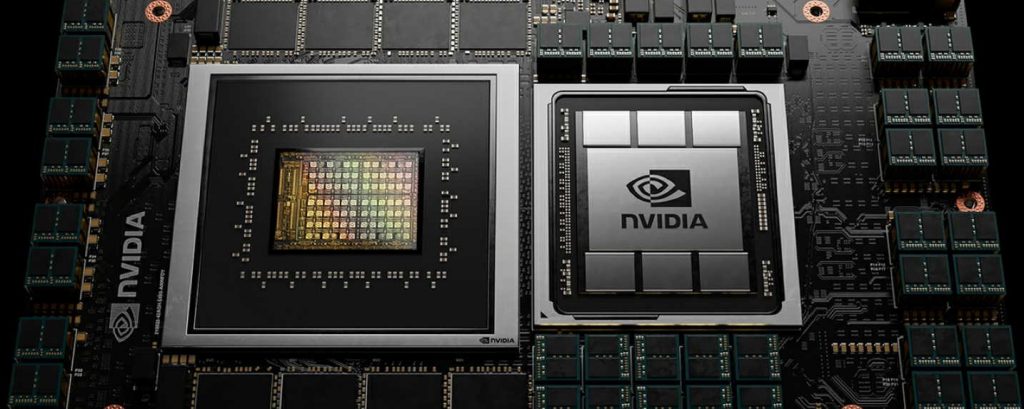

NVidia est surtout connu pour ses GPU et ses processeurs réseau de traitement de données DPU (BlueField). Le fabricant attend toujours l’aval des autorités administratives et financières dans sa quête d’acquérir la société ARM pour la somme de 44 milliards de dollars. En attendant, la firme ne reste pas immobile et annonce « Grace », son premier processeur ARM destiné aux serveurs.

Il faut rappeler que NVidia n’est un novice ni dans l’univers des CPU, ni dans l’univers des architectures ARM. Depuis plusieurs années, le fabricant développe son propre processeur SOC ARM, dénommé Tegra X1/X2, qui équipe sa console-box Shield mais aussi la très populaire console Switch de Nintendo.

Cependant, Grace est un pur CPU aux prétentions autrement plus ambitieuses que le SoC Tegra. Il est spécifiquement conçu pour animer des serveurs et spécialement pensé pour la prochaine génération de réseaux neuronaux de Deep Learning et de modèles NLP reposants sur des milliers de milliards de paramètres.

Selon NVidia, ce nouveau CPU est « le fruit de plus de 10 000 années de travail d’ingénierie » et offrira « des performances 10 fois supérieures à celles des serveurs les plus rapides d’aujourd’hui sur les charges de travail IA et les calculs haute performance les plus complexes ».

Conçu pour être combiné aux accélérateurs GPU NVidia (tel le Ampere GA100/Tesla A100), le CPU exploite la quatrième génération de liens d’interconnexion NVLink (bande passante de 900 Go/sec entre le CPU et le GPU) et utilise un sous-système mémoire LPDDR5x offrant deux fois plus de bande passante que les mémoires DDR4 pour une efficacité énergétique 10 fois supérieure.

En revanche, on ignore le nombre de cœurs embarqués dans Grace. On sait seulement que le CPU s’appuie sur l’architecture ARM Neoverse sans autre précision.

NVidia semble dans un premier temps vouloir essentiellement dédier son processeur « Grace » aux architectures HPC et n’a pas dévoilé ses intentions quant à une utilisation plus universelle sur des serveurs Cloud à l’instar du Graviton 2 d’AWS (Amazon développe son propre processeur), du ThunderX2 de Marvell ou de l’Altra d’Ampere.

– un futur HPC destiné au Los Alamos National Laboratory (LANL) mais qui n’est pas le Crossroads (attendu en 2022 à base Intel)

– et surtout le ALPS du CSCS (Swiss National Supercomputing Center) d’une puissance attendue de 20 ExaFLOPS sur les traitements IA.

Au passage, on notera donc que HPE adapte son architecture Cray-EX au nouveau CPU d’AMD en complément des AMD Epyc et des Intel Xeon Scalable.

puis

puis