Générer un univers jouable en quelques secondes n’est plus de la science-fiction. L’IA Genie 3 de Google DeepMind façonne des espaces immersifs qui évoluent à la demande et redéfinissent la manière d’imaginer simulation et entraînement.

La production 3D s’ouvre à de nouveaux publics grâce à l’IA et sa capacité à générer objets et mondes 3D à partir d’images 2D ou de descriptions textuelles. La semaine dernière, nous évoquions la dernière innovation de Microsoft AI, Copilot 3D, un service web qui convertit une image 2D (JPG/PNG) en modèle 3D téléchargeable au format GLB, utilisable dans les visionneuses, outils de conception et moteurs de jeu. L’outil est gratuit avec un compte Microsoft, ne s’appuie pas sur les images téléversées pour entraîner ses modèles, conserve les créations 28 jours et reste, à ce stade, focalisé sur la conversion d’une image unique plutôt que sur la génération par prompt texte. Un positionnement d’idéation rapide, utile pour prototypage et assets « brouillons ».

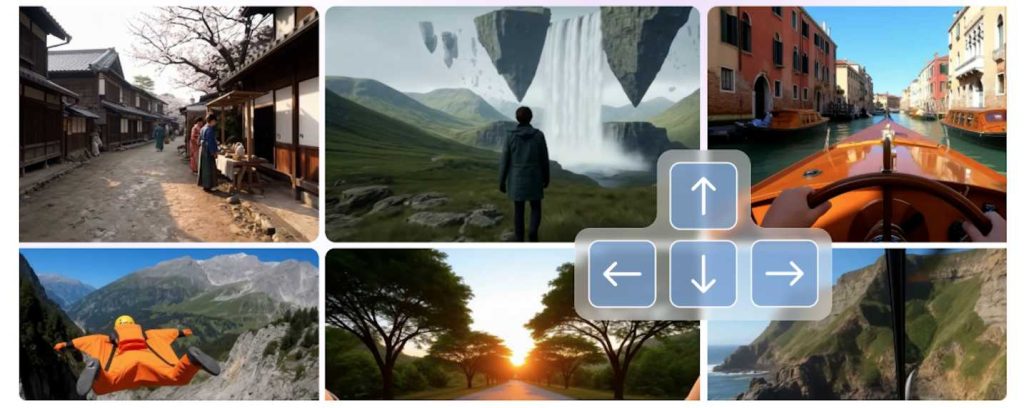

Dans un contexte plus large, l’IA paraît chaque jour un peu plus « magique » à tous ceux qui manipulent des univers 3D. Au lieu de les laisser empiler assets et réglages, elle propose des environnements prêts à explorer ou à modifier. Dans ce cadre, la génération ne remplace pas les pipelines classiques mais accélère la boucle essai‑erreur, démultiplie les variantes et dépanne sur des besoins ponctuels. Ces modèles génératifs d’univers 3D se distinguent des IA vidéo (qui produisent des clips figés) et des simulateurs 3D classiques (qui exigent scènes et assets prédéfinis) : ici, l’environnement est généré « à la demande ».

Genie 3, le nouveau « world model » de DeepMind s’inscrit dans cette dynamique mais avec une ambition différente : ce modèle de monde généraliste simule des environnements interactifs en temps réel. À partir d’un prompt texte, Genie 3 génère des mondes explorables au clavier/souris en 720p à 24 images/s, cohérents pendant plusieurs minutes. La nouveauté clé tient à la « mémoire » visuelle de la scène et aux « événements pilotables par prompt » permettant de faire évoluer météo, objets ou personnages au fil de l’exploration. Le projet est publié en recherche limitée auprès d’un petit groupe d’universitaires et créateurs, avec une insistance marquée sur la responsabilité et la sécurité dès la conception.

« Genie 3 est le premier ‘world model’ généraliste interactif en temps réel », résume Shlomi Fruchter chercheur IA chez DeepMind. L’objectif dépasse ici le cadre stricte du jeu vidéo. Le modèle vise à fournir des environnements variés pour entraîner, tester et faire progresser des agents capables de planifier et d’apprendre par l’expérience.

De nouveaux usages pour la 3D dopée à l’IA

Côté R&D, Genie 3 a déjà été évalué avec le modèle d’agent généraliste SIMA, chargé d’atteindre des objectifs dans des mondes générés. La stabilité temporelle du modèle de Google permet d’enchaîner des actions plus longues et d’évaluer la robustesse des comportements.

Pour les secteurs éducation/formation et robotique, la génération « on‑demand » offre un gisement d’exercices et de scénarios « et si ? » sans coûts d’asset ni préparation de scène, tout en gardant à l’esprit que les lieux réels ne sont pas reproduits avec exactitude géographique.

À plus long terme, la communauté VR y voit un candidat crédible pour générer en temps réel des mondes photoréalistes interactifs, même si des contraintes d’entrées/sorties (6DoF, stéréoscopie, latence, audio) restent à résoudre.

Un outil dont les contours restent à explorer

Dit autrement, Genie 3 n’est pas un moteur de jeu ni un jumeau numérique clé en main : c’est un modèle génératif temps réel avec un horizon d’interaction de quelques minutes et un espace d’actions encore limité.

Les interactions multi‑agents restent un défi, la lisibilité du texte in‑scene n’est pas garantie et la capacité à « coller » à un lieu réel ou à des spécifications détaillées n’est pas dans les préoccupations actuelles de ses créateurs.

Pour l’instant, l’accès se fait sous contrôle via une préversion de recherche, ce qui cadre les risques et l’exposition des données.

Si Copilot 3D illustre l’abaissement de la barrière d’entrée pour créer rapidement des objets 3D à partir d’images, Genie 3, lui, déplace le débat : il ne produit pas seulement des assets, il simule des mondes avec cohérence et réactivité, pour servir l’entraînement et l’évaluation d’agents, avec un positionnement assumé de jalon vers des IA plus générales. Pour les organisations, l’enjeu est d’anticiper l’intégration de ces modèles de monde dans les chaînes de production, de test et de sécurité, en tenant compte de leurs limites actuelles.

puis

puis