NetApp AFX est la nouvelle offre de stockage 100 % flash (all-flash) conçue pour les workloads massifs de l’IA annoncée par NetApp la semaine dernière à l’occasion de son NetApp Insight 2025. Sa caractéristique principale est d’introduire une architecture de stockage désagrégé pour la plateforme ONTAP, conçue spécifiquement pour les charges de travail d’intelligence artificielle à grande échelle.

Pour NetApp, l’annonce de ses nouvelles baies NetApp AFX est sans doute l’une des plus stratégiques de ces dernières années. Elle officialise l’entrée de l’entreprise sur le marché croissant du stockage désagrégé, une tendance architecturale inaugurée par VAST Data avant d’être adoptée par d’autres dont Pure Storage.

Il est essentiel de comprendre qu’AFX n’est pas un simple rebranding : c’est une base matérielle entièrement nouvelle conçue pour « l’exascale » qui permet à NetApp de combiner la scalabilité horizontale (scale-out) exigée par l’IA avec la robustesse, la sécurité et la richesse fonctionnelle de son système d’exploitation ONTAP, éprouvé par des dizaines de milliers d’entreprises. La gamme AFX vient ainsi compléter les baies AFF, ASA et FAS ainsi que les Cloud Volumes ONTAP.

Pour les DSI, l’importance d’AFX réside dans sa flexibilité fondamentale. L’architecture désagrégée dissocie les ressources de calcul (performance) des ressources de stockage (capacité). Concrètement, une entreprise peut désormais faire évoluer indépendamment ces deux aspects : ajouter de la capacité de stockage sans être obligée d’ajouter de la puissance de contrôleur, ou inversement. Cette granularité permet un dimensionnement plus juste (« right-sizing ») et évite les goulots d’étranglement, ce qui est crucial pour les « usines à IA » (AI factories) qui ont des besoins massifs et fluctuants. Les DSI bénéficient ainsi d’une évolutivité quasi illimitée tout en conservant l’écosystème ONTAP familier, sa cyber-résilience et son intégration hybride multicloud. AFX est d’ailleurs certifié pour l’infrastructure NVIDIA DGX SuperPOD.

Du désagrégé pour l’IA

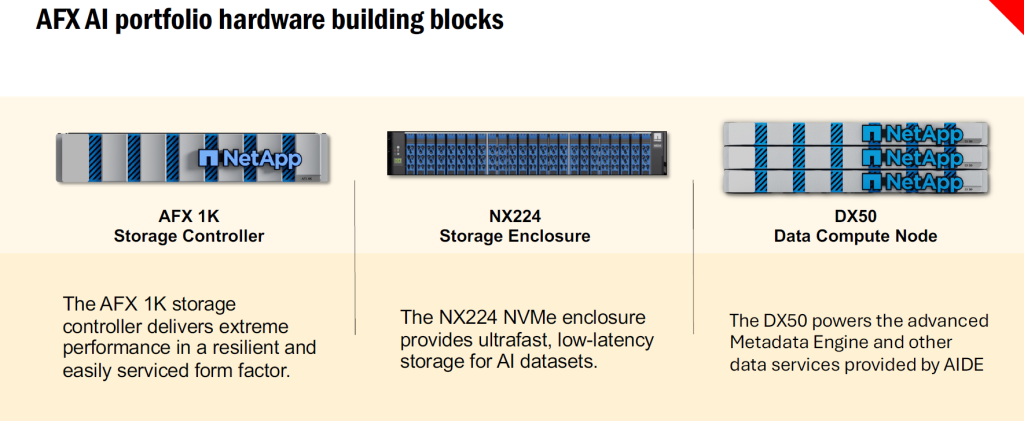

Techniquement, l’architecture modulaire d’AFX repose sur trois types de composants matériels interconnectés par un réseau interne à très haute vitesse, basé sur des liens NVLink et InfiniBand, optimisés pour les charges IA.

1 – Le « cerveau » est le contrôleur de stockage AFX 1K, un châssis 2U qui exécute une version désagrégée du logiciel ONTAP, séparant les fonctions de contrôle, de calcul et de capacité. Ce contrôleur gère les métadonnées, les services de données (SnapMirror, FlexClone, chiffrement, QoS) et orchestre le trafic entre les composants.

2 – La capacité de stockage est fournie par des boîtiers NX224, des tiroirs 2U ultra-denses contenant jusqu’à 24 SSD NVMe U.2, avec une connectivité PCIe Gen4, assurant une latence minimale et un débit maximal. Ces tiroirs sont conçus pour une haute disponibilité avec double contrôleur, redondance d’alimentation et chemins multiples.

3 – Les nœuds de calcul de données DX50 sont théoriquement optionnels et peuvent être ajoutés pour exécuter des fonctions avancées comme la vectorisation, la recherche sémantique ou le traitement RAG (Retrieval-Augmented Generation), en s’appuyant sur des GPU NVIDIA et des microservices IA intégrés. Ces nœuds permettent de rapprocher le calcul au plus proche des données, réduisant les temps d’accès et optimisant les performances des pipelines IA.

Un cluster AFX peut agréger jusqu’à 128 contrôleurs AFX 1K, atteignant une capacité à l’échelle de l’exaoctet et une bande passante de plusieurs téraoctets par seconde, avec une scalabilité linéaire et une gestion centralisée via le plan de contrôle ONTAP.

Une nouvelle couche logicielle pour l’IA

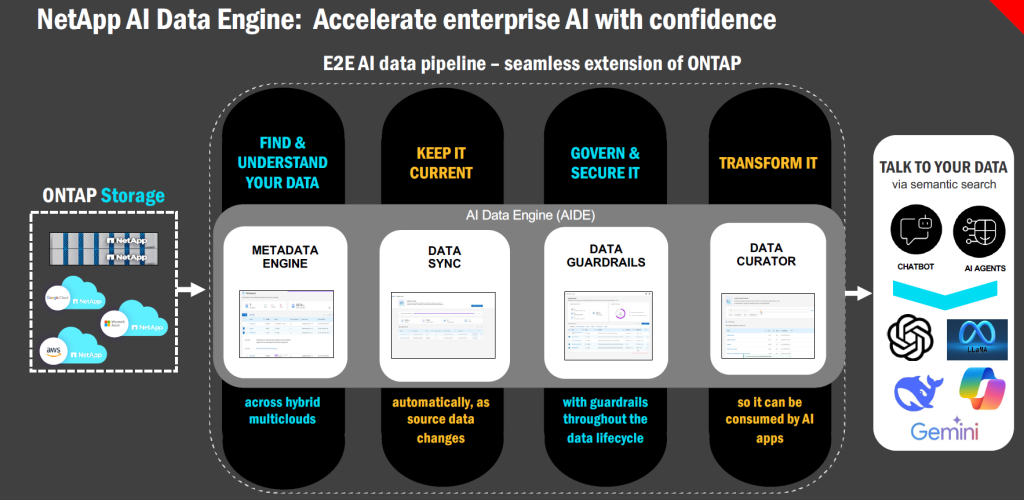

L’une des grandes originalités de l’approche AFX de NetApp réside dans les nœuds DX50 dotés de GPU NVidia. Ils trouvent toute leur raison d’être avec la toute nouvelle offre logicielle NetApp AI Data Engine (AIDE) qui complète parfaitement l’architecture matérielle AFX. AIDE est présenté comme une extension sécurisée et unifiée d’ONTAP conçue pour simplifier et accélérer l’ensemble du pipeline de données IA, de l’ingestion à la préparation. L’AI Data Engine s’exécute nativement au sein du cluster AFX, sur ces nœuds de calcul DX50.

Le rôle d’AIDE est de centraliser plusieurs étapes de préparation des données directement au niveau du stockage, appliquant le principe « amener l’IA aux données ». Il maintient un catalogue de métadonnées global en temps réel sur l’ensemble du patrimoine de données NetApp (sur site et cloud). Surtout, il automatise la transformation des données, notamment la vectorisation (conversion de données non structurées en vecteurs pour les LLM) et la recherche sémantique, en s’appuyant sur les technologies NVIDIA (comme les microservices NIM). Il intègre également des « garde-fous » (guardrails) pour la sécurité et la confidentialité des données tout au long du cycle de vie de l’IA.

En combinant le matériel AFX (pour la performance et la capacité désagrégées) et le logiciel AIDE (pour la préparation intelligente des données intégrée), NetApp propose ainsi une plateforme unifiée qui rend les données d’entreprise immédiatement « prêtes pour l’IA » , accélérant ainsi drastiquement les projets d’inférence et de RAG (génération augmentée par récupération) mais aussi ceux d’entraînement et de fine-tuning des modèles.

puis

puis