AWS muscle son cloud pour l’IA avec la disponibilité massive de son Trainium3, une puce 3 nm pensée pour l’IA à grande échelle, et prépare déjà un Trainium4. Avec comme volonté non seulement de réduire ses propres coûts d’entraînement et d’inférence de l’IA mais également proposer aux clients des solutions à même de concurrencer Nvidia sur le terrain du rapport « coût/performance ».

AWS a lancé ce soir sa grande conférence annuelle AWS Re:Invent avec une pléthore d’annonces autour de l’IA notamment agentique. Nous reviendrons demain et le reste de la semaine sur les multiples annonces que l’hyperscaler a commencé et continuera de faire durant les 4 jours de son évènement phare. Mais nous commençons dès ce soir par les annonces non pas d’une nouvelle puce mais de deux !

AWS annonce l’arrivée imminente de son accélérateur Trainium3 mais lève aussi déjà le voile sur son successeur, le Trainium4.

À l’échelle des hyperscalers, le calcul est très simple : chaque point de pourcentage gagné sur le coût par jeton généré ou par heure de training se traduit en centaines de millions de dollars sur la durée de vie d’une génération de chip. En développant leurs propres accélérateurs, les clouds peuvent optimiser la chaîne complète – du design de la puce jusqu’à la couche logicielle – et capturer une partie de la valeur aujourd’hui captée par Nvidia et, dans une moindre mesure, AMD.

Cette intégration verticale permet de concevoir des puces taillées pour leurs workloads réels, pour leurs frameworks logiciels (Neuron chez AWS, XLA/TPU chez Google, etc.) et pour leur modèle économique : instance EC2, service managé type Bedrock, ou désormais AI Factories on-prem. Elle offre aussi un levier de négociation non négligeable vis-à-vis de Nvidia, tout en laissant les GPU en première ligne pour les workloads les plus exigeants ou pour les clients qui tiennent à l’écosystème CUDA. AWS a d’ailleurs annoncé de nouvelles machines P6e à base de superpuces Nvidia GB200/GB300 (combinant CPU ARM et GPU Blackwell) et des machines P6 à base de GPU B200/B300.

AWS a été un pionnier de l’approche « des puces ‘maison’ pour mon Cloud ». Après Graviton sur le CPU généraliste, le cloud d’Amazon a introduit depuis plusieurs années déjà Inferentia pour l’inférence, puis Trainium pour le training de modèles de plus en plus massifs.

Ces puces « maison » équipent déjà des instances EC2 spécialisées (les Trn1, Trn2…) et, surtout, les backends de services managés comme Amazon Bedrock. Parallèlement, avec le projet Rainier, AWS a mis en production un cluster de près de 500 000 Trainium2 pour Anthropic, présenté comme l’un des plus grands supercalculateurs IA au monde et cinq fois plus vaste que l’infrastructure utilisée pour la génération précédente de modèles Anthropic. AWS indique désormais avoir déployé plus d’un million de processeurs Trainium et affirme les écouler « aussi vite qu’ils sortent de fab ».

D’autant que ces puces maison ne sont pas réservées aux usages maison. Elles cherchent aussi à offrir aux clients AWS le meilleur ration « prix-performance » du marché.

Avec son tout nouveau Trainium3, AWS veut offrir le meilleur ratio coût/perf sur les gros entraînements et sur l’inférence à grande échelle, les GPU Nvidia restant bien évidemment disponibles pour les charges où ils conservent un avantage ou pour les équipes qui ont standardisé leur toolchain dessus.

Trainium3 : premier chip 3 nm d’AWS

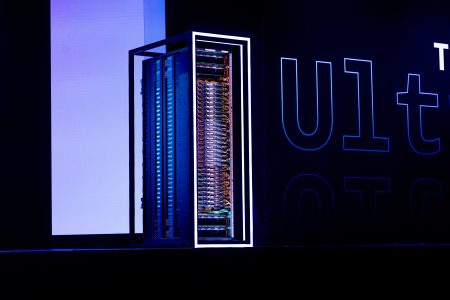

Trainium 3 est la première puce IA d’AWS gravée en 3 nm. Elle est au cœur des nouveaux Amazon EC2 Trn3 UltraServers, qui constituent la brique de base de la génération actuelle d’infrastructures IA du cloud (cf plus loin).

Par rapport aux Trainium2, AWS annonce pour Trainium3 :

* jusqu’à 4,4 fois plus de puissance de calcul,

* une efficacité énergétique multipliée par quatre (x4),

* presque quatre fois plus de bande passante mémoire,

* et une latence de communication divisée par quatre entre puces.

Trainium pour l’inférence : un usage déjà massif

Contrairement à ce que laisse penser le branding, Trainium n’est plus un chip cantonné au training. AWS insiste sur le fait que Trainium3 est aussi pensé comme un moteur d’inférence de premier plan, et commence à détailler quelques cas d’usage.

AWS explique en effet que plus de la moitié de la capacité d’inférence d’Amazon Bedrock, la plateforme de modèles fondation managés d’AWS (Model as a Service), tourne déjà sur des puces Trainium. Trainium3 a été d’emblée conçu pour les deux usages (entraînement ET inférence). Bedrock sert déjà des workloads de production sur Trainium3, signe que la puce n’est plus un prototype mais une brique déjà largement déployée.

Selon AWS, des clients comme Anthropic, Karakuri, Metagenomi, Neto.ai, Ricoh ou Splashmusic ont réduit leurs coûts de training et d’inférence jusqu’à 50 % en migrant sur Trainium. Le laboratoire Decart, spécialisé dans la vidéo générative temps réel, revendique de son côté une inférence vidéo quatre fois plus rapide qu’avec des GPU classiques, pour un coût divisé par deux, ce qui ouvre la voie à des expériences interactives qui étaient encore difficilement finançables il y a un an.

UltraServers Trn3 : la réponse d’AWS aux superpods GPU

Avoir un puissant accélérateur IA, c’est bien. Le mettre à des dispositions des clients, c’est mieux. Pour ça, il faut des machines qui en soient équipées. Les Trainium3 UltraServers ne sont pas de « simples » serveurs à base d’accélérateurs : AWS parle de système verticalement intégré, du chip au réseau, jusqu’à la pile logicielle.

Chaque « Trn3 UltraServer » peut embarquer jusqu’à 144 puces Trainium 3, pour atteindre 362 PFLOPS FP8 dans un seul système intégré. AWS met en avant des optimisations d’architecture (nouveaux circuits d’interconnexion, hiérarchie mémoire revue) et surtout un nouveau composant réseau, le NeuronSwitch-v1, qui double la bande passante interne, couplé à un tissu Neuron Fabric qui ramène la latence inter-chip sous les 10 microsecondes. Ces blocs peuvent ensuite être agrégés dans des EC2 UltraClusters 3.0 qui vont jusqu’à 1 million de puces Trainium3 interconnectées, soit dix fois plus que la génération précédente !

Concrètement, cela permet de réduire les temps d’entraînement de modèles open-weight de type GPT-OSS d’un facteur pouvant atteindre trois, tout en divisant par quatre le temps de réponse sur l’inférence par rapport à la génération précédente de Trainium2 UltraServers.

De quoi, pour vos équipes IT, raccourcir drastiquement les cycles d’expérimentation sur les grands modèles maison et absorber des pics de trafic IA (chatbots, agents, recherche sémantique, vidéo générative) avec un nombre réduit de serveurs, donc un TCO plus maîtrisé.

Sur le plan du positionnement, ces UltraServers jouent dans la même cour que les superpods Nvidia (GB200/GB300 NVL72) ou les pods TPU de Google : de la puissance de feu destinée aux modèles fondation multi-trillions de tokens, aux MoE et aux architectures agentiques nécessitant des échanges de données permanents entre milliers de workers.

Biensûr, AWS reste un très gros client de Nvidia, mais veut faire de Trainium 3 « la » référence en termes de prix-performance sur les grands entraînements et sur l’inférence massive. Et l’hyperscaler a l’air très motivé pour soigner sa compétitivité.

Trainium4 : une roadmap déjà calée sur la prochaine génération

Alors que Trainium3 entre tout juste en disponibilité générale, AWS choisit déjà de donner de la visibilité sur Trainium4. Le futur chip est annoncé avec au moins 6 fois plus de performance en FP4, jusqu’à 3 fois plus de performances FP8, quatre fois plus de bande passante mémoire et une capacité HBM doublée par rapport à Trainium3.

AWS met aussi en avant un objectif d’efficacité énergétique doublée, ce qui est loin d’être anecdotique pour des clusters à plusieurs centaines de mégawatts.

Surtout, Trainium4 sera étroitement couplé à l’écosystème Nvidia grâce à l’intégration de NVLink Fusion, permettant de relier à très haut débit GPU Nvidia, Trainium4 et CPU Graviton au sein de racks MGX communs. Une démarche surprenante mais pas forcément unique. Après tout, les « AI Hypercomputers » de Google accueillent déjà un mixte de GPU Nvidia et de TPU maison.

Une stratégie silicon assumée

Vu depuis une DSI, l’annonce Trainium3/Trainium4 n’est pas qu’un sujet de benchs. Elle consacre un basculement : les grands clouds ne se contentent plus d’acheter des GPU, ils construisent leur propre roadmap de silicon, synchronisée avec leurs roadmaps de services managés et avec les grands contrats « AI at scale » (Anthropic, Humane/HUMAIN, grands ministères, opérateurs télécoms, etc.).

Pour AWS, les Trainium3 UltraServers doivent devenir l’option naturelle pour tout ce qui ressemble à un entraînement de modèle fondation ou à de l’inférence intensive, que ce soit sur Bedrock, sur SageMaker ou dans des environnements managés de type AI Factory. En annonçant déjà Trainium4, AWS signale parallèlement à ses clients qu’il ne s’arrêtera pas à une génération opportuniste : la roadmap est multi-générationnelle, avec une intégration croissante dans les architectures Nvidia (NVLink) et une déclinaison à la fois dans le cloud public et on-prem.

Pour les DSI, l’enjeu est désormais d’intégrer ce paramètre dans leurs stratégies d’IA : choix des plateformes de modèles, arbitrage entre GPU et ASIC maison, trajectoire de souveraineté et de localisation des données, et… dépendance à long terme à des stacks de plus en plus intégrées, du chip jusqu’au service managé.

puis

puis