Big Switch Networks, l’un des pionniers du Software Defined Network (SDN) veut banaliser les switches et permettre aux entreprises de gérer plus facilement leurs Data Centers dans le cloud et sur place.

Crée en 2010 sur les fonds baptismaux de l’Université de Stanford, Big Switch n’a pas eu la chance d’être acquise par VMWare en 2012 pour 1,26 milliard de dollars comme Nicira qui dès 2007 dans cette même université définissait et mettait en œuvre ce qui est devenu le Software Defined Network (SDN). Lors de l’IT Press Tour dans la Silicon Valley en juin dernier, Big switch ouvrait ses portes pour faire le point sur ses derniers développements et son intention d’accélérer ses déploiements dans e reste du monde.

Gregg Holzrichter, Chief Marketing Officer de Big Switch indiquait: « Après la virtualisation des serveurs et la virtualisation du stockage depuis une quinzaine d’années, la virtualisation du réseau peut se comparer à ce qui s’est passé dans l’automobile où de tableau de bord de la voiture a progressivement masqué et pris en charge toute la complexité de l’automobile et donné la possibilité d’utiliser la voiture plus facilement, plus surement et plus rapidement et a permis d’en faire baisser le coût. La vitesse automatique se situe, par exemple, à un niveau d’abstraction différent de celui du levier de vitesse puisque la commande sur la vitesse s’exprime dans un cas par l’accélérateur et dans l’autre par le levier et la pédale de débrayage. Le niveau et le type d’action requis est un sensiblement différent dans chacun des cas. Le rôle de l’industrie automobile a été de créer des outils simples qui prennent en charge la complexité et permettent à un conducteur « normal » de conduire cette voiture. »

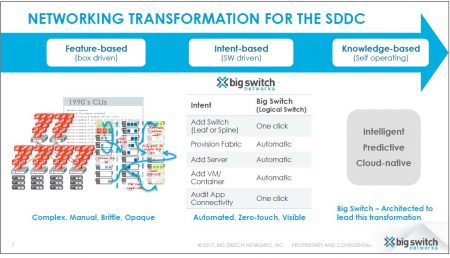

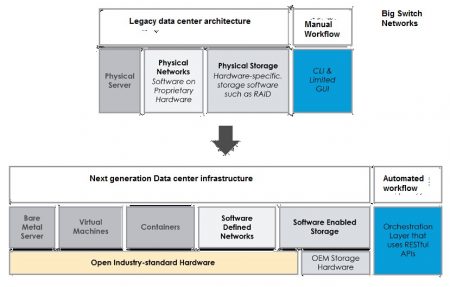

Pour lui, dans l’évolution des Data Centers, ce sont les réseaux qui constituent le goulot d’étranglement et l’objectif de Big Switch Networks est de simplifier les réseaux, de les rendre plus faciles à gérer en offrant des niveaux d’abstraction plus élevés et l’automatisation d’un grands nombre de tâches opérées jusqu’ici de façon manuelle, grâce à la désagrégation des réseaux, c’est-à-dire le découplage entre le logiciel et le hardware.

Le réseau dans le data center est virtualisé

Les interconnections, la gestion des switchs et les transferts de données à l’intérieur du réseau entre les différents appareils devient programmable et intelligente. Progressivement, tout comme l’automobile sans chauffeur, le réseau pourra (un jour..) se gérer par lui-même, grâce à des fonctions logiciel de plus haut niveaux. Certaines activités seront automatisées en fonction de données extérieurs reçues et une certaine capacité d’apprentissage (machine learning) lui permettront de faire des prédictions sur le fonctionnement du data center et d’agir en conséquence notamment en matière de sécurité.

Gregg Holzrichter poursuit : « Les administrateurs de réseaux doivent sans arrêt suivre et contrôler la sécurité du réseau, s’assurer de son intégrité et maintenir ses performances. Cependant beaucoup de sociétés qui ont des Data Center ont évolué pour leur permettre de recevoir des applications qui résident dans le cloud, ce qui améliore la réactivité de leur business et réduit les coûts, mais il devient alors très compliqué d’un point de vue opérationnel de continuer de gérer les évolutions de l’infrastructure et gérer la sécurité. »

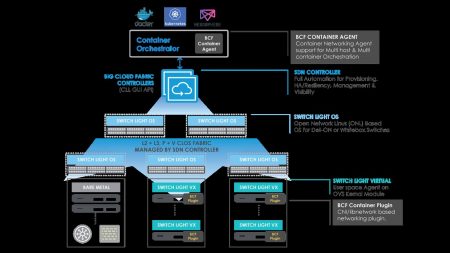

L’offre de BIg Switch Networks s’organise autour de 2 produits implémentant une approche de type hyperscale dans le réseau qui consiste à centraliser et rendre programmable l’organisation et le contrôle du réseau. Big Cloud Fabric (BCF) est un contrôleur SDN qui permet aux entreprises de choisir leur hardware de switch dans l’environnement VMWare ou l’environnement Open Source OpenStack. Le deuxième produit, appelé Big Monitoring Fabric (BMF) est un contrôleur de management de réseau qui apporte une sécurité élargie sur l’ensemble du réseau.

« Avec BCF, nous venons en complément de VMWare NSX explique Gregg Holzrichter, en revanche, nous sommes directement concurrents de Cisco ACI qui fonctionne sur du matériel propriétaire non ouvert, beaucoup plus cher et moins souple. » Il explique que la démarche de Big Switch Networks est sim aire à de celle de Google, Facebook ou Microsoft qui, en interne, ont de nombreux datacenters distribués. Ils gèrent et automatisent leurx réseaux comportant des milliers de switchs avec des équipes réduites, grâce à un control plane centralisé et programmable, découplé du data plane. Dans l’environnement VMWare, l’intégration a été poussée assez loin et le contrôleur BCF fonctionne comme un underlay qui donne à l’admin visibilité et contrôle sur l’ensemble du réseau physique et virtuel, permet l’automatisation du provisionning et facilite la recherche des problèmes. Il comporte des analytics qui donnent une vision complète du fonctionnement du réseau. Chaque nouvelle VM est automatiquement reconnue et intégrée dans le réseau et les politiques du réseau sont appliquées automatiquement. « Du point de vue du matériel explique le CMO, nous avons passé des accords avec HPE, Dell-EMC, Accton dont les matériels fonctionnent sous un environnement Open Source sous Linux (Red Hat, Mirantis, Ubunut, Canonical), d’autres accords sont à venir).

Une approche de type hyperscale appliquée aux réseaux

Dans l’environnement Open Stack qui est adopté par beaucoup de grands opérateurs pour déployer leurs Data Centers pour offrir un environnement « élastique » et scalable, Big Cloud Fabric (BCF) est un contrôleur logiciel couplé avec un hardware standard X86. Gregg Holzrichter explique : BCM est un contrôleur compatible avec OpenFlow, c’est un élément différenciant de Big Switch Neworks et nous l’avons fait évoluer progressivement pour s’intégrer plus profondément avec l’environnement OpenStack, plus particulièrement avec les containers qui créent des micro-services basés avec des applications cloud natives distribuées »

Grâce à un OS (Switch Light OS qui est propriétaire à Big Switch Networks), BCF s’installe sur les switches centraux (spine) ou périphériques (leaf) ou les vswitches et peut connaitre les différents workloads, automatiser la configuration du réseaux, visualiser l’existence des containers sur le réseaux et faciliter la recherche des problèmes. « L’architecture de BCF fonctionne (grâce à des plug in..) sur Neutron , Openshift de Red Hat et Kubernetes de Google, qui permettent de développer et d’orchestrer des micro-services spécialisés sur le réseau.» BCF s’interface donc avec les orchestrateurs par un agent et un même BCF peut faire cohabiter en toute sécurité de multiples containers avec les environnements VMWare ou OpenStack, ils sont alors instanciés et isolés en toute sécurité, avec visibilité sur le trafic des données de container à container, à la fois sur le réseau virtuel et sur le réseau physique. Un historique de la vie des containers fait partie des outils analytiques pour automatiser le contrôle et diagnostiquer les dysfonctionnements.

Big Monitoring Fabric (BMF) est contrôleur basé sur un hardware ouvert qui contient un système de visibilité et de management de réseau pour une sécurité élargie et simple à gérer. Il s’implémente « out of band » sur un réseau existant et fonctionne en overlay sur l’infrastructure existante pour assurer l’intégrité et la sécurité. « BMF peut être considéré comme un système de surveillance évolué du réseau, sur du hardware Intel X86. » Il entre en concurrence avec des systèmes comme Gigamon.

Big Switch networks apporte ainsi une approche et une vue identique à tout les acteurs de la gestion du Data Center, le VM admin, le Storage admin et le newtork admin, basée sur une approche de type « hyperscalabilité appliquée aux réseaux », ce qui augmente l’agilité, réduit les charges de maintenance et facilite la recherche et la résolution des problèmes.

Un marché prometteur qui croît encore assez lentement

Les responsables de Big Switch indiquent avoir aujourd’hui plus de 200 clients qui licencient ses produits. Parmi ceux-là l’un des plus significatifs est l’opérateur téléphonique Verizon qui utilise du matériel Dell sous VMWare, Red Hat et Mirantis avec Big Switch pour mettre en œuvre une architecture SDN NFV (Network Function Virtualisation) avec un système d’orchestration de bout en bout pour réduire les coûts d’opération et de maintenance. Il mentionne aussi la ville de Dubaï L’adoption du SDN dans les data center reste encore aujourd’hui assez limitée à quelques grandes entreprises sur des marchés verticaux et quelques opérateurs de Cloud pour leurs Data Centers.

Remarquant que la tendance dans la mise en œuvre de Data Centers est désormais de faire confiance aux systèmes ouverts (portés par Open Stack), plutôt qu’aux approches propriétaires, la société d’analyses IDC mentionne un marché en croissance. Il devrait atteindre 12,5 milliards de dollars en 2020 sachant que la plus forte croissance se situera sur la couche de contrôle/virtualisation et les applications SDN (sécurité et analytics), mais le hardware restera le poste le plus élevé, d’autant que les business modèles dans le monde Open Source sont encore assez fluctuants, et explique une certaine difficulté à suivre les releases des produits logiciels, en évolution permanente. Gregg Holzrichter indiquait que la société connait une croissance de plus de 150% par an et mentionne un chiffre d’affaire de $30 millions uniquement en logiciel, avec 170 employés.

Enfin la société vient de lever un nouveau tour de capital risque de 31 millions de dollars avec un panel impressionnant d’investisseurs dont Michael Dell, Khoshla Ventures, Index Venture, Redpoint, Morgenthaler, Silverlake Waterman et Intel Capital, ce qui porte le montant total levé à $120 millions en 5 tours depuis 2012 Les fonds levés permettront de poursuivre l’extension internationale de la société, plus particulièrement vers l’Asie. On remarque qu’Intel, qui n’avait pratiquement pas investi dans des sociétés de réseau au court de ces dernières années, mise sur une société qui favorise une approche hardware ouverte face à des solutions hardware propriétaires. Intel s’est assez clairement recentré sur le cloud et les data centers ou il espère trouver des marchés de plus grande diffusion pour ses processeurs haut de gamme puissants qui résistent mieux à la « commoditisation ».

puis

puis