Georges Teixeira, le PDG de l’éditeur de logiciel Datacore, de passage à Paris, nous a donné son avis sur les dernières évolutions du stockage.

A l’occasion de la réunion annuelle des ses partenaires européens, à la fin de la semaine passée, l’éditeur de logiciel Datacore, spécialiste du backup, a mis en avant ses atouts sur le backup de tâches virtualisées. La concurrence s’accentue dans ce domaine avec l’omniprésence du cloud car chaque éditeur tente d’intégrer cette évolution dans son offre, qu’il s’agisse des leaders historiques du logiciel de backup comme CA, IBM ou Symantec, des fabricants de SAN comme EMC et Netapp ou encore les spécialistes de la virtualisation comme Vmware ou Veam.

La nouvelle concurrence de Vmware

Interrogé, à l’occasion de cette réunion sur la nouvelle solution de sauvegarde de Vmware, « Vsan », qui paraît entrer en concurrence directe avec tous les produits de back up qui exploitent ce type de virtualisation , Georges Teixeira ( ci dessous) , le PDG de l’entreprise ,  fidèle à son franc-parler ne paraissait pas inquiet.

fidèle à son franc-parler ne paraissait pas inquiet.

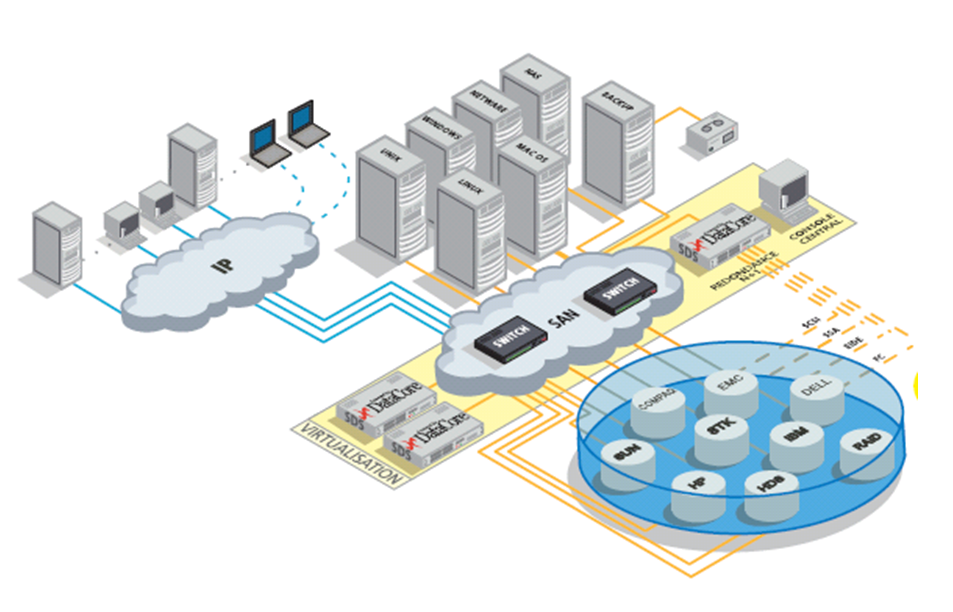

« Avant VSAN de Vmware, on avait eu aussi l’annonce de ViPR d’EMC qui nous paraissait plus inquiétant car trés ouvert comme notre logiciel. Au-delà des infrastructures de stockage existantes pour les charges traditionnelles, il provisionne de nouveaux objets de type Data Services via Amazon S3 ou d’autre API . Mais le résultat, comme avec Vsan, a été pour nous de légitimer notre offre et finalement, on a eu 40 % de croissance au dernier trimestre. La plupart des logiciels de backup ne fonctionnent en effet que par « silo » et rares sont les entreprises qui n’ont pas différents types de matériel pour le stockage. De ce fait, lorsqu’il faut les administrer, cela devient très compliqué alors qu’avec notre SS-V , la virtualisation et l’auto-tiering rendent l’ensemble plus simple à administrer. »

Le back up du Big data, pas si différent du reste

Interrogé sur la tendance des « big objets», que l’on pourrait appelé le « back up du Big data », celui devant soulever de nombreux nouveaux problèmes, Texeira restait assez circonspect. Cette problématique a été soulevée récemment par la multiplication de startups dans ce domaine comme Amplidata, Caringo, Cleversafe ou DDN. Les offres récentes d’ EMC, le n°1, ou de spécialistes comme Comvault ou Scality, paraissent aussi innover dans ce domaine.

Pour Teixeira, « l’objet » n’est qu’une tendance et une simple facette du marché du backup que les analystes comme Gartner et IDC estiment encore à 100 millions de dollars, ce qui ne serait pas encore très important. « Dans notre cas, on travaille depuis longtemps sur le stockage en ligne avec Open stack mais là encore, on résout déjà le problème avec nos logiciels existants. Notre partenaire Hitachi travaille beaucoup sur ce sujet avec des outils très spécifiques et des systèmes de gestion des fichiers optimisés.»

L’avenir des spécialistes du SSD

Interrogé sur les 150 sociétés liées aux SSD dont certaines sont actuellement en difficultés, Georges Teixeira précisait : « il y en a beaucoup trop et la plupart ne propose rien d’autre qu’un emballage de SSD. Cela ne suffira pas malheureusement pour certains. Il faut pourtant pour se différencier un logiciel . Le notre a des fonctions de cache et de gestion hiérarchique qui permettent d’intégrer les différentes caractéristiques des disques ultra-rapides. Autant dire que l’on simplifie l’utilisation de ces systèmes.»

Actuellement pour des raisons de performances on voit réapparaitre le stockage au sein même des serveurs.

Georges Texeira: «Après des années où l’on prônait les réseaux de stockage, pour une plus grande liberté d’accès, on revient à une forme de centralisation. C’est l’intérêt de nos outils qui simplifient l’administration.»

QUID des outils de Datacore

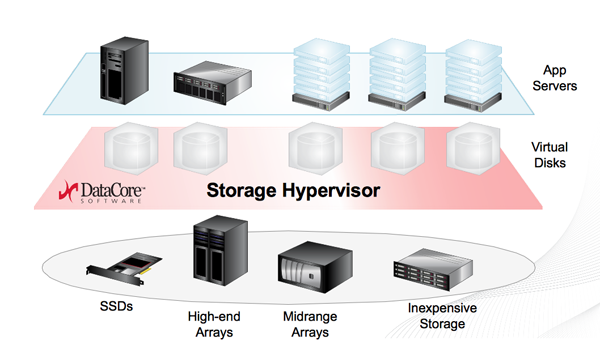

SANsymphony- V ( SS-V) est souvent appelé l’hyperviseur de stockage par ses utilisateurs car il offre une couche d’abstraction logicielle pour mettre en commun les ressources matérielles et d’allouer ou « désallouer « à la demande les volumes que l’on veut utiliser pour les différentes applications .

Pour les opérateurs de Cloud, Datacore propose DCSPP (Datacore Cloud Service Provider Program) pour un backup précis. VMware dans ce domaine proposait son modèle VSPP ( VMware Service Provider Program) pour une facturation à l’usage. De son coté Veam avait lancé les VCPP (Veam Cloud Provider Program), une preuve que la virtualisation et le cloud évoluent en parallèle.

puis

puis