Un petit regard dans le rétroviseur permet de mieux comprendre l’engouement actuel pour les réseaux SDN (Software Driven Network).

Les VLan (Virtual Lan), les réseaux virtuels datent du début des années 80. Ils étaient caractéristiques des équipements de réseaux évolués, au-delà des simples commutateurs et des ponts. Conçus pour étendre les réseaux locaux, ils permettaient de créer des groupes de travail logiques qui n’avaient rien avoir avec leurs emplacements physiques.

Comme en parallèle, la virtualisation progressait au sein des serveurs, elle s’additionnait à la complexité des VLan. Les deux systèmes, réseaux virtuels (Vlan) et tâches virtuelles exécutés en parallèle ne manquaient pas d’épuiser les serveurs et leurs cartes de communications du fait de la charge des entrées-sorties excessives.

Une lutte ouverte entre réseaux et mainframes

De plus, les limitations en terme de domaines pour les VLan s’ajoutaient à la quasi impossibilité de faire transiter les machines virtuelles entre serveurs via le réseau. De ce simple fait, la virtualisation offerte par le cloud (les offres de services en ligne à l’époque supportées par des mainframes) et leurs possibilités d’isolations particulières donnaient plus de ressources et de souplesse pour jongler avec les tâches applicatives où qu’elles soient. De la même manière que les minis des grandes entreprises offraient, dans ces années là, une souplesse supérieure et une puissance de traitement sans comparaison à celles disponibles sur les réseaux locaux disponibles à l’époque.

Au début des années 90, les défenseurs des solutions centralisées sur minis ou mainframes n’hésitaient pas à critiquer les promoteurs des réseaux locaux qui ne cessaient d’ajouter de la complexité aux serveurs et aux passerelles devenues pont routeurs puis routeurs.

Une course à l’armement

Et cela fait plus de 20 ans que les réseaux se libèrent peu à peu de leurs contraintes. Les prix réduits des PC et des applications de plus en plus reliées aux minis et aux serveurs ont tué les terminaux (Dumb terminal). Les PC capables d’émuler les terminaux et d’effectuer une partie du travail réservés jusque-là aux serveurs, ont révolutionné l’informatique durant les années 90. Les routeurs, devenus passerelles incontournables, sont devenus de puissants ordinateurs pour mieux interagir avec les serveurs applicatifs. Ils se sont mis, en particulier, à simplifier l’utilisation des machines virtuelles mais aussi leurs transferts d’un serveur à l’autre. Dans un sens, ils ont repris la place des contrôleurs de communications qui reliaient les mainframes via les réseaux aux postes clients.

Mais avec l’arrivée d’Internet et la domination du protocole IP, tous les ordinateurs se sont mis à communiquer avec des systèmes compatibles sous IP, sans effacer pour autant la complexité des réseaux virtuels. Au contraire, pour créer des systèmes de communication ouverts, la solution a été de créer des tunnels virtuels toujours plus complexes pour profiter de serveurs et des ressources partagés gratuites; mais cela a nécessité toujours plus de logiciels « d’emballage réseaux « . A tel point que tous les tuyaux des opérateurs sont encombrés avec ces emballages protocolaires.

Cela crée des engorgements qui n’ont plus rien à voir avec le trafic réel de données. Pour les opérateurs mobiles par exemple, l’enjeu financier est stratégique car ils doivent acheter de nouvelles infrastructures qui seront essentiellement ouvertes au trafic de données. Selon le cabinet d’étude Informa qui a interrogé 130 opérateurs mobiles en début d’année : 93 % d’entre eux envisageraient de mettre en oeuvre le SDN dans les cinq ans à venir, la moitié comptant le rendre opérationnel dans les deux prochaines années.

Le SDN , une solution apparemment miracle

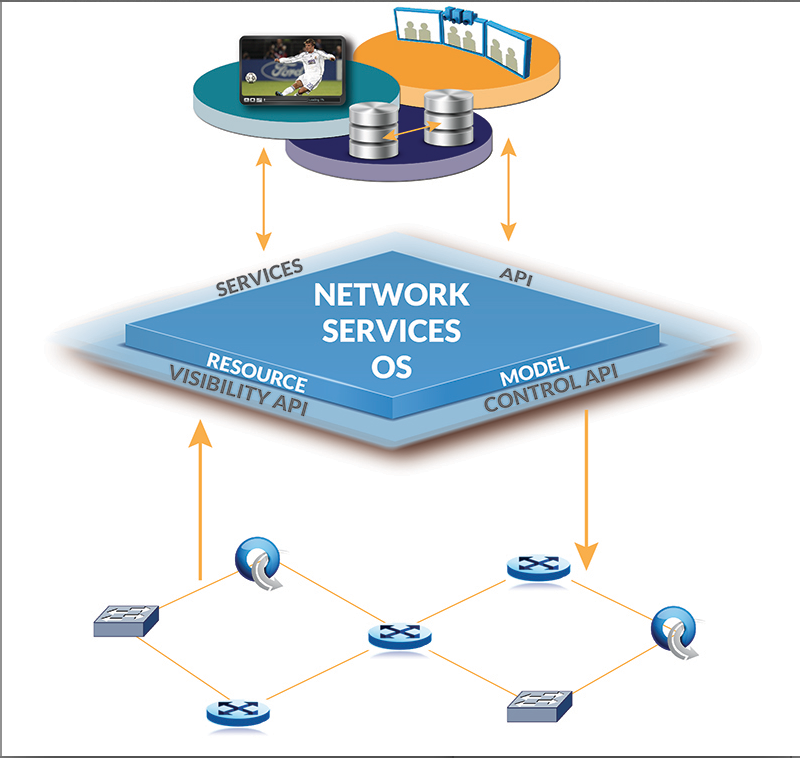

Avec le software Driven network, le fameux SDN dont on parle depuis environ trois ans, l’objectif a donc été de simplifier les réseaux de routeurs. On se servira d’un jeu de nouveaux protocoles qui réduisent l’importance des équipements de réseaux en donnant la priorité aux serveurs d’applications. Le protocole essentiel dans ce domaine est Open Flow et une collection d’interfaces de programmation pour que l’on puisse faire circuler les données en découplant les interfaces d’administration de celle des données. Dans OpenFlow, les décisions de routage sont prises par le contrôleur pour chaque flux de données et « poussées » dans les switches sous forme de simples instructions de commutation

De fait, les routeurs sont devenus des commutateurs comme les autres et font fonctionner plusieurs systèmes en parallèle comme par exemple Juniper avec sa solution Contrail. Cette suite de logiciels repose sur des serveurs multi lame X86 fonctionnant sous Linux. Ils créent des «surcouches » logicielles de réseau virtuel. Elles permettent donc l’interconnexion des réseaux physiques avec l’environnement virtuel des serveurs des data centers. Le système regroupe la gestion dynamique des ressources réseau d’un côté et la demande en connectivité et la QoS demandée par des applications crées pour le cloud.

La compatibilité avec le cloud est un argument lourd

Le contrôleur logiciel de Juniper est par exemple compatible avec les outils d’orchestration de cloud CloudStack et OpenStack et doit permettre selon Juniper de fédérer des environnements cloud privés, publics et hybrides.

_____________________

Encadré

Premier sur le terrain ,Juniper multiplie les partenariats

Juniper a signé un contrat avec IBM pour intégrer Contrail à sa plateforme de gestion des clouds d’entreprise SmartCloud Orchestrator. Du coté des serveurs virtualisé, outre Vmware, Juniper travaille aussi avec Citrix et Red Hat pour intégrer dans Contrail le support des hyperviseurs Xen et KVM. Deux versions de Contrail existent une privée et une ouverte appelée OpenContrail. Cette dernière sous licence Apache 2.0 est téléchargeable sur le site www.opencontrail.org.

Autre partenaire Cloud scaling connue pour être le promoteur de l’elastic cloud travaille aussi avec Juniper sur l’intégration de Contrail dans son offre open source pour le Cloud. Randy Bias, le patron de Cloudscaling sur son site explique la motivation de sa compagnie

puis

puis