La conférence DockerCon 2015 qui se déroule depuis hier à San Francisco dans les salles de conférences de l’Hôtel Marriott Marquis est la deuxième édition du rassemblement mondial d’experts Docker, collaborateurs et partenaires. A l’ouverture, la grande annonce a été l’adoption d’une définition commune des apis et des usages dans le nouveau projet open container. L’objectif est que Docker fonctionne sur les différents systèmes d’exploitation, d’architectures CPU et les différents clouds.

et les différents clouds.

La liste des nouveaux partenaires est impressionnante. Amazon Web service, Cisco, EMC, Google, HP, Huawei, IBM, Intel, Joyent, Microsoft, Pivotal, Red Hat, VMware se sont rassemblés autour de Docker et CoreOS pour créer l’Open Container Project, mais cela ne mettra pas en cause le projet open source initial. A priori, il ne manque parmi les grands éditeurs qu’Oracle et Apple. Mais l’on a déjà vu des dizaines de fois ce type de rassemblement pour juguler un mouvement vers une nouvelle technique afin que tous ses membres puissent dire justement « on fait partie du mouvement » mais c’est surtout une manière de protéger des ventes en cours et dans ce cas, ce sont les hyperviseurs qui sont sur la sellette.

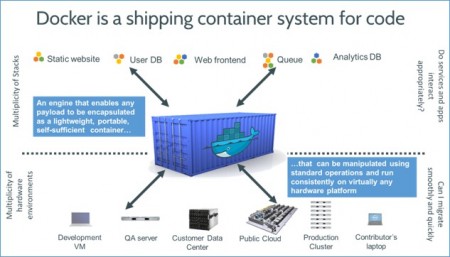

Le projet sera supporté néanmoins par la fondation linux. Rappelons que Docker tire parti nativement des conteneurs Linux pour la virtualisation. L’intérêt des conteneurs, pour ceux qui n’ont pas eu le temps de s’intéresser à cette technique, est d’occuper beaucoup moins de place que l’ensemble des images des machines virtuelles les plus répandues (Hyper V, VMWare, MKV et Xen). Le fait qu’ils démarrent beaucoup plus vite, étant plus légers, joue aussi en faveur des applications » dockerisées. C’est lié au fait que le conteneur n’intègre qu’un système d’exploitation réduit pour fonctionner puisqu’il utilise les ressources de son système hôte.

5 fois plus de participants

Cette technologie de « conteneurisation » met sur le fond en cause les habituelles solutions de virtualisation et au vu de la passion qu’elle suscite, c’est encore une nouvelle vague de remises en cause qui se profile. Le patron de docker, Ben Gollub, lors de la key note rappelait : « L’intérêt de Docker est d’assurer la portabilité, l’interopérabilité des conteneurs et de permettre leur fonctionnement dans n’importe quel environnement sans aucun outillage. Plus de trois millions de développeurs utilisent désormais Docker. 140 000 applications ont été créées, et elles ont été téléchargées 500 millions de fois ».

Alors que la première édition n’avait rassemblé que 400 personnes, cette fois-ci ce sont 2000 personnes qui se sont inscrites. Durant les conférences de deux jours, au-delà des cas classiques d’utilisation de Docker dans les entreprises, les sujets à la mode sont du côté des développeurs : l’intégration continue, la livraison continue, le déploiement « croisé » dans le cloud, la portabilité, le développement et les « mises à l’échelle » selon les méthodes dites agiles, les tests et les essais, l’usage des PaaS, etc.). Parmi les utilisations inhabituelles très remarquées, l’analyse » standardisée » pour la bio-informatique, la radioastronomie, et la transmission de données dans le secteur de l’énergie. Les technologies de conteneurs ont vraiment le vent en poupe.

puis

puis