NVidia lance cette semaine son supercalculateur IA le plus compact jamais conçu. Le DGX Spark, basé sur son architecture « Grace Blackwell », marque une étape importante dans la démocratisation de l’infrastructure IA en entreprise en offrant une puissance de calcul d’un petaflop dans un format qui tient sur un bureau. Parfait pour les datascientists, roboticists et développeurs qui doivent entraîner, réentraîner ou personnaliser des modèles IA. Mais aussi pour inférer de l’IA en local avec des données critiques.

NVidia confirme avoir démarrer cette semaine la livraison des machines « DGX Spark » qui seront disponibles à la vente sur son site et sur celui de ses partenaires OEM, en l’occurrence Acer, ASUS, Dell Technologies, Gigabyte, HP, Lenovo et MSI. Objectif : mettre sur un bureau une machine « péta-scale » pour l’IA jusqu’ici réservée aux datacenters, sans compromis sur la pile logicielle CUDA/AI maison.

L’essentiel technique

Au cœur de Spark, le SoC GB10 (Grace-Blackwell), co-développé avec Mediatek, miniaturise l’architecture des superchips NVIDIA : un CPU ARMv9.2 à 20 cœurs et un GPU Blackwell, reliés en NVLink-C2C et alimentés par 128 Go de LPDDR5x en mémoire unifiée. L’ensemble est donné pour jusqu’à 1 pétaflops (en précision FP4) et s’accompagne d’une carte réseau ConnectX-7 à 200 Gb/s. Cette configuration vise explicitement les charges IA mémoire-intensives que les GPU grand public gèrent mal. L’utilisation d’une connectivité ConnectX-7 via des ports QSFP permet de coupler deux unités DGX Spark pour doubler les performances, atteignant ainsi deux petaflops et 256 Go de mémoire unifiée.

Capacités et usages visés

Selon NVIDIA, sa machine permet l’inférence en locale de modèles LLM jusqu’à 200 milliards de paramètres et le fine-tuning en local de modèles comportant jusqu’à 70 milliards de paramètres (donc – pour faire simple – de tous les SLM personnalisables en open source du marché).

Deux unités reliées en 200 Gb/s peuvent étendre les plafonds d’inférence jusqu’à 405 milliards de paramètres.

Pour les DSI, cela ouvre des scénarios de prototypage, d’A/B-testing et de mise au point d’agents IA en local, limitant les transferts de données sensibles vers le cloud et facilitant la réplication des stacks entre poste, salle blanche et clusters DGX.

Pile logicielle et environnement

Le système arrive préconfiguré avec DGX OS, une distribution Ubuntu Linux personnalisée par Nvidia, et l’ensemble de la pile logicielle NVidia AI Enterprise. Les développeurs peuvent immédiatement exploiter les microservices NVidia NIM et accéder aux outils de l’écosystème, depuis les frameworks jusqu’aux modèles pré-entraînés. Des acteurs majeurs du logiciel comme Docker, Google, Hugging Face, Meta et Microsoft ont déjà validé et optimisé leurs outils pour la plateforme.

Disponibilité et prix

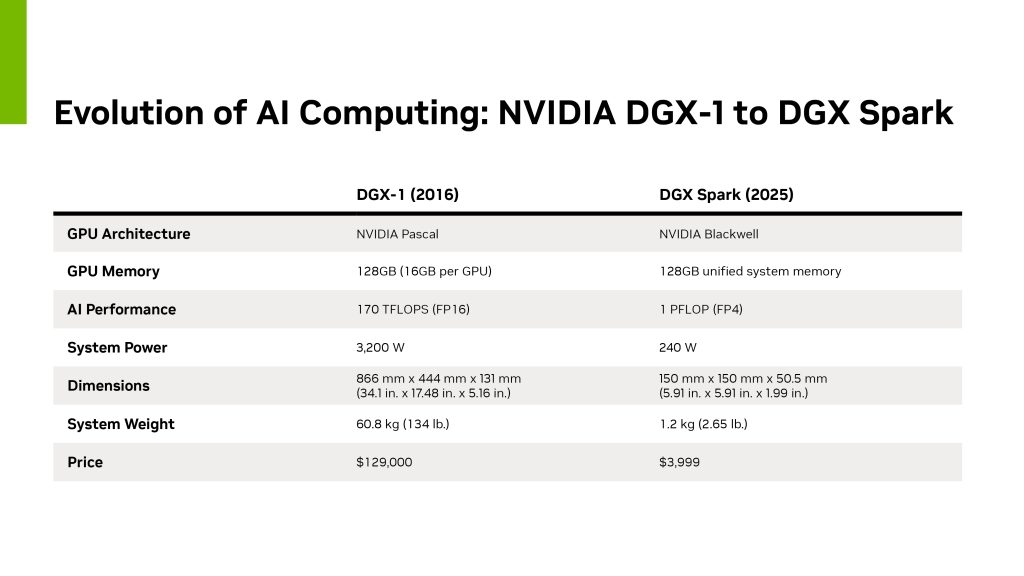

Avec un prix d’entrée autour de 3900 dollars, le DGX Spark reste un investissement conséquent mais se positionne favorablement face aux alternatives existantes pour les organisations cherchant à internaliser leurs capacités de développement IA. Jensen Huang, PDG de NVidia, a souligné la portée symbolique de ce lancement en livrant personnellement l’une des premières unités à Elon Musk chez SpaceX, rappelant la livraison du premier DGX-1 à OpenAI en 2016 qui avait contribué au développement de ChatGPT : « DGX-1 a lancé l’ère des supercalculateurs IA et débloqué les lois d’échelle qui alimentent l’IA moderne. Avec DGX Spark, nous revenons à cette mission – placer un ordinateur IA dans les mains de chaque développeur pour déclencher la prochaine vague d’innovations. »

L’ASUS Ascent GX10 illustre l’intégration extrême : 150 × 150 × 51 mm, 1,48 kg, alimentation 180 W via USB-C, Wi-Fi 7, 10 GbE et le ConnectX-7 exposé en façade arrière. ASUS décline des options 1/2/4 To NVMe (format M.2 2242) et confirme l’usage de DGX OS.

Côté Dell, ServeTheHome a dévoilé l’unboxing du Pro Max GB10 avec la même base technique (GB10, 128 Go unifiés, ConnectX-7).

Au final, la machine a de quoi passionner tous les ingénieurs de l’IA et de quoi interpeler bien des DSI. Car elle permet en pratique de rapatrier toutes les tâches de fine-tuning de modèles et de tests d’agents en local, pour un contrôle maximal et des risques limités tout en réduisant la latence, les temps de prototypage. Avec derrière l’assurance que les développements se déploieront simplement dans le Cloud ou le datacenter grâce à l’universalité de la pile IA de NVidia (et son DGC Cloud).

puis

puis