« L’edge computing » devrait connaître un taux de croissance de 40 % d’ici à 2025. D’où la nécessité d’en comprendre les contraintes et les besoins.

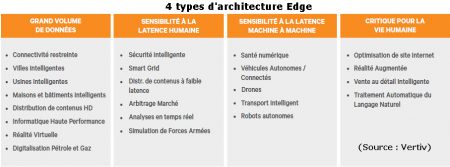

Dans son rapport Définir les 4 archétypes edge et leurs exigences technologiques, Vertiv, ex Emerson Network Power identifie quatre archétypes principaux pour les applications edge et la technologie requise pour les soutenir. Vertiv, en association avec un cabinet d’experts-conseils indépendant, a identifié plus de 100 cas d’utilisation et ont réduit la liste initiale à 24 cas considérés comme ayant l’impact le plus important sur les entreprises et les utilisateurs finaux, en fonction des prévisions de croissance, du caractère critique et de l’impact financier.

Les experts ont identifié des ensembles basés sur les données d’exigences relatives aux charges de travail pour chaque cas d’utilisation edge et les besoins correspondants en termes de performance, de disponibilité et de sécurité. Ils ont examiné les exigences de performance spécifiques, y compris la latence, la disponibilité, l’évolutivité et la sécurité, en conjonction avec le besoin de chiffrement, d’authentification et de conformité règlementaire. Ils se sont également penchés sur le besoin d’intégration aux applications existantes ou héritées et aux autres sources de données, tout en tenant compte du nombre d’emplacements de périphérie dans un réseau donné.

Les 4 archétypes sont les suivants :

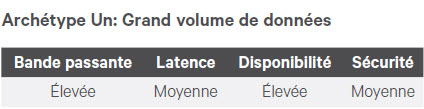

Grand volume de données

Il se compose de cas où la quantité de données rend impossible le transfert sur le réseau directement vers le cloud ou du cloud vers le point d’utilisation en raison du volume de données, du coût ou de problèmes de bande passante. Les exemples comprennent les villes intelligentes, les usines intelligentes, les maisons et les bâtiments intelligents, la distribution de contenu haute définition, l’informatique haute performance, la connectivité restreinte, la réalité virtuelle et la numérisation du pétrole et du gaz. L’exemple le plus largement utilisé est celui de la diffusion de contenu haute définition, où les principaux fournisseurs de contenu tels que Amazon et Netflix s’associent activement avec les fournisseurs de colocation pour étendre les réseaux de diffusion afin de rapprocher les utilisateurs de la vidéo en streaming à forte consommation de données afin de réduire les coûts et les temps d’attente.

Il se compose de cas où la quantité de données rend impossible le transfert sur le réseau directement vers le cloud ou du cloud vers le point d’utilisation en raison du volume de données, du coût ou de problèmes de bande passante. Les exemples comprennent les villes intelligentes, les usines intelligentes, les maisons et les bâtiments intelligents, la distribution de contenu haute définition, l’informatique haute performance, la connectivité restreinte, la réalité virtuelle et la numérisation du pétrole et du gaz. L’exemple le plus largement utilisé est celui de la diffusion de contenu haute définition, où les principaux fournisseurs de contenu tels que Amazon et Netflix s’associent activement avec les fournisseurs de colocation pour étendre les réseaux de diffusion afin de rapprocher les utilisateurs de la vidéo en streaming à forte consommation de données afin de réduire les coûts et les temps d’attente.

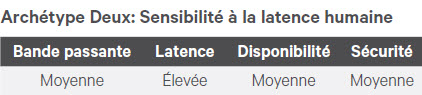

Sensibilité à la « latence humaine »

Cet archétype comprend des cas où les services sont optimisés pour la consommation humaine, et où tout est une question de vitesse. Les retards dans la livraison des données ont un impact négatif sur l’expérience technologique d’un utilisateur, ce qui peut réduire les ventes et la rentabilité d’un détaillant. Ces cas impliquent la vente au détail intelligente, la réalité augmentée, l’optimisation des sites Web et le traitement du langage naturel.

Cet archétype comprend des cas où les services sont optimisés pour la consommation humaine, et où tout est une question de vitesse. Les retards dans la livraison des données ont un impact négatif sur l’expérience technologique d’un utilisateur, ce qui peut réduire les ventes et la rentabilité d’un détaillant. Ces cas impliquent la vente au détail intelligente, la réalité augmentée, l’optimisation des sites Web et le traitement du langage naturel.

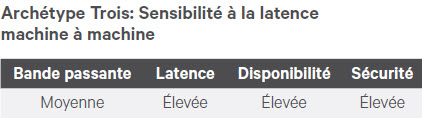

Sensibilité à la latence machine à machine

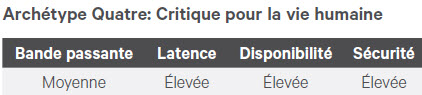

Critique pour la vie humaine

Exigences technologiques pour les hubs locaux et régionaux

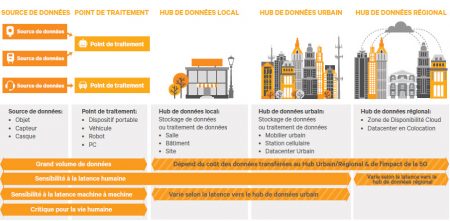

L’infrastructure requise pour prendre en charge ces cas d’utilisation actuels et établis comprend quatre couches de stockage et d’informatique en plus de l’infrastructure de communication requise pour déplacer les données entre les couches.

L’infrastructure requise pour prendre en charge ces cas d’utilisation actuels et établis comprend quatre couches de stockage et d’informatique en plus de l’infrastructure de communication requise pour déplacer les données entre les couches. À la source, il y a généralement un appareil qui génère ou consomme des données et un point de traitement.

L’appareil peut être un capteur qui surveille tout, l’état d’alimentation d’une lampe, l’accès à une porte, la température d’une pièce ou d’autres informations souhaitées. Le point de traitement peut être aussi simple que le PC ou la tablette sur lequel un consommateur diffuse une vidéo, ou pourrait être les microprocesseurs intégrés dans les automobiles, les robots ou dispositifs portables. Ces composants dépendent de l’application et sont généralement intégrés par le fabricant de l’équipement ou ajoutés aux appareils existants.

Chaque archétype, à l’exception de l’archétype critique pour la vie humaine, pourrait être placé dans le hub de données local en fonction de l’application. Le hub de données local fournit un stockage et un traitement à proximité de la source. Dans certains cas, le hub local peut être un datacenter autonome. Plus couramment, ce sera un système en baie ou en rangée fournissant 30-300 kW de capacité dans un boîtier intégré pouvant être installé dans tout environnement. Ces systèmes de boîtiers en baie et en rangée intègrent la communication, le calcul et le stockage avec une protection de l’alimentation, des contrôles environnementaux et une sécurité physique appropriés.

Pour les archétypes nécessitant un haut niveau de disponibilité, tels que la sensibilité à la latence machine à machine et Critique pour la vie humaine le hub local doit inclure des systèmes d’alimentation de secours redondants et être équipé pour une gestion et un suivi à distance. De nombreux cas d’utilisation requièrent aussi le cryptage des données et d’autres fonctions de sécurité dans le hub local.

Pour tous les archétypes à l’exception de Critique pour la vie humaine, le hub urbain et/ou régional pourrait être utilisé pour prendre en charge les cas d’utilisation en fonction des coûts de transfert des données, de la bande passante permise par le déploiement de la 5G et de la latence avec l’emplacement du datacenter physique.

Le hub urbain tire parti de l’infrastructure de télécommunications établie pour fournir des capacités d’informatique et d’infrastructure. Il sera conçu selon les normes de télécommunications, y compris l’alimentation CC et le refroidissement à l’air libre, supportant une plage de températures et d’humidité bien plus large qu’habituellement dans les datacenters traditionnels. Le hub régional pourrait être un datacenter sur le cloud ou en colocation fonctionnant dans la même région que les hubs local et urbain.

Pour les hubs urbain et local, des conceptions modulaires capables de s’adapter facilement au-delà des caractéristiques de conception initiales doivent être envisagées afin de tenir compte des pics de demande inattendus. Ces installations doivent aussi être conçues pour s’adapter en termes d’intensité. Les applications sensibles aux images, telles que la réalité virtuelle, ainsi que les applications à traitement intensif, telles que l’analyse et l’apprentissage machine, nécessiteront probablement des densités de baies dépassant la conception 10 kW habituelle. Dans pratiquement tous les cas, ces hubs doivent fournir un niveau identique ou supérieur au hub local en matière de redondance et de sécurité

puis

puis