Aptare en latin signifie s’adapter. C’est exactement le message que Rick Clark, le CEO de la société Américaine Aptare, veut faire passer avec la console d’analyse du Cloud (ou de toute structure informatique locale) que la société commercialise depuis près de 15 ans.

« Nous sommes probablement un ‘Best Kept Secret’ » commentait-il, en terminant sa présentation lors de la visite du European IT Press Tour au siège de la société à Campbell (Californie). Crée initialement en 1993 comme une société de Consulting, la société se transformait en 2003 autour d’un produit d’analyse des structures informatiques hétérogènes présenté sous forme d’une console multifonctions.

Ce produit n’a cessé d’élargir ses performances et sa portée, il équipe maintenant plus d’un millier d’entreprises et d’organismes qui gèrent les plus importantes masses de données dans le monde entier : banques, assurances, industriels, gouvernements, services, éducation, à l’exception cependant des GAFA qui préfèrent utiliser leurs propres solutions développées en interne. 35 de ses clients sont des Fortune 100… ! Loin d’être une startup, la société comporte une centaine de salariés, elle est profitable, autofinancée, et garde un fonctionnement souple appuyée sur un modèle de distribution directe aux Etats Unis et par des partenaires dont principalement Hitachi Data Systems pour le reste du monde, et Atos-Bull pour l’Europe.

Une suite logicielle d’analyse profonde, indépendante du matériel

« Hier, les data centers étaient le fait d’une demi douzaine de fournisseurs, explique Rick Clark, et il suffisait de s’adresser à eux pour obtenir des informations sur leur fonctionnement. Aujourd’hui, il y a des centaines de fournisseurs qui interviennent dans les data centers, les structures informatiques des entreprises se sont diversifiées, dispersées dans le monde, différenciées, avec des données qui sont virtualisées, stockées et sauvegardés dans des fichiers, dans des bases de données, sur des supports de stockage différents selon leur importance, les systèmes sont interconnectés par des switch fabric différents.

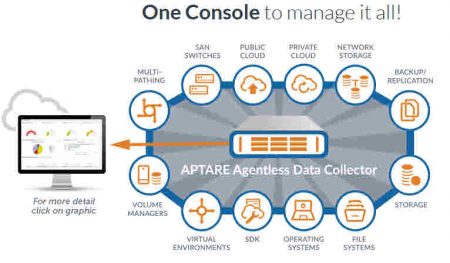

La console d’Aptare est donc une suite logicielle composée de 6 modules qui collectent les informations sur la circulation, la nature et le stockage des données traitées dans un système informatique, quel que soit sa complexité, sa forme, son étendue et sa nature, local, cloud privé ou public. Le logiciel capture et rassemble les métadonnées de toutes les données qui circulent ou sont stockées dans tous les systèmes de l’entreprise, et ces informations sont placées dans une base de donnés centralisée pour être ensuite traitées, analysées et présentées sous formes de tableaux analytiques dynamiques très visuels. Les 6 modules sont le Capacity manager, le Backup manager, le Replication manager, le File Analytics, le Vitualization manager et le Fabric manager.

La suite supporte les environnements Cloud EC2 et S3 d’Amazon et sera bientôt sur Amazon Marketplace, Microsoft Azure, Open Stack et un large éventail d’OS (Microsoft, Linux, MacOs, Unix), de systèmes de fichiers et de stockage (Netapp, Dell EMC), de bases de données (SQL Server, Oracle 12), de virtualisation (VMware), d’administration (Tivoli d’IBM), de sauvegardes et une vaste palette de switch, d’appliances et de technologies d’infrastructures. « Nous avons commencé dans l’environnement IT traditionnel, indique Rick Clark, puis nous avons poursuivit dans le Cloud et nous pouvons accéder à toute nouvelle source de données grâce à un SDK qui nous permet d’accéder à n’importe quel API. » La suite comporte aussi un module pour les données non structurées et les objets.

Répondre aux problèmes critiques posés par l’explosion des données dans l’entreprise.

« Même si certains fournisseurs proposent des outils capables de donner une vision de ce qui se passe au sein de leur propre système, aucun outil ne peut fournir une analyse complète de l’ensemble d’une structure… poursuit Rick Clark. Nous sommes les seuls à couvrir la quasi totalité des technologies et des systèmes et nous pouvons avoir une vision à la fois globale ou très détaillée du fonctionnement système ou de certaines parties qui posent un problème. » Pour lui, les principales préoccupations des CIO sont les coûts du système et de son fonctionnement, une meilleure évaluation du risque et la nécessité de fonctionner en conformité avec les régulations locales ou internationales. Aujourd’hui, avec l’afflux des données dans les entreprises, l’une des préoccupations de coût est l’allocation des données et leur réplication dans des systèmes de stockage adaptés au niveau de risque et de priorité des données, dans le Cloud, sur place, proche de l’utilisateur, etc.

Compte tenu de la diversité des systèmes de stockage, une analyse détaillée n’est souvent pas possible et il devient très compliqué de mettre en place des politiques flexibles et homogène. Il en est de même pour les sauvegardes… La difficulté est alors de détecter les données non protégées, localement ou dans le Cloud, et d’estimer les limites des capacités de stockage selon les priorités. En apportant une connaissance précise de l’emplacement des données, de leurs caractéristiques et de leur localisation physique dans le temps, la suite permet ainsi une utilisation optimisée des capacités de stockage et de la sécurité des données pour l’ensemble de la société. Les CIO sont souvent mal armés face aux questions de SLA (Service Level Agreements) et de régulation qu’ils doivent appliquer et faire respecter partout dans l’entreprise, particulièrement en Europe avec l’arrivée prochaine du RGDP.

Un processus neutre, ouvert et flexible qui laisse la décision d’action à l’entreprise

Les données présentées dans les tableaux de la suite sont dynamiques et permettent de suivre les déplacements de données de façon précise. « Nous ne sommes pas une société de stockage affirme Rick Clark, car nous touchons à toute l’infrastructure IT et nous fournissons les éléments aux responsables informatiques pour leur permettre de prendre des décisions, sans être dépendant d’un constructeur de matériel ». Le logiciel fourni des analytics très complètes sur des tableaux de bords facilement lisibles et customisables, et à travers l’édition de rapports.

Dans le cas de société comportant des activités multiples séparées, les données peuvent être vues par business unit, par région, par établissement, etc. La base de données peut s’interfacer avec des applications analytics plus sophistiquées pour des utilisations précises. Il offre aussi des analyses prédictives ou des alertes qui permettent d’établir des règles de gestion des données et des infrastructures. Cet outil est aussi particulièrement adapté aux utilisations industrielles de l’Internet des objets pour lesquelles le suivi précis des données est crucial. La suite présente un certain niveau d’automatisation qui permet de faire des tests et valider les actions réalisées. « Mais la décision appartient à l’entreprise précise Rick Clark, qui reste libre des actions à mener. Nous avons cependant développé un script qui permet de créer des commandes et des modules d’actions ».

Le processus de vente aux Etats Unis se fait par la mise en place d’un audit complet du système qui permet une analyse en profondeur. « Souvent, nos prospects découvrent des choses qu’ils ignoraient complètement alors qu’ils pensaient bien connaitre leur système et son fonctionnement, affirme Rick Clark. » Un audit dure en général 6 semaines et tous les KPI (Key Performance Indicators) sont passés au crible. Aujourd’hui, la société cherche à renforcer sa présence en Europe. Ses atouts sont importants grâce à l’expérience acquise depuis 15 ans dans les grands comptes américains et à l’heure du RGDP sachant qu’elle peut offrir une vision globale de l’utilisation des données d’une entreprise et la différencier par zones géographiques, et vérifier la bonne application des règlementations locales.

puis

puis