À l’occasion de sa conférence Ignite 2025, Microsoft a présenté sa seconde génération de processeur CPU maison, l’Azure Cobalt-200, une puce à 132 cœurs ARM que Microsoft compte massivement exploiter pour ses services clouds et ses services IA.

Souvenez-vous, lors d’Ignite 2023 Microsoft dévoilait ses premiers processeurs « maison », le CPU Cobalt-100 et l’accélérateur IA Maia-100. Ce faisant, Azure rejoignait AWS (Graviton4, Trainium2, Inferencia2) et Google (Axion + TPU Ironwood) dans la liste des hyperscalers qui trouvent plus rentables de développer leurs propres puces plutôt que d’en acheter à Intel, AMD, Nvidia, Qualcomm et autres fournisseurs. L’éditeur a commencé à se servir lui-même avant de proposer dès Octobre 2024 des VMs animés par Cobalt-100 à ses clients Azure dans 32 régions Azure.

Et le processeur a rencontré un franc succès. Il a été adopté par Databricks et par Snowflake. Microsoft Teams l’a également préféré et gagné 45% de performance supplémentaire. Microsoft Defender for Endpoint tourne également sur ces processeurs.

Lors de son Microsoft Ignite 2025, l’éditeur a dévoilé sa seconde génération de CPU, le Cobalt-200. « Comme son prédécesseur, Cobalt 200 est optimisé pour les charges de travail courantes des clients et offre des fonctionnalités uniques pour nos propres produits cloud Microsoft. Nos premiers serveurs Cobalt 200 de production sont désormais opérationnels dans nos centres de données, avec un déploiement plus large et une disponibilité client prévue en 2026 » annonce Microsoft.

Lors de son Microsoft Ignite 2025, l’éditeur a dévoilé sa seconde génération de CPU, le Cobalt-200. « Comme son prédécesseur, Cobalt 200 est optimisé pour les charges de travail courantes des clients et offre des fonctionnalités uniques pour nos propres produits cloud Microsoft. Nos premiers serveurs Cobalt 200 de production sont désormais opérationnels dans nos centres de données, avec un déploiement plus large et une disponibilité client prévue en 2026 » annonce Microsoft.

Cobalt 200 s’inscrit dans une approche « systèmes » de l’infrastructure, qui combine un nouveau silicium maison avec des briques d’infrastructure comme Azure Boost et le module de sécurité matériel intégré à Azure (HSM). L’idée est de lier étroitement le processeur, le sous-système d’I/O et les mécanismes de sécurité pour offrir une plate-forme plus cohérente et plus efficace pour les workloads cloud.

L’optimisation au cœur de la conception

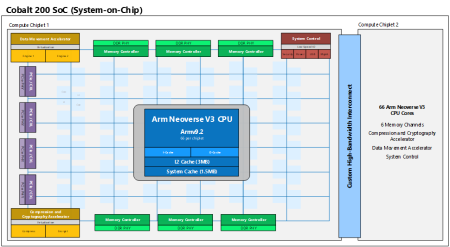

Par rapport au premier processeur Cobalt, cette nouvelle génération promet jusqu’à 50 % de performances supplémentaires tout en maintenant une totale compatibilité avec la génération précédente. Ce gain vient d’une architecture modernisée : davantage de cœurs (132), un cache plus généreux et une mémoire plus rapide (3 Mo de L2, 192 Mo de L3 partagé, 12 canaux DDR5 par socket), le tout reposant sur la dernière architecture Arm Neoverse v3 et le procédé de gravure 3 nm de TSMC. Cobalt 200 intègre nativement la génération actuelle d’Azure Boost ainsi que le HSM intégré Azure, de manière à améliorer simultanément l’efficacité et la sécurité des workloads.

Par rapport au premier processeur Cobalt, cette nouvelle génération promet jusqu’à 50 % de performances supplémentaires tout en maintenant une totale compatibilité avec la génération précédente. Ce gain vient d’une architecture modernisée : davantage de cœurs (132), un cache plus généreux et une mémoire plus rapide (3 Mo de L2, 192 Mo de L3 partagé, 12 canaux DDR5 par socket), le tout reposant sur la dernière architecture Arm Neoverse v3 et le procédé de gravure 3 nm de TSMC. Cobalt 200 intègre nativement la génération actuelle d’Azure Boost ainsi que le HSM intégré Azure, de manière à améliorer simultanément l’efficacité et la sécurité des workloads.

Azure Cobalt 200 devient la plate-forme de calcul la plus économe en énergie d’Azure, avec l’objectif de réduire la consommation électrique tout en accélérant les traitements.

Le Cobalt‑200 n’est pas seulement une montée en puissance brute. Microsoft a modélisé plus de 350 000 configurations pour ajuster le processeur aux besoins réels de ses clients et de ses propres services, comme Teams.

Comme l’explique Selim Bilgin, vice‑président de l’ingénierie du silicium chez Microsoft : « Cobalt‑200 est le fruit de nos efforts de co‑innovation avec Arm. Nous avons optimisé le silicium, le serveur et le logiciel ensemble pour offrir une infrastructure qui améliore la performance et l’efficacité énergétique des workloads cloud. »

Efficacité énergétique et durabilité

Microsoft insiste sur l’importance de cette approche : « La consommation d’énergie représente une part significative du coût de fonctionnement d’un serveur cloud. Avec le Cobalt‑200, chaque cœur peut fonctionner à un niveau différent, garantissant une consommation optimale quelle que soit la charge. »

En résumé, le Cobalt‑200 n’est pas seulement une nouvelle génération de CPU : c’est une déclaration stratégique. Microsoft confirme sa volonté de maîtriser son propre silicium et de réduire sa dépendance aux fournisseurs traditionnels. Ce CPU lui permet de combiner puissance brute et optimisation énergétique à grande échelle, afin de renforcer son infrastructure cloud face aux besoins croissants de l’IA et des workloads intensifs. Mais il marque aussi une étape clé dans la compétition entre hyperscalers, chacun développant ses puces pour optimiser performance et coût total de possession.

puis

puis