L’essor de l’IA s’accompagne d’une quête constante d’optimisation, alimentée par des benchmarks comparant non seulement humain et machine, mais également différentes IA entre elles. L’évaluation comparative des systèmes d’IA transcende les frontières du marketing pour devenir un outil clé de l’innovation technologique.

Dans un paysage technologique en constante évolution, l’intelligence artificielle (IA) a commencé à transformer notre économie en effectuant certaines tâches plus ou moins complexes à notre place. En comparant les performances « humain versus machine », on se rend compte que cette approche est fructueuse, puisque les modèles d’IA finissent souvent par égaler voire surpasser les performances humaines dans des domaines aussi variés que réussir l’examen d’entrée d’une grande école ou établir un diagnostic à partir d’une radio médicale.

Mais au-delà de comparer les performances de l’IA avec celles de l’humain, il y a également un intérêt à comparer les performances entre les différentes IA via des benchmarks, sortes de bancs d’essai « IA contre IA ». Ces benchmarks sont essentiellement des tests standardisés qui mesurent la performance des systèmes d’IA sur des tâches et des objectifs spécifiques, permettant d’identifier des points de données pertinents pour son développement continu. Ils offrent aux développeurs de précieuses informations en quantifiant l’efficacité, la vitesse et la précision des modèles d’IA, leur permettant ainsi de comparer et d’améliorer différents modèles et algorithmes. A mesure que l’IA progresse, le besoin de benchmarks fiables devient primordial.

L’essor des initiatives de benchmarking en IA : changement de paradigme

Les modèles d’IA sont des systèmes complexes nécessitant des ressources importantes pour le développement, les tests et le déploiement. Les bancs d’essai standardisés sont essentiels à ce processus, offrant un cadre d’évaluation unifié. Un nombre restreint d’entreprises a tiré profit des avancées en IA ces dernières années, tandis que la majorité est encore en phase d’exploration ou de mise en œuvre opérationnelle. Les leaders du marché s’appuient sur des tests internes pour promouvoir la supériorité de leurs offres, créant ainsi un paysage fragmenté. Ce manque de collaboration et de partage des connaissances entre les industries freine une adoption plus large et cohérente de l’IA, malgré l’émergence de quelques innovations ponctuelles.

La standardisation des bancs d’essai pour l’IA, malgré certaines limites, est cruciale pour plusieurs raisons. Elle permet une évaluation objective et comparable des performances, au-delà des discours marketing, favorisant une prise de décision éclairée pour l’innovation. De plus, des initiatives comme MLCommons encouragent l’adoption de meilleures pratiques et élèvent les standards de performance à l’échelle du secteur. Enfin, la standardisation facilite la conformité réglementaire, notamment dans des domaines critiques comme la santé et la finance.

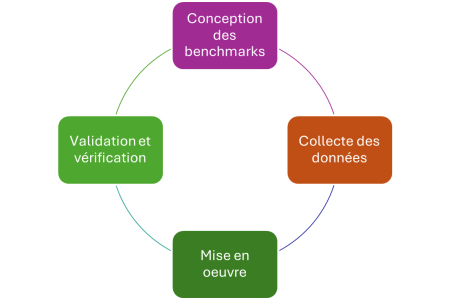

L’évolution rapide de l’IA nécessite une adaptation constante des bancs d’essai pour garantir des évaluations pertinentes. Comprendre leur conception est donc essentiel. Ce processus complexe comprend plusieurs étapes clés : la définition des objectifs et des indicateurs de performance (KPI), la collecte de données représentatives, la mise en œuvre dans un environnement standardisé, la validation des résultats et enfin, l’itération régulière pour intégrer les dernières avancées technologiques.

Conséquences de l’évolution de l’IA sur les normes de benchmarking

Les consortiums de l’industrie informatique utilisent depuis longtemps le benchmarking pour stimuler l’innovation. Notamment, les normes de la Standard Performance Evaluation Corporation (SPEC) et du Transaction Processing Performance Council (TPC) ont établi des bancs d’essai pour les performances des ordinateurs et des bases de données, qui ont permis de faire progresser ces technologies, au bénéfice des utilisateurs finaux et des entreprises.

MLCommons illustre parfaitement l’importance de la collaboration dans le domaine de l’IA. Ce consortium, réunissant des acteurs clés de l’industrie et du monde académique, développe des bancs d’essai standardisés pour évaluer et améliorer les performances des modèles d’IA. Ces outils fournissent aux décideurs des informations cruciales sur la performance, l’évolutivité et la sécurité, favorisant ainsi l’innovation éclairée.

Ouvrir la voie à un écosystème de benchmarking collaboratif

La collaboration est la clé du succès de l’IA. L’évaluation et l’optimisation des performances passent par un écosystème collaboratif de benchmarking, où le partage des ressources et de l’expertise stimule l’innovation. Ce modèle favorise l’échange de connaissances et de meilleures pratiques, contribue à l’amélioration continue des bancs d’essai et profite in fine aux utilisateurs finaux en accélérant l’innovation et en garantissant la fiabilité des systèmes d’IA. L’importance de ces écosystèmes ne fera que croître avec l’évolution de l’IA.

____________________________

Par Amit Sanyal, Directeur Senior Marketing Produits Datacenters chez Juniper Networks

puis

puis