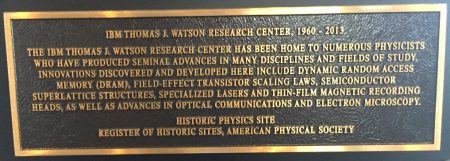

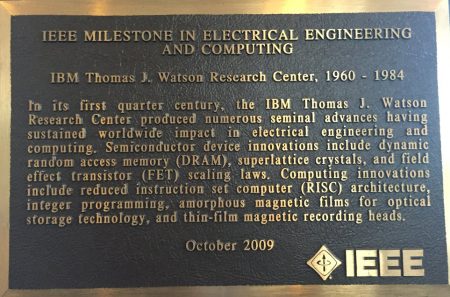

« Nous sommes juste en train d’apprendre à voler dans le monde quantique ». C’est ainsi que Bob Wisnieff, CTO Quantum Computing d’IBM, décrit de manière assez modeste l’état d’avancement des travaux chez IBM, pourtant parmi les principaux leaders du sujet. « Mais les choses évoluent très vite car il y a seulement dix ans, on pensait que l’ordinateur quantique complet arriverait dans 50 ans, il y a 5 ans dans moins de 25 ans et il y deux ans dans moins de 10 ans ». C’est dire combien les progrès sont rapides dans ce laboratoire Thomas J Watson de Yorktown Heights, au nord de New York, qui a à son actif nombre d’avancées scientifiques importantes. Construit au début des années 60, ce centre de recherche a notamment conçu les mémoires DRAM (au cœur de tous les ordinateurs d’aujourd’hui), les transistors à effet de champ ou encore les architectures RISC dont sont issus les systèmes Power.

Alors que l’IBM 360 avait été dévoilé seulement quelques années plus tôt et avait révolutionné l’informatique, c’est dès les années 70 qu’IBM a commencé à réfléchir aux limites auxquelles seraient confrontés les ordinateurs et à la manière de développer et construire des systèmes plus performants. En 1983, Charlie Bennett, un physicien qui travaille toujours dans les laboratoires Watson, a lancé une réflexion sur la combinaison de la mécanique quantique et de la science de l’information, une réflexion qui amènera à la conception d’un nouveau type d’ordinateurs. Mais c’est seulement en 2015, plus de 30 ans plus tard, qu’IBM a mis au point le premier ordinateur quantique – une machine de 5 qubits – pour la rendre accessible via Internet le 4 mai de l’année suivante. « La réaction de la communauté informatique et scientifique est allée largement au-delà de ce nous avions anticipé, poursuit Bob Wisnieff. Une semaine après seulement, une première publication scientifique l’utilisation de notre ordinateur quantique avait été faite ».

Ensuite, la situation a évolué rapidement avec un développement sur deux fronts. D’un côté, la Quantum Experience qui met à disposition du monde académique et de la recherche un système de 16 qubits. De l’autre, le programme IBM Q, destiné aux entreprises qui souhaitent se familiariser avec l’informatique quantique et être prêtes lorsque les premières applications seront possibles.

C’est dans le cadre de ce programme commercial qu’IBM vient d’ouvrir le centre de calcul quantique à Poughkeepsie, haut lieu de l’histoire d’IBM dans l’État de New York. C’est en effet sur ce campus que furent fabriqués les ordinateurs IBM 7030 ainsi que les IBM 360 et 370. Aujourd’hui, e site qui comptait plus de 8000 personnes en emploie moins de la moitié.

Ce centre de calcul quantique d’IBM répondra aux besoins croissants d’une communauté de plus en plus large constituée aujourd’hui de 150 000 utilisateurs et de quelque 80 clients commerciaux. Le parc est composé de cinq systèmes de 20 qubits, d’un système de 14 qubits et de quatre systèmes de 5 qubits. Courant octobre, ce parc passera à 14 systèmes, dont un nouvel ordinateur quantique à 53 qubits, le plus grand du marché à ce jour, accessible via le cloud.

Contrairement à l’informatique conventionnelle qui a depuis l’IBM 360 une vocation universelle, et est conçue pour une large frange d’applications dans le domaine commercial et scientifique, les ordinateurs quantiques seront utilisés pour résoudre certains problèmes spécifiques, hors de portée des ordinateurs conventionnels, même les plus puissants d’aujourd’hui comme ceux de demain.

Parmi les exemples de problèmes très utiles qu’ils pourraient résoudre, Bob Wisnieff mentionne la simulation du phénomène comme la synthèse de l’ammoniac qui permet de fabriquer des engrais. Le procédé inventé par les deux chimistes allemands Haber et Bosch au début du XXe siècle a révolutionné l’agriculture mais il a le défaut d’être très gourmand en énergie – aujourd’hui il représente 3 % de la consommation de l’énergie mondiale – même si, l’utilisation de différents catalyseurs a permis d’améliorer le rendement de l’opération. Il se trouve que les plantes, via l’opération de photosynthèse, sont capables de réaliser cette opération avec la simple utilisation de l’énergie solaire. Les ordinateurs quantiques pourraient permettre de mieux comprendre le phénomène de la photosynthèse, et de développer de nouveaux catalyseurs plus performants. La quantité d’énergie qui pourrait être économisée est considérable.

« Nous savions que les ordinateurs pourraient résoudre de nombreuses applications très utiles, explique Bob Wisnieff, mais savions aussi qu’ils étaient limités. Depuis Charlie Bennett, IBM posait la question fondamentale : qu’est-ce que la nature nous dit à propos des traitements informatiques ? Une réflexion dépassant le cadre de la loi de Moore qui ne s’intéresse qu’à l’évolution de la densité des composants ».

Si les ordinateurs conventionnels sont particulièrement adaptés pour des traitements impliquant de grands volumes de données, l’informatique quantique excelle pour des problèmes de modélisation ou simulation pour lesquels la combinatoire est telle qu’elle ne peut être traitée par les premiers. Dans les années 90, deux résultats indiquent que des ordinateurs quantiques pourraient aborder des problèmes hors de portée des machines de Turing, déterministes comme stochastiques. En 1994, Peter Shor a inventé l’algorithme qui porte son nom qui permet de calculer en un temps polynomial (et non exponentiel) la décomposition d’un nombre en produit de facteurs premiers. Avec de nombreuses et importantes applications à venir dans la cryptographie.

En complément et non en remplacement

Mais les ordinateurs quantiques ne remplaceront pas les ordinateurs conventionnels, ils les complèteront, les suppléant pour assurer des calculs que ces derniers ne peuvent pas traiter. Bob Sutor, responsable du programme IBM Q propose l’exemple de la molécule de la caféine. Il s’agit d’une molécule relativement simple, seulement 24 atomes. Mais résoudre les équations de la mécanique quantique pour prédire sa structure et sa réactivité, sans faire d’approximations, nécessiterait une capacité informatique de 10^48 bits. Un nombre gigantesque lorsqu’on sait que le nombre d’atomes de la Terre est estimé entre 10^49 et 10^50 bits. Pour modéliser une seule molécule de caféine, il faudrait donc un nombre de bits comparable à 10 % du nombre d’atomes de la planète entière. Ce qui est évidemment impossible. Un ordinateur quantique, qui obéit aux mêmes lois que cette molécule de caféine, pourrait permettre des simulations beaucoup plus fidèles à la réalité.

Les ordinateurs quantiques aideront aussi à mieux comprendre le fonctionnement des ordinateurs classiques et ainsi améliorer leur performance. En 1997, Lov Grover, des laboratoires Bell, a par exemple démontré qu’un ordinateur quantique pourrait considérablement augmenter l’efficacité des algorithmes classiques utilisés pour la recherche d’informations sur une base de données. Mais ils permettront aussi d’améliorer les ordinateurs quantiques eux-mêmes « bien que nous n’en soyons pas encore là », reconnait Bob Wisnieff. La machine qui améliore la machine n’est pas un thème nouveau mais il prend une dimension nouvelle avec les ordinateurs quantiques.

Accéder à un ordinateur quantique via un ordinateur conventionnel

L’autre réalité des ordinateurs quantiques est qu’ils n’auront pas de fonctionnement indépendant. L’accès ne se fera que par l’intermédiaire d’un ordinateur conventionnel. C’est dans cet objectif qu’IBM a développé Qiskit, un framework logiciel open source. Qiskit fournit des outils permettant de créer et de manipuler des programmes quantiques et de les exécuter sur des systèmes et des simulateurs quantiques.

A l’autre bout du spectre, Qiskit Terra fournit des outils pour créer des circuits quantiques à un niveau proche du code de la machine quantique. Il permet aux processus fonctionnant sur du matériel quantique d’être explicitement construits en termes de portes quantiques, les opérations faites au niveau des qubits. Qiskit comporte également d’autres outils pour des besoins particulier comme Aer ou Ignis pour étudier respectivement la simulation ou la caractérisation.

Avantage quantique

A partir de combien de qubits un ordinateur quantique surpasse-t-il son homologue classique ? La réponse à cette question détermine ce que l’on appelle l’avantage quantique. En réalité, le simple nombre de qubits ne décrit que partiellement la réalité. IBM a proposé la notion de volume quantique qui prend en considération deux principaux facteurs : le nombre de qubits et leur qualité (qui regroupe plusieurs critères).

Pour atteindre de ce stade d’avantage quantique, il faudra non seulement selon augmenter le nombre de qubits mais aussi améliorer la qualité de ces puces d’un genre très particulier dont il est très difficile de contrôler le comportement. D’où l’idée de s’appuyer sur des qubits logiques plutôt que de qubits physiques.

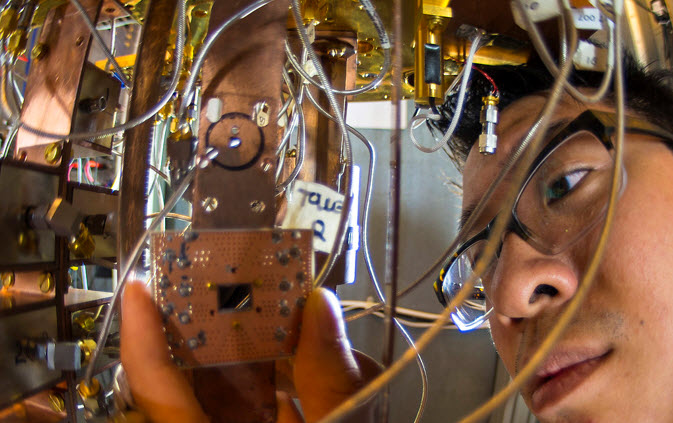

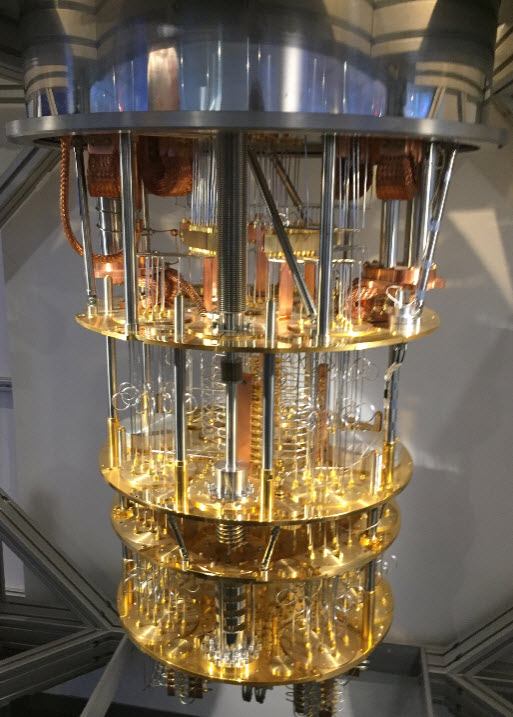

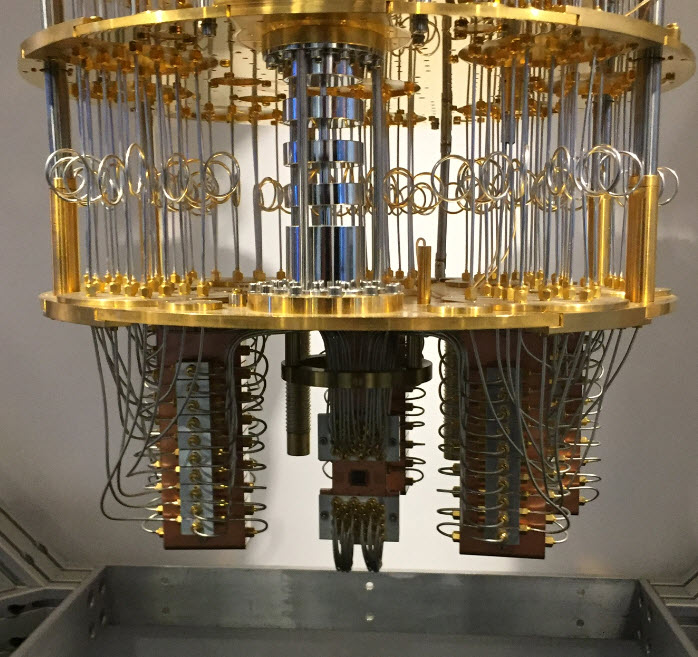

Un qubit physique, c’est le composant qui est intégré dans le système qui est fait une sorte de gros réfrigérateur. A l’intérieur c’est ce qu’IBM appelle le chandelier et qui permet de passer d’une température de 4 Kelvin en haut à 10 millikelvin en bas, là où fonctionnent les puces. Le qubits physique est un objet qui se dérègle en permanence, ce qui entraine plein d’erreur dans le calcul (c’est pareil pour un ordinateur classique, mais là les erreurs sont des évènements beaucoup plus rares). L’architecture de la puce est donc conçue de telle manière à ce qu’il y ait de la correction d’erreurs. Il y a des qubits qui servent à faire tourner un calcul, et des qubits supplémentaires qui sont là juste pour vérifier s’il n’y a pas d’erreur, et pour les corriger au cas où. Les récents progrès réalisés sont prometteurs même IBM reste très prudente sur les résultats à venir.

puis

puis