La branche intelligence artificielle de Google explore le potentiel du « reinforcement learning » de multiples façons. À commencer par les jeux vidéos. Et sa dernière IA est devenue imbattable sur les hits rétrogaming de la cultissime console Atari VCS.

En matière de recherches autour des possibilités des IA, le jeu vidéo tient une place particulière. Bien sûr, les jeux modernes utilisent de plus en plus d’IA pour produire des environnements plus réalistes par exemple (à l’instar de ce que l’équipe française d’Asobo Studio est en train de réaliser sur l’époustouflant Flight Simulator 2020) ou créer des personnages non jouables aux comportements plus intelligents. Mais ce n’est pas ici le sujet. Les chercheurs s’intéressent aux jeux vidéos parce qu’ils sont souvent un terrain d’étude idéal pour comprendre et améliorer les techniques de « reinforcement learning » (RL). L’ « apprentissage par renforcement » est une des nouvelles technologies de « Machine Learning » permettant d’entraîner des réseaux de neurones sans intervention humaine grâce à une méthode où l’IA apprend de ses propres erreurs. Le jeu vidéo se prête bien au concept puisque l’objectif est assez binaire : perdre ou gagner.

Ainsi, en 2018, les chercheurs d’OpenAI avaient appris à 5 réseaux neuronaux à jouer au jeu DOTA 2 en s’entraînant ensemble et en acquérant ainsi, parties après parties, à acquérir un comportement stratégique pour jouer en équipe et être capable de rivaliser contre les meilleures équipes de joueurs humains. L’objectif de l’expérience « OpenAI Five » était de démontrer que des réseaux de neurones peuvent collaborer afin d’élaborer des stratégies gagnantes et mieux appréhender la complexité du monde réel avec ses incertitudes.

Ainsi, en 2018, les chercheurs d’OpenAI avaient appris à 5 réseaux neuronaux à jouer au jeu DOTA 2 en s’entraînant ensemble et en acquérant ainsi, parties après parties, à acquérir un comportement stratégique pour jouer en équipe et être capable de rivaliser contre les meilleures équipes de joueurs humains. L’objectif de l’expérience « OpenAI Five » était de démontrer que des réseaux de neurones peuvent collaborer afin d’élaborer des stratégies gagnantes et mieux appréhender la complexité du monde réel avec ses incertitudes.

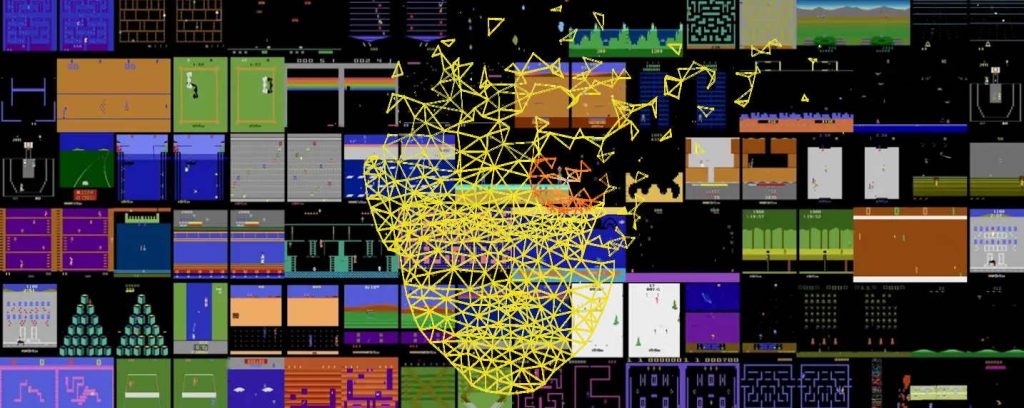

De son côté, DeepMind, la filiale de Google spécialisée dans l’IA travaille depuis 2012 autour d’un ensemble de 57 jeux issus des glorieux jours de la console Atari VCS 2600. Cet ensemble présente à la fois des objectifs clairs qui sont alignés avec les principes du RL mais aussi une diversité de défis qui laisse entrevoir le potentiel de la technologie. L’objectif est de s’en servir comme tremplin vers un développement de systèmes intelligents capables d’exceller sur toute une variété de challenges plus professionnels.

Et cela fait déjà plusieurs années que des équipes de chercheurs s’affairent à exposer leurs IA face aux jeux de l’ancestrale console. En 2017, une IA de Microsoft Research avait ainsi réussi le score parfait à Ms Pac-Man, atteindre 999 990 points… Un score qu’aucun humain n’avait jamais atteint en 36 ans d’existence du jeu. Depuis 2015, l’équipe de DeepMind tente de son côté de faire de son « Deep Q-Network » (DQN) un as des jeux Atari VCS. Le système avait fini par maîtriser 49 des 57 jeux. Avec ses successeurs (R2D2 en 2018 et NGU Never Give Up en 2019), Deep Mind avait battu des records sur 52 des 57 jeux de la sélection évoquée plus haut.

Mais des hits classiques comme Skiing, Solaris, Montezuma’s Revenge ou encore le célèbre Pitfall continuaient à défier les capacités de leur IA. Car pour réussir sur ces jeux, le système doit être en mesure de résoudre deux difficultés complexes à appréhender par les systèmes RL : le dilemme de l’exploration-exploitation et le problème de l’attribution de crédits à long terme.

Mais des hits classiques comme Skiing, Solaris, Montezuma’s Revenge ou encore le célèbre Pitfall continuaient à défier les capacités de leur IA. Car pour réussir sur ces jeux, le système doit être en mesure de résoudre deux difficultés complexes à appréhender par les systèmes RL : le dilemme de l’exploration-exploitation et le problème de l’attribution de crédits à long terme.

L’exploration-exploitation soumet l’IA à un dilemme : faut -il reproduire un comportement qui s’est parfois avéré gagnant ou au contraire explorer de nouvelles stratégies permettant d’atteindre de meilleurs scores ? Les jeux Montezuma’s Revenge et Pitfall sont très révélateurs de ce problème. L’IA doit explorer en divisant son action en micro-actions qui ne sont pas forcément optimales afin d’acquérir au final en les agrégeant une compréhension menant à une stratégie plus payante. Bref elle doit découvrir les stratégies qui marchent sur le long terme et pas uniquement à court terme. Typiquement, à Montezuma’s Revenge, l’intelligence DQN en avait conclu que sa meilleure stratégie était de ne simplement pas bouger : elle survivait certes, mais son score restait indéfiniment à zéro et elle n’explorait rien du vaste univers des jeux. Il a fallu apprendre aux nouvelles intelligences artificielles la notion de motivation.

La dernière IA de DeepMind, dénommée « Agent57 », vise justement à réussir là où les IA précédentes avaient échoué et donc à gérer les deux problèmes fondamentaux évoqués ci-dessus.

En améliorant les techniques d’apprentissage par renforcement et en les enrichissant de mécanismes complémentaires (comme un méta-contrôleur agrégeant de multiples agents IA), ils ont réussi avec « Agent57 » à battre les high-scores réalisés par les humains sur les 57 jeux de la liste établie en 2012.

Au-delà des scores et de la performance ludique, ces recherches permettent d’affiner et enrichir les techniques de « reinforcement learning » qui se révèlent de plus en plus indispensables pour permettre à des IA d’appréhender non seulement la complexité intrinsèque du monde réel mais aussi ses aspects imprédictibles et ses incertitudes. Elles trouveront par exemple des applications concrètes dans l’assistance à l’organisation du travail personnel, l’optimisation du trafic routier, ou encore la gestion de portefeuilles boursiers.

En attendant, vous pouvez toujours vous replonger dans l’univers de ces jeux à travers Atari Vault sur PC, Flashback Classics sur Switch ou encore les multiples émulateurs rétrogaming du marché.

Source : Agent57 : Outperforming the human Atari Benchmark

puis

puis