Complément indispensable de l’IoT et logique du cloud, l’Edge computing représente une nouvelle vague de décentralisation d’une l’informatique qui se doit d’être au plus près de la donnée

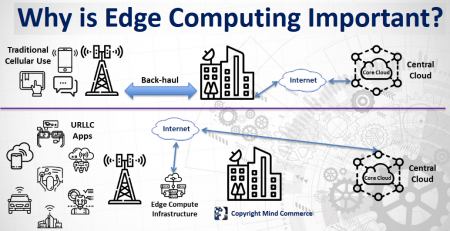

Depuis une cinquantaine d’années, l’informatique a connu plusieurs vagues technologiques, entraînant successivement des tendances à centralisation et à la centralisation. On pouvait penser que le cloud allait marquer définitivement concentration sur quelques grandes data centers gérés par une poignée d’opérateurs. En quelques années, on est passé du cloud au multicloud et/ou au cloud hybride. Et puis est apparu une nouvelle forme d’informatique dite Edge computing censée se situer à la périphérie. « Un des problèmes est que chacun à sa propre définition de l’Edge computing, expliquait Gerry Christensen, CEO de la société Mind Commerce lors de la conférence Global Summit IT organisée par le cabinet NetEvents. Ce peut être un simple smartphone, un wearable, un système doté de la puisssance de calcul ou encore une extension d’un data center »

Depuis une cinquantaine d’années, l’informatique a connu plusieurs vagues technologiques, entraînant successivement des tendances à centralisation et à la centralisation. On pouvait penser que le cloud allait marquer définitivement concentration sur quelques grandes data centers gérés par une poignée d’opérateurs. En quelques années, on est passé du cloud au multicloud et/ou au cloud hybride. Et puis est apparu une nouvelle forme d’informatique dite Edge computing censée se situer à la périphérie. « Un des problèmes est que chacun à sa propre définition de l’Edge computing, expliquait Gerry Christensen, CEO de la société Mind Commerce lors de la conférence Global Summit IT organisée par le cabinet NetEvents. Ce peut être un simple smartphone, un wearable, un système doté de la puisssance de calcul ou encore une extension d’un data center »

Pour Gartner, « l’Edge computing représente un modèle de calcul qui permet d’optimiser et de décentralisation extrême, en plaçant les noeuds les plus proches possibles des sources de données et du contenu. En tant qu’approche décentralisée, il est un complément parfait à la tendance des fournisseurs de cloud HyperScale vers la centralisation. Le risque pour les entreprises est de concevoir et de mettre en œuvre des réseaux, des systèmes et des applications de nouvelle génération, sans tenir compte des possibilités de déploiement à la périphérie, en ignorant les avantages apportés par la décentralisation en faveur d’un data center centralisé ou d’un opérateur HyperScale ».

« Avec l’edge computing, l’objectif est de stocker les données là où elles sont produites et d’en faire un premier traitement avant de les transférer vers un data center, qu’il soit cloud public ou privé, explique Sreelakshimi Sarva, responsable de la stratégie produits de NetFoundry. Cela, car les applications requièrent un traitement en temps réel ou temps de latence extrêmement faible ». Parmi les exemples, on peut citer les véhicules autonomes. Ce qui nécessite une architecture permettant à ces applications de communiquer avec les data centers des entreprises ou des opérateurs de cloud selon une façon adaptée. Mais il y en a bien d’autres : Smart cities, buildings, homes and workplaces ; UAV (Unmanned aerial vehicle) operations ; Cloud based gaming ; Vehicle-to-Vehicle (V2V) communications, apps, and services.

Kevin Deierling, responsable du marketing de Mellanox propose l’analogie du système de vision. « L’œil n’est pas un simple transmetteur d’information vers le cerveau comme pourrait l’être une simple caméra. Par l’intermédiaire de la rétine, il réalise de nombreux traitements comme détecter les mouvements, les directions en haut, en bas, à droite, à gauche, détecter la symétrie bilatérale. Et il transmet les résultats aux Cortex qui finalise les traitements et autorise la vision ».

Kevin Deierling, responsable du marketing de Mellanox propose l’analogie du système de vision. « L’œil n’est pas un simple transmetteur d’information vers le cerveau comme pourrait l’être une simple caméra. Par l’intermédiaire de la rétine, il réalise de nombreux traitements comme détecter les mouvements, les directions en haut, en bas, à droite, à gauche, détecter la symétrie bilatérale. Et il transmet les résultats aux Cortex qui finalise les traitements et autorise la vision ».

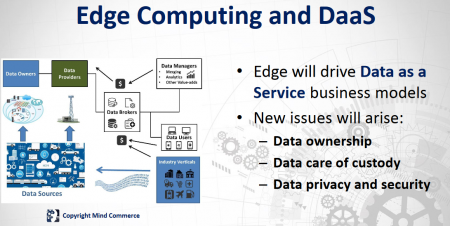

« Globalement, les deux défis qui se poseront dans les applications d’IoT sont le coût et le respect de la vie privée » poursuit-il. Défis auxquels il faut ajouter celui de l’automatisation, car il deviendra rapidement impossible de gérer toutes ces applications manuellement, estime Gerry Christensen, sans oublier la sécurité qui va devenir cruciale. Car les systèmes d’Edge computing, notamment les objets connectés augmentent considérablement le périmètre d’attaques ».

Kevin Deierling raconte son expérience lorsqu’il était directeur technique de Silver Spring, une entreprise israélienne spécialisée dans le développement des parcmètres intelligents. « D’origine russe, le responsable de la sécurité de Silver Spring était totalement paranoïaque sur ces questions et a décidé de faire développer un composant générant des nombres aléatoires et définissant ses propres clés. J’ai conçu ce composant et je ne peux même pas casser les parcmètres ».

Exemples d’annonces récentes d’Edge Computing

Stratus Technologies

Stratus Technologies a récemment fait évoluer sa plateforme d’Edge Computing ztC 110i. Les premières unités de la plateforme nouvelle génération ont été livrées au distributeur britannique Routeco pour une compagnie minière utilisant le logiciel Rockwell Automation afin de contrôler et surveiller la puissance électrique de son site.

Le ztC Edge 110i, plus puissant, s’adresse aux entreprises recherchant des capacités de traitement et de stockage de données à la périphérie du cloud plus importantes. Contrairement aux passerelles réseau, ztC Edge est conçu pour les applications métiers critiques, y compris celles qui prennent en charge la collecte et l’analyse de données en temps réel à la périphérie.

Atos

En mai dernier, Atos dévoile le serveur Edge le plus puissant, Une boîte grande comme un gros livre qui fournit 160 Tflops en simple précision. « C’est un véritable mini cloud », avait déclaré alors Thierry Breton, Pdg d’Atos.

Le BullSequana Edge est conçu pour être utilisé en toute sécurité pour l’Internet des Objets (IoT), dans des environnements où les temps de réponse rapides sont critiques – tels que l’industrie 4.0, les véhicules autonomes, la santé et la sécurité des commerces et des aéroports – et pour lesquels les données doivent être traitées et analysées à proximité de la source d’origine en temps réel. C’est un concentré de technologie qui fort de son processeur Xeon Intel, de ses deux GPU Nvidia et une capacité de stockage qui peut aller jusqu’à 24 To de stockage offre 160 TFlops en simple précision pour des applications d’intelligence artificielle et de Machine Learning. Fait significatif, plus de 90 % de la puissance de ce serveur est fournie par les GPU.

HPE

Il y a quelques mois, HPE a fait quelques annonces pour impulser la prochaine vague d’adoption de l’Intelligent Edge. Dans les environnements industriels, l’Intelligent Edge nécessite une interaction complexe entre des capteurs, des actionneurs, des réseaux, des applications et des infrastructures, allant de la périphérie du réseau au cloud (« Edge to Cloud »). Cela présente également des défis spécifiques, notamment des conditions ambiantes extrêmes, une connexion intermittente au réseau et un manque de personnel qualifié sur site.

Pour simplifier, accélérer et sécuriser ces déploiements, HPE lance des solutions Edge to Cloud clés en main, pré-intégrées, en collaboration avec des partenaires du secteur (ABB, Microsoft et PTC)

__________

Quelques articles récents sur l’Edge Computing

- L’avenir de l’IoT industriel passe par l’Edge computing

Emmanuel Privat, Software AG - L’Edge computing et le besoin en compétences réseaux

Sévérine Hanauer, Vertiv France - Edge, data center et hybrid data, ou comment répondre à l’explosion de la production de données ? Yves Pellemans, Axians

- L’Edge computing est-il l’avenir de l’IoT ?

William Biotteau, Toshiba

puis

puis