Tel est le slogan de Mellanox qui entend faire du réseau la partie essentielle des ordinateurs confrontés à la loi de Moore qui atteint ses limites et obligent les concepteurs à repenser complètement les systèmes informatiques.

Dans le même temps, la société israélienne Waze se lança sur cette activité avec une approche radicalement différente. Le système a connaissance de la vitesse instantanée de tous les utilisateurs connectés ayant téléchargé l’application permettant ainsi de détecter en temps réel, les ralentissements et vitesses moyennes par tronçon du parcours. L’application propose alors un itinéraire plus rapide lorsque c’est possible. Les utilisateurs de l’application peuvent également signaler un accident, des travaux, un danger, un embouteillage, un radar ou le prix du carburant de chaque station-service ; le système avertit alors les automobilistes devant emprunter la même route. Pour Waze, les données sont fournies gratuitement par les utilisateurs. Google racheta Waze pour 1 milliard de dollars et l’application éponyme devient l’un des systèmes de navigation préféré des automobilistes. Parallèlement, Nokia qui a en plus raté le virage des smartphones fut condamné à quitter ce marché contrôlé aujourd’hui par Samsung, Apple et les constructeurs chinois.

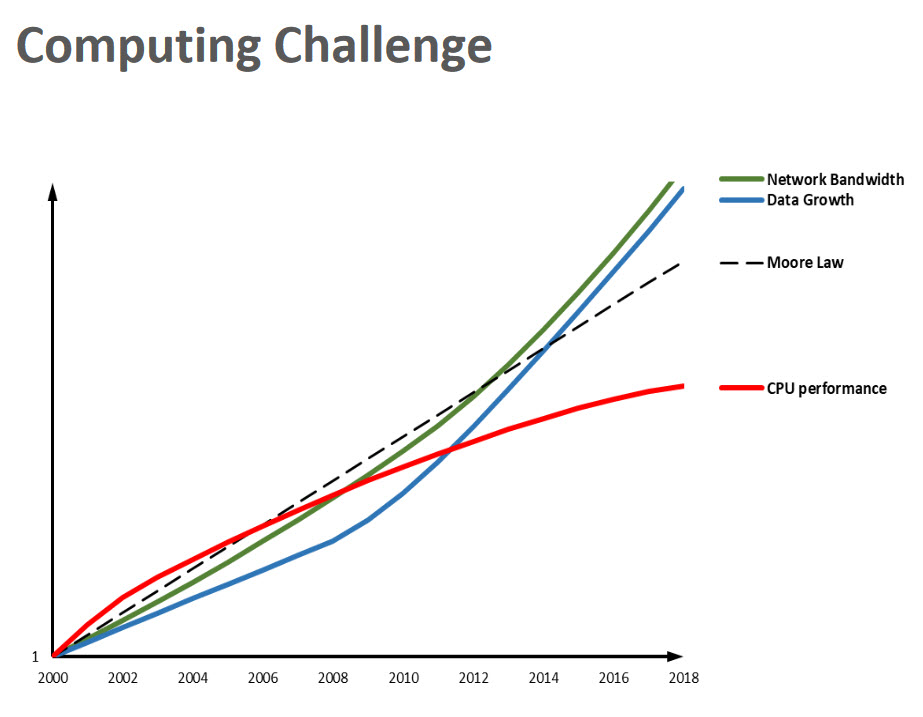

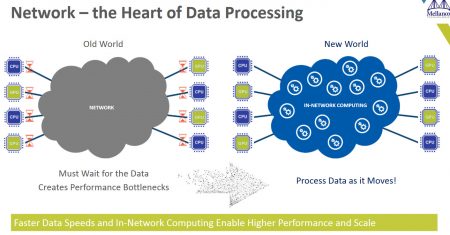

« Le volume des données croit plus vite que la loi de Moore et les performances des microprocesseurs » constate Michael Kagan. Mais la bonne surprise est que la performance et le débit des réseaux permettent de compenser ce décalage croissant. C’est le vieux rêve exprimé par John Gage, ex-directeur de la recherche chez Sun Microsystems avec son slogan devenu célèbre : The Network is the Computer. Pour faire en sorte que le réseau devienne le moteur des ordinateurs et permette de tirer parti de la puissance de centaines de CPU et de processeurs spécialisés, il faut repenser l’architecture des systèmes. Pour Michael Kagan, il faut passer d’une architecture basée sur un processeur central à une architecture de réseaux d’ordinateurs dans laquelle les interconnexions jouent un rôle essentiel, pas seulement pour transférer le plus grand volume de données en un temps le plus court possible mais aussi en traitant les données à la volée pour optimiser le fonctionnement du système. Et en même temps, passer du programme, comme élément principal permettant de faire fonctionner les systèmes, aux données, à leur analyse et à leur traitement.

Et c’est là où Mellanox va jouer un rôle croissant dans les architectures des ordinateurs. Oracle a complètement réécrit la version cluster de son application Oracle Real Application Clusters (RAC) pour passer des réseaux 10G au 40G et l’éditeur aurait constater une amélioration d’un facteur 50 grâce à une optimisation des performances.

Autre manière d’utiliser la technologie Mellanox, Baidu a déployé les GPU Nvidia et les interconnexions Mellanox dans le développement d’un système de reconnaissance d’images. Et aujourd’hui, les ordinateurs sont meilleurs que les humains dans cette tâche avec un taux d’erreurs plus faible.

L’autre élément qui permettra d’exploiter ces données générées par les différents éléments du système est l’intelligence artificielle et plus particulièrement le Machine Learning. Avec la possibilité que le système apprenne à fonctionner à partir des données qu’il génère. La reconnaissance d’image ou la traduction automatique se sont améliorées grâce à cette nouvelle approche. C’est la visualisation de millions de chats qui permet de reconnaitre un chat parmi d’autres animaux plus que par la description abstraite et théorique de l’animal.

Cette nouvelle approche permet d’affecter les ressources disponibles (processeurs, stockage, réseau) aux applications et de traiter les données partout, pas seulement au niveau des processeurs mais aussi à celui du stockage et des réseaux et de renforcer la sécurité sur l’ensemble du système. Jusqu’ici l’approche classique était de mettre un firewall pour sécuriser le data center. C’est le modèle M&M : dur à l’extérieur et mou à l’intérieur. De telle sorte que si quelqu’un arrive à pénétrer à l’intérieur du data center, il peut faire beaucoup de dégâts. Il faut radicalement changer de modèle et protéger l’ensemble des composants du data center. C’est ce que propose Mellanox avec sa technologie BlueField SmartNIC qui permet de déployer ce que le constructeur appelle le Software-defined Network Accelerated Processing ou SNAP), autrement dit permettre à tous les éléments du système de traiter les données. L’autre élément pour tirer parti de cette nouvelle approche est la virtualisation qui permet aux applications de s’affranchir de l’infrastructure physique.

puis

puis