Depuis l’apparition de ChatGPT, bien des DSI, RSSI et DPO s’inquiètent de l’origine des données exploitées pour l’entraînement des modèles, de l’exploitation qui est faite des échanges avec l’IA, et des usages non conformes qu’en font les utilisateurs. Une étude Netskope montre qu’ils ont bien raison.

Avec ChatGPT Teams et Entreprise, Copilot Pro, Gemini Pro et bien d’autres services payants, les entreprises ont l’assurance que les données échangées avec les IA génératives ne sont pas réexploitées pour l’entraînement des futurs modèles. Tout au moins en théorie. Pour ceux qui veulent plus d’assurance, il est toujours possible de s’orienter vers des solutions Cloud plus isolées (Azure Open AI Services, Google Vertex AI, AWS Bedrock) ou des implémentations plus locales encore.

Reste que ces échanges avec les IA génératives publiques peuvent enfreindre les règles de confidentialité de l’entreprise et les règles de conformité notamment à des règlements comme le RGPD en matière de données personnelles.

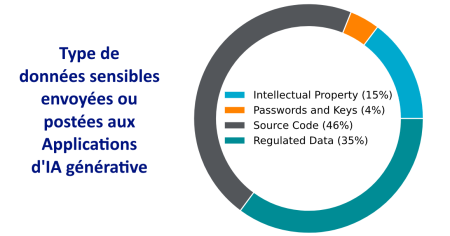

La dernière étude Netskope révèle – sans surprise – une adoption massive des applications d’intelligence artificielle générative (GenAI) par les entreprises. Elle met aussi et surtout en avant les risques significatifs liés à la sécurité des données suite à un usage inapproprié de ces IA. Le rapport met ainsi en évidence que plus d’un tiers des informations sensibles saisies dans ces applications sont des données personnelles règlementées, posant des défis cruciaux pour la protection des données et la conformité règlementaire.

Irrésistibles IA

Si les entreprises s’interrogent beaucoup sur la réelle pertinence des offres comme Copilot for Office 365 ou Gemini for Workspace – qui, dans les faits, double la facture des outils collaboratifs pour un bénéfice qui ne saute pas aux yeux –, elles n’ont en revanche aucun doute sur l’apport au quotidien des IA génératives dans leurs formes plus conversationnelles comme ChatGPT Plus, Copilot Plus, Gemini Pro, Claude AI ou Mistral Le Chat. Sans oublier les outils plus spécialisés comme GitHub Copilot, Adobe Firefly et autres.

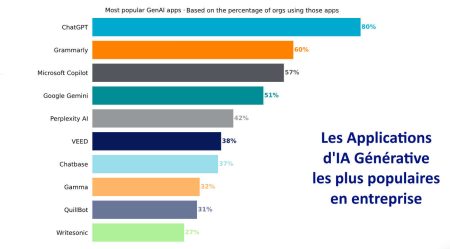

En un an, l’utilisation de ces applications a triplé, passant de 74 % à 96 % des organisations ayant au moins un utilisateur actif selon l’étude Netskope. Ces applications sont utilisées pour diverses tâches, allant de l’aide à la programmation et à la rédaction à la création de présentations et de contenu multimédia en passant par le résumé de documents, l’aide à la rédaction/formulation, le déblocage de la feuille blanche. Ainsi, le nombre moyen d’applications utilisées par organisation a plus que triplé, passant de 3 à 9,6 en seulement 12 mois.

Des risques mal maîtrisés

Cependant, cette adoption rapide s’accompagne de défis majeurs en matière de sécurité des données. L’étude met en lumière un constat alarmant : plus d’un tiers (35%) des informations sensibles saisies dans ces applications sont des données personnelles règlementées.

« Cette situation représente un risque considérable pour les entreprises », explique un porte-parole de Netskope. « Les données règlementées, telles que les informations médicales ou financières, sont soumises à des règles strictes de protection. Leur saisie dans des applications d’IA générative non sécurisées peut entraîner des violations de conformité et des sanctions importantes. »

Face à ces risques, de plus en plus d’organisations adoptent des mesures de sécurité. Selon Netskope, 77% des entreprises bloquent désormais au moins une application d’IA générative, contre 53% l’année dernière. L’utilisation de contrôles de prévention des pertes de données (DLP) a également augmenté, passant de 24% à 42% des organisations.

Des mesures à mettre en place

Face à ces enjeux, Netskope recommande plusieurs mesures pour améliorer la sécurité des données dans le contexte des applications GenAI :

1/ Évaluation des risques : Les entreprises doivent analyser l’utilisation actuelle des applications GenAI et identifier les vulnérabilités potentielles.

2/ Contrôles de prévention : La mise en place de listes d’applications autorisées et de politiques DLP est essentielle pour limiter la transmission de données sensibles.

3/ Formation des utilisateurs : Informer et former les utilisateurs sur les risques associés à l’utilisation des applications GenAI et sur les bonnes pratiques à adopter.

4/ Surveillance continue : Mettre en place des mécanismes de détection des comportements anormaux et des mouvements de données suspects pour prévenir les fuites de données.

Pour Netskope, la très (trop ?) rapide « prolifération des technologies d’intelligence artificielle (IA), en particulier celles basées sur l’IA générative (genAI), a considérablement impacté la gestion des risques dans les entreprises. Bien que l’IA générative promette des gains en matière d’innovation et d’efficacité, elle introduit également des risques substantiels que les organisations doivent aborder de manière proactive. »

Il est temps pour les DSI de reprendre le contrôle de la situation et d’atténuer les risques de manquement aux conformités règlementaires. Netskope les invite à auditer la situation en cours pour identifier les lacunes, à mettre en œuvre des contrôles essentiels et élémentaires, à planifier des contrôles plus avancés et à évaluer régulièrement l’efficacité des mesures mises en œuvre alors que l’IA générative va continuer de progresser et de s’infiltrer dans toujours plus de processus.

puis

puis