La course à l’innovation IA bât son plein et Meta ne compte pas s’en laisser compter par les HPC IA gigantesques que construisent Azure, Google Cloud, AWS ou encore NVidia. La maison mère de Facebook a dévoilé deux nouveaux HPC et sa roadmap pour l’IA…

Sans aucun doute plus discret que Microsoft, Google ou OpenAI, Meta n’en demeure pas moins l’un des acteurs majeurs de l’IA et de l’IA générative. Bien sûr, de l’IA, Meta en utilise pléthore pour animer, surveiller, monétiser ses réseaux sociaux. Mais on doit aussi à son labo de R&D « FLAIR » certains des modèles génératifs les plus utilisés et les plus diffusés (ils sont généralement open source) à l’instar de LLama 2.

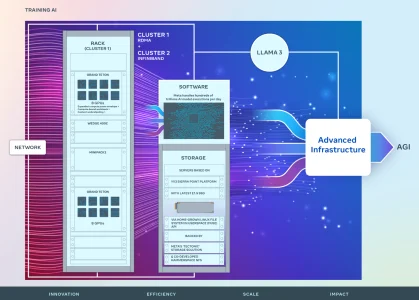

C’est justement essentiellement pour soutenir ces efforts de R&D que Meta annonce avoir investi dans deux nouveaux clusters de calculs, deux nouveaux HPC dédiés à l’IA, équipés chacun de 24 576 GPU ! L’un des clusters est d’ailleurs déjà opérationnel et déjà utilisé pour entraîner le prochain modèle Llama 3 de Meta.

Ces clusters dérivent des travaux réalisés pour élaborer l’AI Research SuperCluster (Metat AI RSC) construit en 2022 et doté de 16.000 GPU NVidia A100.

Les deux variantes de clusters se distinguent par leur technologie de réseau. Le cluster actuellement utilisé pour l’entraînement du modèle Llama 3 exploite RDMA sur RoCE, tandis que l’autre utilise le Quantum2 InfiniBand de NVIDIA. Les clusters sont également équipés d’un système de stockage flash personnalisé, basé sur le système de fichiers Tectonic de Meta, pour gérer les E/S synchronisées nécessaires pour les points de contrôle de milliers de GPU.

L’un des défis majeurs rencontrés par Meta avec ces nouveaux clusters est la difficulté de déboguer du code réparti à si grande échelle (sur des milliers de GPU). Pour relever ce défi, Meta a collaboré avec Hammerspace pour construire un « enregistreur de vol collectif distribué » et des outils de débogage interactifs..

Meta ne compte cependant s’arrêter en si bon chemin. Ces deux clusters ne sont qu’une première étape dans son ambitieuse roadmap d’expansion de son infrastructure AI qui prévoit d’atteindre d’ici la fin de l’année 2024, 350 000 GPU NVIDIA H100 déployés ! Il n’en faudra pas moins pour avancer sur le « encore » long chemin qui doit mener aux AGI (Artificial General Intelligence) et AMI (Advance Machine Intelligence).

puis

puis