Microsoft Research publie en open source un nouveau moteur de Deep Learning qui prétend révolutionner les traitements en langage naturel. Il est au cœur des fonctionnalités de recherches sémantiques et de génération automatique de résumés du « Project Turing », prochainement intégrées à Bing et Office.

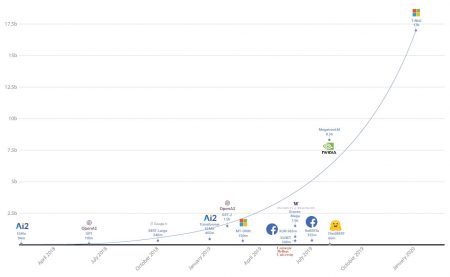

Dans les coulisses de l’intelligence artificielle, se jouent de véritables guerres algorithmiques entre petits et grands acteurs pour construire des réseaux de neurones toujours plus sophistiqués.

Un peu à la surprise générale, Microsoft Research vient de publier deux articles de blog autour d’un nouveau moteur de deep learning orienté NLP dont les performances s’annoncent très significativement supérieures à ce que l’on connaissait jusqu’ici.

Un nouveau moteur pour des IA 10 fois plus « intelligente »

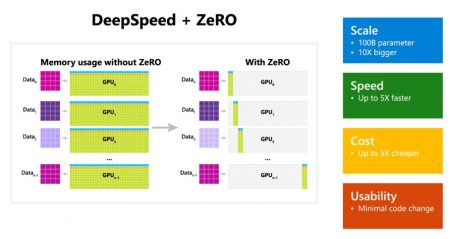

Dénommée « DeepSpeed », cette bibliothèque est typiquement adaptée aux traitements du langage naturel. Optimisée pour une exécution par GPU, elle intègre une nouvelle technologie dénommée ZeRO (Zero Redundancy Optimizer), un optimiseur parallélisé qui réduit considérablement les ressources nécessaires aux modèles.

Selon Microsoft Research, DeepSpeed excelle sur quatre aspects fondamentaux :

* La scalabilité : DeepSpeed supporte l’apprentissage et l’exécution de modèles comportant jusqu’à 100 milliards de paramètres soit 10 fois plus que les meilleurs moteurs actuels (Google T5 supporte 11 milliards de paramètres, NVidia Megatron-LM 8 milliards, et OpenAI GPT-2 moins de 2 milliards).

* La vitesse : DeepSpeed se montrerait 5 fois plus rapide que Megatron-LM dont il hérite des parallélismes.

* Les coûts : DeepSpeed nécessite 3 fois moins de ressources pour l’entraînement de modèles de 20 milliards de paramètres.

* La simplicité : Microsoft Research prétend qu’il n’y a besoin de changer que quelques lignes de codes pour permettre à un modèle PyTorch existant d’exploiter tout le potentiel du duo « DeepSpeed + ZeRO ».

Un moteur au cœur de « Project Turing »

Contrairement à DeepSpeed et ZeRO publiés en open-source sur GitHub, le moteur T-NLG est lui jalousement conservé par Microsoft puisqu’il s’agit d’une brique fondamentale de « Project Turing », un nouvel ensemble de fonctionnalités IA qui seront progressivement intégrées à Bing, Office 365, XBox et à d’autres produits Microsoft dont le moteur de recherche d’entreprise « Project Cortex » présenté lors de la dernière conférence MS Ignite. La publication de toutes ces informations laisse à penser que les fonctionnalités de Project Turing ne tarderont plus à apparaître…

Pour en savoir plus :

* ZeRO & DeepSpeed: New system optimizations enable training models with over 100 billion parameters

* Turing-NLG: A 17-billion-parameter language model by Microsoft

puis

puis