Avec Mistral Compute, Mistral AI met sur le marché une infrastructure IA complète, fondée sur la souveraineté numérique et la maîtrise de bout en bout. De quoi séduire les DSI en quête d’une infrastructure IA performante, conforme, durable et facile à mettre en œuvre.

La force de Nvidia dans l’IA d’entreprise tient moins à ses GPU qu’à l’omniprésence de sa stack logicielle « Nvidia Enterprise AI » devenue pilier de bien des offres « clés en main » et une garantie d’autonomie et de liberté de placement de l’IA.

Et bien, la jeune pousse française Mistral AI démontre une nouvelle fois qu’elle n’a pas froid aux yeux et pas peur d’aller directement affronter les géants américains et chinois sur leurs terrains de jeux.

Après avoir démocratisé l’accès aux modèles, elle démocratise désormais l’accès aux infrastructures IA. Avec Mistral Compute, Mistral AI propose aux entreprises et organisations publiques européennes d’appuyer leurs projets IA sur l’infrastructure IA que la jeune pousse a développée pour servir ses propres besoins afin de relever les défis de rareté et de coût élevé des GPU, de sécurité et conformité des workloads IA ou encore de gestion des outils !

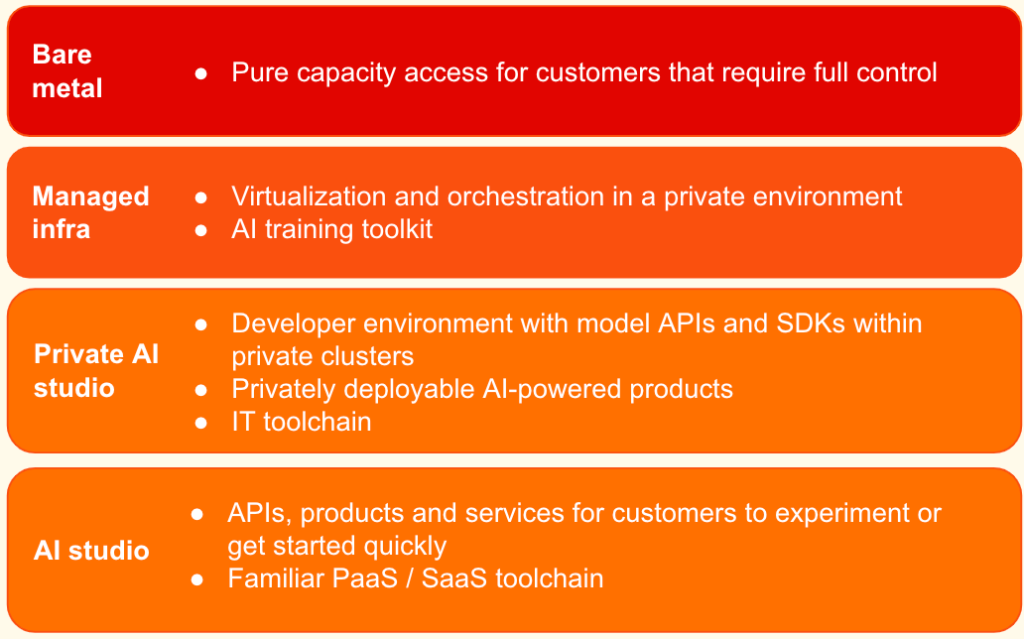

Ainsi, Mistral Compute est une offre d’infrastructure qui fournit aux organisations une stack privée et intégrée complète qui comporte des GPU, des outils d’orchestration, des API, des produits, des modèles et des services adaptés à tous les besoins.

L’offre se décline en pratique en quatre formes de services selon la maturité et les besoins des organisations allant de la simple solution « Bare Metal » (pour disposer de cluster GPU à la demande) à la solution « PaaS/SaaS » dénommée « AI Studio » en passant par une infra managée soit simplement pour entraîner des modèles, soit pour supporter tout le développement d’applications IA. L’idée est donc bien d’offrir aux entreprises et organisations une plateforme hébergée et gérée en Europe, dédiée à l’IA afin d’entraîner, personnaliser, fine-tuner ou dériver des modèles à commencer par ceux de Mistral AI, offrant différents niveaux de services et d’infrastructure managée, afin de garantir « une autonomie stratégique » et « renforcer le leadership tech IA européen ».

« Mistral Compute permet aux États souverains, aux entreprises et aux institutions de recherche de réinventer complètement la façon dont ils construisent leur infrastructure IA. Ce qui était auparavant un choix limité entre quelques fournisseurs cloud tiers devient désormais le droit de construire son environnement IA selon ses propres spécifications et de le maîtriser de bout en bout. L’offre intègre toute la suite d’entraînement de Mistral AI. Elle vise à accélérer les efforts d’IA spécifiques à une région ou à un domaine dans des secteurs stratégiques nationaux et industriels tels que les technologies de défense, la découverte pharmaceutique, les marchés financiers, et bien plus encore » explique l’éditeur.

Techniquement, l’offre Mistral Compute va d’abord se concrétiser dans le datacenter que monte Mistral AI en collaboration avec Nvidia et qui doit notamment comporter 18.000 processeurs « Grace Blackwell ». L’infrastructure devrait être opérationnelle début 2026.

Mais un élément reste pour l’instant sans réponse : Mistral Compute est-elle une offre limitée à ses datacenters ou est-ce que Mistral envisage d’en faire une stack IA logicielle plus universelle qui pourrait être à terme déployée « on-premises » ou sur d’autres clouds.

puis

puis