Comprendre le langage des animaux… Voilà un vieux rêve de l’humanité que l’IA est en passe de concrétiser. Les chercheurs de Google Cloud ont mis au point un modèle LLM spécialisé dans la compréhension des dauphins… en attendant d’autres animaux ?

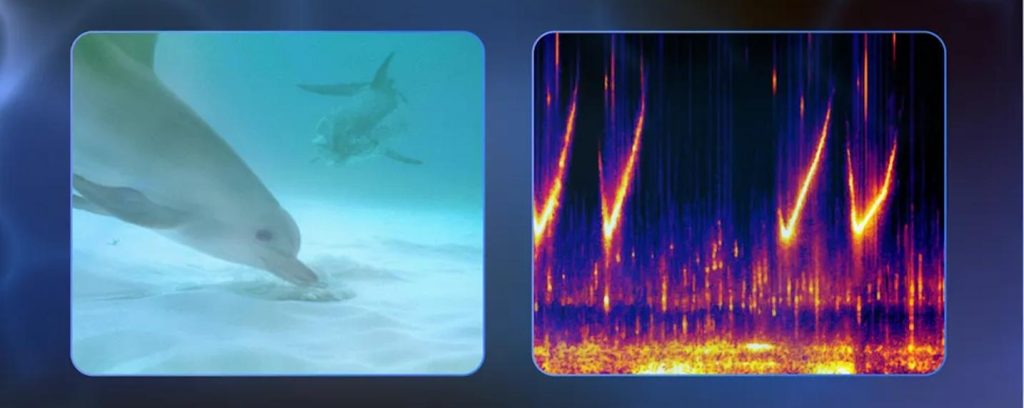

D’une manière générale, les animaux sont assez doués pour se faire comprendre mais leurs cris, leurs cliquetis, leurs sifflements, restent pour le moins énigmatiques aux humains. Qu’est-ce qui se cache derrière chaque son émis ? Pour Google, l’IA peut nous venir en aide. Et pour le prouver, les chercheurs de DeepMind viennent de développer DolphinGemma, un modèle audio génératif taillé pour le terrain et entraîné sur quatre décennies de données collectées par le Wild Dolphin Project dans les eaux claires des Bahamas. Depuis 1985, cette ONG filme et enregistre sous l’eau la même communauté de dauphins tachetés, reliant chaque sifflement, clic ou « squawk » à l’animal émetteur et à la scène observée. Ce corpus, devenu l’une des bases les plus riches jamais constituées sur des cétacés sauvages, sert aujourd’hui de carburant à DolphinGemma, un modèle IA de 400 millions de paramètres.

Son fonctionnement s’apparente à celui des grands modèles de langage : le système analyse les séquences sonores naturelles des dauphins pour identifier des modèles, des structures et prédire les sons susceptibles de suivre dans une séquence. Cette capacité prédictive permet de découvrir des structures cachées et des significations potentielles dans la communication naturelle des dauphins. Pour permettre à DolphinGemma de s’entraîner et de reconnaître les sons, un tokenizer « SoundStream » (un codec neuronal) se charge de représenter les sons sous forme de Tokens. Le signal audio continu est transformé en une suite « d’acoustic tokens » ce qui permet de fournir au modèle LLM une séquence symbolique analogue à des phonèmes numériques.

L’avantage de se baser sur « Gemma » est qu’il s’agit d’un modèle ultra-compact qui peut être exécuté en local sur un smartphone. Les chercheurs l’ont ainsi intégré à un smartphone Pixel de Google lui-même connecté à un ordinateur amphibie dénommé CHAT (Cetacean Hearing Augmentation Telemetry). Ce dernier est pour le moment essentiel parce qu’il produit des sons que les dauphins peuvent reproduire, ce qui permet de définir un vocabulaire commun.

Expérimentations en cours

DolphinGemma se charge de reconnaître les sons et de fournir aux humains la traduction de ce que le dauphin exprime à partir du vocabulaire commun qui lui a été enseigné via CHAT.

Des tests avancés doivent être réalisés durant l’été 2025 afin de confirmer que les dauphins adoptent bien les nouveaux mots et savent les réexploiter pour formuler leurs envies.

Ces recherches s’inscrivent dans une nouvelle tendance qui vise à exploiter le potentiel de l’IA pour déchiffrer la communication animale. Récemment, l’organisation EarthSpecies a développé NatureLM-audio, un modèle de langage audio destiné à permettre de reconnaître les cris et sons des animaux.

Le projet CETI (Cetacean Translation Initiative) a développé une IA qui identifie des motifs et structures linguistiques dans les séquences de « clics » émis par les cachalots.

D’autres recherches sont également effectuées sur les sons des phoques, des éléphants, des corbeaux, des orangs-outans, des chiens (projet Zoolingua), des lémuriens (projets DeepSqueak et Traini), etc.

Au-delà des défis techniques, ces recherches soulèvent aussi des défis éthiques. Certains s’inquiètent déjà des risques liés à une mauvaises interprétation des signaux des animaux et d’autres alertent déjà sur les risques de voir ces IA être utilisées pour exploiter, manipuler (à des fins commerciales, de divertissement voire militaires) et nuire aux animaux.

puis

puis