Mistral ne désarme pas face à la célérité et l’effervescence des acteurs américains et chinois de l’IA. Son nouveau modèle open-source n’est pas bien grand mais il en fait beaucoup et vite…

Décidément très active, la startup française Mistral AI dévoile un nouveau modèle IA après les annonces récentes de Saba (son modèle dédié aux langues orientales) et de Mistral OCR (un modèle de digitalisation des documents qui révolutionne le marché de l’OCR). Baptisé Mistral Small 3.1, cette nouvelle variante de son très populaire modèle open source démontre une nouvelle fois que les petits modèles n’ont désormais pas grand-chose à envier aux grands modèles clouds.

Malgré sa taille modeste de seulement 24 milliards de paramètres, Mistral Small 3.1 surpasse sur certains tests les performances de modèles concurrents comme GPT-4o Mini d’OpenAI. De quoi replacer l’Europe en bonne position face aux petits modèles américains surdoués que sont Gemma 3 de Google, Granite 3.1 d’IBM ou encore Phi-4 de Microsoft.

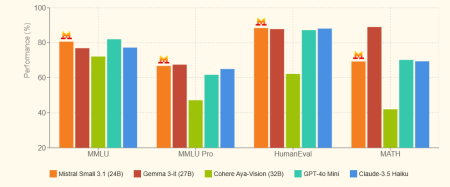

Mistral Small 3.1 se montre très efficace sur les benchmarks textuels :

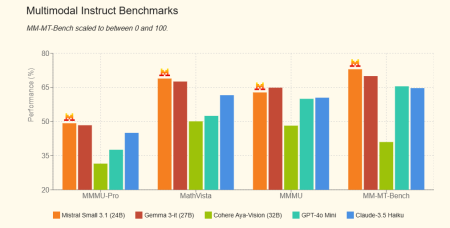

Mais c’est plus encore sur les benchmarks multimodaux imposant des analyses d’images et de graphiques qu’il se démarque :

Un modèle « State of the Art » mais bien compact

Dérivant des précédentes éditions de Mistral Small, cette version 3.1 combine plusieurs atouts majeurs dans sa poche pour un modèle de 24 milliards de paramètres :

– Il dispose de véritables capacités multimodales (analyse du texte et des images) grâce à des fonctionnalités « Vision » directement inspirées des travaux de Mistral notamment pour Mistral OCR ;

– Il est multilingue et prend en charge des dizaines de langues dont l’anglais, le français, l’allemand, le grec, l’hindi, l’indonésien, l’italien, le japonais, le coréen, le malais, le népalais, le polonais, le portugais, le roumain, le russe, le serbe, l’espagnol, le suédois, le turc, l’ukrainien, le vietnamien, l’arabe, le bengali, le chinois et le farsi ;

– Il présente de nombreuses améliorations dans son expression textuelle plus concise, précise, et fluide ;

– Il dispose d’une fenêtre de contexte étendue jusqu’à 128 000 tokens sans impact sur les performances ;

– Il se distingue une nouvelle fois par sa vitesse de traitement (l’une des grandes qualités des modèles de Mistral AI) qui en fait un outil idéal pour les cas d’usage nécessitant des temps de réponse ultra-courts et pour les assistants conversationnels.

Fait remarquable, déjà maintes fois évoqué pendant la hype DeepSeek, Mistral AI reste un exemple à suivre en matière d’optimisation algorithmique. Non seulement Mistral Small 3.1 est ultra rapide à l’inférence, mais il est si compact et performant qu’il peut fonctionner sur un seul GPU RTX 4090 ou même un Mac avec 32 Go de RAM ce qui le rend particulièrement adapté aux usages « on premises » et applications embarquées.

Une stratégie open source

Enfin, dernier atout et non des moindres, fidèle à son engagement d’origine, Mistral Small 3.1 est publié en open source sous licence Apache 2.0, même si le modèle répond davantage à la définition « open weight » qu’à la véritable définition OSI d’un modèle open source.

Reste que la stratégie open source de Mistral AI porte ses fruits. Ses modèles sont de plus en plus utilisés dans de multiples projets européens et sur Hugging Face, en fondation à de multiples solutions IA y compris pour des « modèles de raisonnement » comme DeepHermes 24B de Nous Research ou au cœur d’Agents IA autonomes. L’éditeur a d’ailleurs veillé à produire à la fois une version « base » et une version « instruct » de son modèle pour en faciliter la personnalisation par des tiers.

Mistral Small 3.1 rejoint une gamme désormais étendu de modèles d’IA :

– Saba : modèle axé sur la langue et la culture arabes, ce qui est assez unique

– Mistral OCR : API de reconnaissance optique de caractères aux capacités spectaculaires

– Mistral Large 2 : leur modèle LLM phare (et le seul modèle frontière européen)

– Pixtral Large : pour les applications multimodales

– Codestral : pour la génération de code

– « Les Ministraux » : une famille de modèles optimisés pour les appareils edge

Mistral Small 3.1 est disponible au téléchargement sur Huggingface et peut également être utilisé via l’API de Mistral AI ou sur la plateforme Vertex AI de Google Cloud. Dans les semaines à venir, il sera également disponible via les microservices NIM de Nvidia et l’Azure AI Foundry de Microsoft.

Et l’éditeur précise également que « pour les entreprises nécessitant des capacités spécialisées (contexte étendu, modalités spécifiques, connaissances propres à un domaine, etc.), nous lancerons prochainement des modèles commerciaux au-delà de ce que Mistral AI apporte à la communauté open source. »

puis

puis