Alors que le monde de l’IA américain s’extasie sur l’ingéniosité des Chinois de DeepSeek, Mistral AI se rappelle au bon souvenir de tous. La pépite française n’a pas attendu le réveil de la Chine en 2025 pour innover : depuis deux ans déjà, elle excelle dans l’art d’optimiser ses modèles d’IA. Architecture MoE, optimisations et autres ingénieuses astuces pour réduire les coûts et accroître les performances de l’IA sont dans son ADN. Un savoir-faire à nouveau démontré avec Small 3, un petit modèle très pertinent dans ses réponses (qui rivalise avec OpenAI o1-mini) mais surtout ultra rapide.

L’aventure DeepSeek parait bien moins spectaculaire et surprenante pour ceux qui connaissent la startup française et ses méthodes de travail. D’autant que Mistral a toujours, elle aussi, défendu des approches ouvertes de l’IA.

Histoire de se rappeler au bon souvenir de tous, Mistral profite de tapage médiatique de DeepSeek pour introduire sur le marché un nouveau petit modèle. Certes celui-ci n’est pas un pur modèle à raisonnement (même s’il n’est pas dénué de raisonnement). En revanche, c’est sans aucun doute l’un des modèles les plus véloces du marché !

Mistral Small 3 est un nouveau modèle de langage de 24 milliards de paramètres pensé pour offrir d’excellentes performances avec une latence minimale. Distribué sous licence Apache 2.0, il peut être déployé et modifié librement par les entreprises et la communauté.

Des résultats comparables à des modèles plus imposants

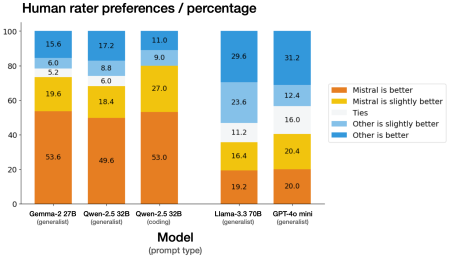

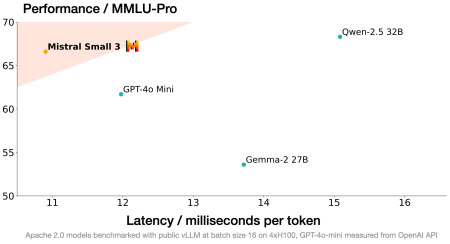

Grâce à une architecture optimisée et à un nombre de couches réduit, Mistral Small 3 rivalise avec des systèmes jusqu’à trois fois plus volumineux, tels que Llama 3.3 70B ou Qwen 32B.

Lors de tests internes, il s’avère aussi efficace que Llama 3.3 70B sur des tâches de raisonnement et de compréhension, tout en étant trois fois plus rapide sur le même matériel.

Avec un score de plus de 81 % sur le benchmark MMLU et un débit d’environ 150 tokens/s, ce modèle offre un excellent compromis entre taille et rapidité.

Un modèle adapté à de nombreux cas d’usage

Mistral Small 3 s’adresse à la majorité des cas d’utilisation de l’IA générative, qu’il s’agisse d’assistants conversationnels réactifs, de fonctions d’appel rapides dans des workflows automatisés ou de cas d’usage pointus via du fine-tuning (droit, médecine, support technique, etc.).

Ses faibles besoins en ressources, notamment une exécution possible sur une RTX 4090 ou un MacBook 32 Go, le rendent très intéressant pour des déploiements sur site — un atout pour les organisations soucieuses de confidentialité.

Et le modèle devrait rapidement s’imposer comme le choix de prédilection dans tous les cas d’usage de l’IA qui exigent une réponse ultra-rapide voire quasi temps réel.

Disponibilité et perspectives

Disponible à la fois en version pré-entraînée et en version « instruct » personnalisable, Mistral Small 3 est accessible sur « La Plateforme » (mistral-small-latest / mistral-small-2501) et via plusieurs partenaires (Hugging Face, Ollama, Kaggle, Together AI, Fireworks AI). Mistral AI compte poursuivre l’enrichissement de sa gamme de modèles, en visant des capacités de raisonnement accrues dans les prochaines versions.

Avec Mistral Small 3, l’éditeur confirme son engagement pour l’open source en maintenant une licence permissive, tout en cherchant à démocratiser davantage l’accès à l’IA avancée. Dans un style différent de DeepSeek-R1, ce modèle constitue tout autant une base solide pour la recherche, l’innovation et l’adoption à grande échelle de solutions d’IA locales, frugales et personnalisées. Plus que jamais, Mistral AI incarne l’espoir d’une IA européenne à même de concurrencer l’ingéniosité chinoise et la puissance de frappe américaine.

À lire également :

Mutimodalité, Canvas, analyse de documents, agents IA… Mistral Le Chat refait son retard

DeepSeek R1, le modèle IA open-source Chinois qui déchaine les passions [MAJ]

Microsoft et OpenAI se demandent si DeepSeek n’a pas pompé leurs IA

Mistral AI s’allie à l’AFP, Google s’allie à AP

Mistral AI lance son premier modèle multimodal et des services gratuits pour séduire les développeurs

Mistral lance la seconde génération de son grand LLM : Mistral Large 2

puis

puis