Les SLM, ou petits modèles de langage, spécialisés dans une langue ou un domaine et entraînés avec des jeux de données hautement qualitatifs se révèlent souvent plus pertinents que les LLM dès lors que leur usage est limité à leur expertise. Après ses très prometteurs Phi-2, Microsoft lance déjà ses modèles Phi-3 assez compacts pour s’exécuter en local sur smartphones.

L’année 2024 est marquée par deux tendances fortes en matière d’IA générative. D’une part la poursuite de la R&D et du développement autour des très grands modèles comme les LLM à plusieurs centaines de milliards voire milliers de milliards de paramètres comme l’ont démontré les récentes sorties de Gemini Pro 1.5, de Claude 3, de Mistral AI Large et Mixtral 8x22B ou encore de Llama 3.

D’autre part les efforts de recherche et développement autour de modèles plus petits mais plus spécialisés et tout aussi agiles tant que les questions se limitent à leur domaine de compétence. On l’a vu avec la sortie de Mistral Small, de Gemini Nano, de Claude 3 Haiku, des modèles open source Google Gemma ou encore des modèles de Microsoft Phi-2.

Car Microsoft ne se contente pas de se reposer sur ses partenariats avec OpenAI ou Mistral AI. L’éditeur développe aussi ses propres IA non seulement avec son entité Microsoft Research mais aussi avec sa nouvelle division « Microsoft AI » dirigée par l’ancien cofondateur de Deepmind et d’Inflection, Mustafa Suleyman.

En décembre dernier, Microsoft annonçait Phi-2, un modèle de langage de 2,7 milliards de paramètres qui démontrait des capacités exceptionnelles de raisonnement et de compréhension du langage et affichait des performances égalant ou surpassant des modèles jusqu’à 25 fois plus grands.

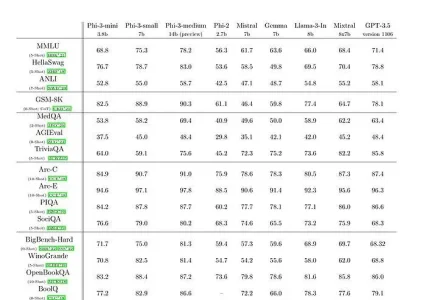

Cette semaine, Microsoft a dévoilé la nouvelle itération de ces modèles : Phi-3. Les modèles sont déclinés en trois versions : une version « Mini » (3,8 milliards de paramètres), une version « Small » de 7 milliards de paramètres et une version « Medium » de 14 milliards de paramètres.

La version Mini a été entraînée sur un corpus de 3 300 milliards de Tokens. Les versions Small et Medium sur un corpus de 4 800 milliards de Tokens.

Microsoft explique qu’en termes de capacités LLM, bien que le modèle Phi-3-mini atteigne un niveau de compréhension du langage et de capacité de raisonnement similaire à ceux de modèles beaucoup plus grands comme GPT 3.5, il demeure néanmoins fondamentalement limité par sa taille pour certaines tâches. Le modèle n’a tout simplement pas la capacité de stocker des connaissances factuelles étendues, ce qui se traduit, par exemple, par de faibles performances sur le benchmark TriviaQA. « Nous pensons toutefois que cette faiblesse peut être résolue par l’ajout d’un moteur de recherche » et les techniques RAG expliquent Microsoft.

L’intérêt d’un modèle compact comme Phi-3 Mini est de pouvoir être embarqué localement sur des dispositifs limités en puissance comme des smartphones ou des dispositifs IOT.

Microsoft n’a pas encore dévoilé officiellement les codes sources de Phi-3. Mais on rappellera que les versions précédentes (Phi-1, Phi-1.5 et Phi-2) ont été publiées en open source, sous la très permissive licence MIT, et rendues disponibles sous Github. Tout porte à croire qu’il en sera de même pour Phi-3.

Pour en savoir plus : [2404.14219] Phi-3 Technical Report: A Highly Capable Language Model Locally on Your Phone (arxiv.org)

À lire également :

LightOn lance une API pour sa plateforme IA « Paradigm »

Avec LLama 3, Meta redéfinit les standards de l’IA en open source

Next’24 : Gemini Pro 1.5 devient accessible aux développeurs

Anthropic lance Claude 3 : meilleur que GPT-4 et Mistral AI ?

Les modèles IA open source passent à la vitesse supérieure

puis

puis