Les grands modèles LLM propriétaires d’OpenAI, Google et Anthropic voient surgir un sérieux concurrent open source. Meta lance LLama 3 en open source et bouleverse l’univers des LLM. Mais son IA conversationnelle « Meta AI » reste inaccessible aux Européens.

FLAIR, le laboratoire de R&D de Meta est l’un des grands pionniers et explorateurs des IA génératives. Si certaines innovations sont destinées exclusivement à des fins expérimentales ou aux services du groupe (Facebook, Instagram, WhatsApp, Threads…) d’autres sont à l’inverse publiées en open source. Parmi elles, deux sont d’ailleurs devenus des composantes incontournables de l’écosystème IA : le framework PyTorch et le LLM LLama 2.

PyTorch est le framework ML le plus universellement répandu et sur lequel s’appuient des acteurs comme NVidia, Intel, AMD, OpenAI, Tesla, Midjourney, Uber, etc.

Quant à LLama 2, le LLM s’est imposé depuis 10 mois comme le LLM de référence qui sert de comparaison sur tous les benchmarks du marché. Disponible en open source et implémenté chez tous les acteurs clouds (Google VectrexAI, AWS BedRock, Azure ML, Hugging Face, IBM watsonx…), Llama 2 doit non seulement son succès à ses excellentes performances mais aussi à la multitude d’outils disponibles pour l’optimiser, le personnaliser et le « fine-tuner ».

Meta a annoncé en fin de semaine dernière son successeur : LLama 3. Promis à un avenir aussi glorieux que son prédécesseur, LLama 3 promet une qualité de résultats similaires à Claude 3 et Google Gemini Pro 1.5, des capacités multimodales, et des hallucinations moins fréquentes.

Pour l’instant, deux variantes du modèle ont été dévoilées : LLama 3 8B (8 milliards de paramètres) et LLama 3 70B. « Grâce à une évolutivité et à des performances accrues, Llama 3 peut gérer sans effort des tâches à plusieurs étapes. Par ailleurs, des processus de post-formation affinés réduisent considérablement les taux de faux refus, améliorent l’alignement des réponses et augmentent la diversité des réponses du modèle. En outre, LLama 3 améliore considérablement les capacités telles que le raisonnement, la génération de code et le suivi des instructions » explique Meta.

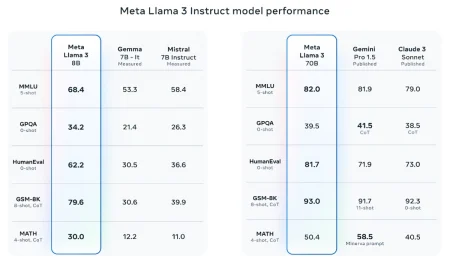

Pour l’éditeur, Meta définit de nouveaux standards d’efficacité et de qualité dans l’univers des LLM, qu’ils soient open source ou non. Ainsi, Lama 3 8B fait mieux que les modèles de Mistral AI ou de Gemma dans le domaine des LLM compacts. Quant à LLama 3 70B, il surpasse Gemini Pro 1.5, Mixtral 8x22B et Claude 3 Sonnet sur bien des Benchmarks tout en se révélant beaucoup plus compact que ces derniers.

Et ce n’est pas fini. Meta travaille sur d’autres déclinaisons de LLama 3 dont une version « 400B » qui devrait échanger dans plus de 30 langues et présenter des fonctionnalités multimodales avancées, de quoi disposer prochainement d’un modèle open source capable de rivaliser avec GPT-4 Turbo Vision et Gemini Ultra.

LLama 3 anime d’ores et déjà l’assistant « Meta AI », une IA conversationnelle à l’image de Google Gemini, ChatGPT, Microsoft Copilot ou Mistral Le Chat. Malheureusement, cet assistant pour l’instant limité aux interactions en anglais n’est pas accessible depuis les pays de l’Union européenne. Une restriction qui devient des plus classiques puisque Gemini Advanced et Claude AI sont eux aussi interdits aux internautes européens, ces IA n’étant pas pour l’instant compatibles avec les règlementations RGPD et DMA de l’Europe.

Les entreprises qui veulent expérimenter LLama 3 peuvent le faire dès aujourd’hui sur leurs infrastructures en récupérant les codes sources d’inférence et les modèles depuis le site de Meta ou depuis le GitHub de Meta Llama 3.

Pour ceux qui ne veulent pas se prendre la tête avec l’implémentation d’un tel modèle sur leurs serveurs, LLama 3 sera disponible dans les prochains jours sur les clouds de Google (Vertex AI), d’AWS (Bedrock API), d’Azure (ML Studio), mais aussi sur les plateformes de Hugging Face, d’IBM (WatsonX), de NVidia (NIM), de Databricks et de Snowflake.

À lire également :

Meta déploie deux clusters de 24 000 GPU et ambitionne les 350.000 GPU fin 2024

Meta avance un peu plus vers l’AMI avec son modèle V-JEPA

Next’24 : Gemini Pro 1.5 devient accessible aux développeurs

Le Cigref démystifie les métavers et les chemins concrets pour les apprivoiser

puis

puis