La startup française Mistral AI lance son propre concurrent de ChatGPT autrement dit son IA conversationnelle « Le Chat » basée sur ses modèles qui ont déjà fait couler beaucoup d’encre.

Les internautes vont enfin pouvoir mieux comprendre comment une startup sortie du néant (mais portée par des personnalités connues du monde de l’IA et de la French Tech) a pu devenir une licorne en moins d’un an d’existence.

La jeune pousse française avait officiellement ouvert l’accès à ses modèles via des API au travers de son offre d’hébergement « La Plateforme » en décembre dernier.

Cette semaine, elle a fait un pas de plus dans la concurrence aux leaders américains que sont ChatGPT d’OpenAI, Gemini de Google ou Claude d’Anthropic. Elle lance son propre service de conversations avec ses modèles génératifs : Mistral Le Chat.

Pour l’instant, « Le Chat » reste relativement basique. L’interface permet de converser avec l’IA et d’accéder à un historique des conversations. Pas d’accès à Internet pour un savoir « à jour », pas de plugins, pas d’envoi de fichiers pour analyse, pas d’interactions évoluées. Mais l’intérêt est ailleurs. « Le Chat est une application qui permet d’interagir avec les différents modèles de Mistral AI. Nous l’avons conçu comme une application pédagogique et ludique permettant d’évaluer notre technologie » explique l’éditeur.

Trois nouveaux modèles « Commerciaux »

Le Chat permet de converser avec des modèles génératifs construits par des Européens avec un esprit un peu plus européen et de découvrir les qualités des modèles de Mistral AI à commencer par les deux premières : une belle maîtrise du français et une tendance naturelle à la concision.

Parallèlement à son interface conversationnelle, Mistral AI en profite pour dévoiler trois nouveaux modèles directement accessibles depuis Le Chat (mais aussi via les API de La Plateforme) :

Mistral Next, révélé la semaine dernière au travers du service expérimental LMSYS, est également accessible. Mistral n’en dévoile pour l’instant pas de détails mais il n’est apparemment pas aussi « capable » que Mistral Large et reste probablement un modèle compact destiné à remplacer Mistral 7B à terme. Ce n’est pour l’instant qu’un prototype qui se veut « bref et concis ».

Enfin, Mistral Small (version commerciale du modèle open source Mistral 7B) offre « une bonne capacité de raisonnement pour une latence très faible ». Dans la pratique, les utilisateurs discuteront donc de préférence avec le modèle « Mistral Large » mais « Le Chat » permet aisément de tester « Small » et de comparer la pertinence de ses réponses avec « Large » ce qui peut éclairer les entreprises et les développeurs avant d’opter pour l’intégration de « Small » dans leurs propres applications au travers de « La Plateforme ».

Une version Entreprise en approche

Reste que « Le Chat » souffre des mêmes mauvaises pratiques que ses concurrents américains : le modèle ne garantit pas la confidentialité des échanges et les échanges historisés avec l’IA pourront servir à l’entraînement des futurs modèles.

Pour les entreprises et les professionnels en quête de plus de confidentialité, Mistral décline (ou plutôt déclinera très prochainement) son IA en deux autres versions.

La version « payante » de son IA conversationnelle ajoutera aux capacités de la version gratuite un « mode incognito » qui interdit toute historisation des échanges et surtout une fonctionnalité « Opt-Out » qui doit être manuellement activée pour que vos échanges ne soient pas exploités dans de futurs apprentissages.

La version « Le Chat Entreprise » est présentée par l’éditeur comme « une solution conçue pour renforcer la productivité de votre équipe, qui peut se déployer sur une infrastructure dédiée, et propose un système de modération fortement configurable. N’hésitez pas à contacter notre équipe pour en savoir plus! ».

Pour l’instant « Le Chat » n’est encore qu’en Bêta et les fonctionnalités de confidentialité payantes ne sont pas disponibles.

Des modèles Mistral sur Azure et AWS

Officiellement, le modèle « Large » est également disponible sur Microsoft Azure, premier partenaire de distribution officiel de Mistral AI. L’éditeur américain – qui reste le principal partenaire commercial d’OpenAI – ne veut pas mettre tous ses œufs dans un même panier et semble avoir fait le forcing pour attacher son nom et son service en premier à la nouvelle étoile européenne de l’IA. « Nous annonçons aujourd’hui un partenariat pluriannuel entre Microsoft et Mistral AI, leader reconnu de l’intelligence artificielle générative. Nos deux entreprises partagent une ambition permanente pour l’innovation et ses applications pratiques, réduisant ainsi l’écart entre la recherche de pointe et le développement de solutions concrètes » affirme Microsoft dans un communiqué. Ce partenariat permet à Mistral AI de profiter de l’infrastructure IA d’Azure pour accélérer le développement et le déploiement de sa prochaine génération de grands modèles de langage (LLM), tout en lui ouvrant de nouvelles opportunités commerciales et de développement à l’international. Pour la jeune pousse française, pouvoir exploiter les HPC d’Azure pour entraîner ses grands modèles est sans aucun doute un atout important.

Par ailleurs, Mistral Large et Mistral Small vont ainsi être disponibles dans le catalogue de modèles d’Azure AI Studio et d’Azure ML alors qu’Azure connaît une adoption accélérée auprès des entreprises depuis l’explosion de l’IA générative.

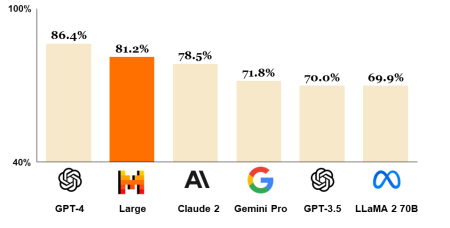

Il est d’ailleurs assez intéressant de voir les qualités mises en avant par Microsoft sur le modèle « Large » de son nouveau partenaire : « Large » est présenté comme un modèle « à la pointe de la technologie en matière de raisonnement et de connaissance » avec des performances « Best-in-Class » en Français, Allemand, Espagnol et Italien, un fonctionnement spécialisé dans le RAG (pour accrocher le LLM à des données d’entreprise), et des performances solides en génération de code informatique.

Il n’est pas non plus anodin que le premier partenaire commercial de Mistral AI soit un cloud américain plutôt qu’un cloud européen comme 3DS Outscale ou OVHcloud.

Bien évidemment, ce partenariat officiel avec Azure fait grincer les dents de la concurrence tant la startup française attire tous les projecteurs à elle. Et notamment du côté d’AWS. Le cloud d’Amazon s’est empressé de publier un communiqué pour annoncer que « Mistral 7B » et « Mistral 8x7B » seraient prochainement disponibles sur Amazon Bedrock. « Ces modèles possèdent une compréhension exceptionnelle du langage naturel et des tâches relatives au code, les rendant très utiles pour les projets qui nécessitent de naviguer entre ces deux besoins » précise AWS. Toutefois, les modèles ainsi rendus accessibles sur AWS sont bien les versions « open source » de Mistral AI et non les versions « commerciales » (disponibles sur La Plateforme de Mistral AI et sur Azure) qui semblent plus évoluées et intègres des filtres et règles éthiques avancés qui ne sont pas dans la version open source.

Au final, on ne peut que se réjouir de voir enfin une entreprise européenne proposer une alternative à la hauteur des IA américaines. Mistral AI a le vent en poupe et nul doute que les entreprises européennes auront hâte d’explorer le potentiel de ses nouveaux modèles. En attendant de les voir également héberger sur des infrastructures certifiées SecNumCloud.

puis

puis