L’avenir de l’intelligence artificielle pourrait bien se jouer à la vitesse de la lumière. Deux avancées récentes, l’une signée IBM et l’autre issue du MIT, montrent que le futur de l’informatique pourrait désormais reposer sur la photonique. Exit l’électron, bonjour le photon…

L’informatique doit tout à l’invention de la diode (en 1904) et du transistor (en 1947) qui ont permis la concrétisation de circuits électroniques puis de circuits intégrés et de processeurs basé sur le traitement de signaux électriques et donc du déplacement d’électrons ! D’où d’ailleurs le nom « Electron… ique ».

Sacré photon !

Et si, au lieu des électrons, on transportait l’information au travers de photons (et donc de signaux de lumière) ? L’idée d’utiliser la lumière pour le traitement de l’information remonte à plusieurs décennies. Dès les années 1960 et 1970, des chercheurs ont exploré le potentiel des signaux optiques pour le traitement de l’information, développant des dispositifs tels que des commutateurs optiques et des modulateurs électro-optiques. Ces premières avancées ont jeté les bases des futurs processeurs photoniques exploitant les photons en lieu et place des électrons.

Les photons, particules élémentaires de la lumière, offrent des avantages significatifs par rapport aux électrons dans le domaine informatique. Se déplaçant à la vitesse de la lumière, les photons permettent une transmission de données ultra-rapide. De plus, leur nature électriquement neutre élimine les interférences électromagnétiques, autorisant une densité accrue des circuits sans risque de perturbations mutuelles. Et, contrairement aux électrons, les photons ne génèrent pas de chaleur lors de leur déplacement, ce qui réduit la consommation énergétique et les besoins en refroidissement des systèmes informatiques.

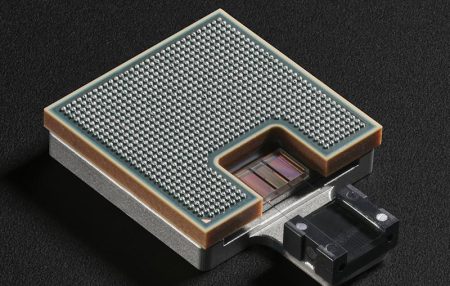

Intel est un des grands visionnaires et précurseurs de l’informatique photonique. L’entreprise travaille sur le sujet depuis des décennies et à réaliser plusieurs progrès pour petit à petit exploiter un peu plus les photons au cœur des infrastructures réseaux et informatiques. Intel a dévoilé en juin de cette année le premier connecteur optique photonique intégré, ou Optical Coherent Interface (OCI). Ce composant innovant utilise des signaux lumineux pour la transmission de données, atteignant des vitesses de connexion de 32 Gbps sur 64 canaux, soit une transmission bidirectionnelle de 4 térabits par seconde. Cette technologie surpasse les interconnexions électriques traditionnelles en offrant une bande passante supérieure, une latence réduite et une meilleure efficacité énergétique, avec une consommation de seulement 5 picojoules par bit. Intel a également présenté des lasers à boîte quantique sur des plaquettes de silicium de 300 mm permettant d’intégrer aisément les lasers dans les ordinateurs. Et, la R&D d’Intel a également développé un transmetteur photonique entièrement intégré, combinant un laser à rétroaction distribuée et un modulateur Mach-Zehnder assisté par anneau. Ce dispositif a démontré une transmission de 224 Gb/s en modulation PAM-4 sur une fibre optique d’un kilomètre, avec une pénalité de transmission de seulement 1,25 dB.

Mais Intel n’est pas le seul acteur à s’intéresser à l’informatique photonique. Cette semaine, deux annonces, une d’IBM, l’autre du MIT, montre que la R&D dans ce domaine progresse.

IBM éclaire la bande passante des datacenters

La robustesse de cette technologie a été éprouvée dans des conditions extrêmes (-40° C et 125° C), démontrant sa maturité en vue d’une industrialisation à grande échelle.

Le MIT dope l’IA au photon

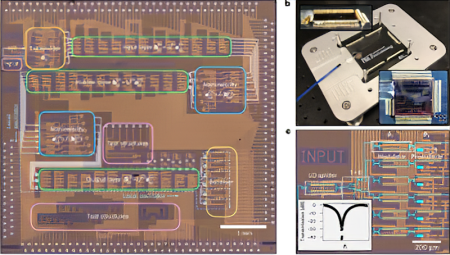

L’architecture du processeur s’articule autour de trois couches complémentaires. La première encode les paramètres du réseau neuronal en signaux lumineux. La deuxième, composée de diviseurs de faisceau programmables, effectue les multiplications matricielles. La troisième intègre les NOFUs pour les opérations non linéaires, convertissant une infime partie du signal lumineux en courant électrique via des photodiodes, le tout avec une consommation énergétique minimale.

Cette architecture hybride, mariant optique et électronique, obtient plus de 96% de précision et s’appuie sur des procédés CMOS standards, favorisant ainsi une adoption industrielle à grande échelle. Car les applications potentielles sont vastes : du traitement LIDAR à la recherche en astronomie, en passant par les télécommunications haute vitesse.

Ensemble, ces deux avancées dessinent une informatique de nouvelle génération, une informatique photonique à la fois plus rapide, plus économe en énergie, et directement compatible avec les méthodes de fabrication actuelles. Alors que la demande en puissance de calcul s’accroît de manière exponentielle dans le sillage de l’IA générative, la photonique pourrait bien être une piste à suivre dans un avenir proche et cette solution de rupture tant recherchée par les hyperscalers et les datacenters de l’IA. De quoi finir l’année 2024 avec de nouvelles lueurs d’espoir pour les années à venir…

Pour en savoir plus :

Intel Unveils First Integrated Optical I/O Chiplet

Intel Presents Latest Integrated Photonics Developments at 2024 Optical Fiber Conference – Intel Community

IBM Brings the Speed of Light to the Generative AI Era with Optics Breakthrough

Single-chip photonic deep neural network with forward-only training | Nature Photonics

puis

puis