Google reste dans la course à l’informatique quantique. Ses équipes de R&D viennent de dévoiler Willow, un processeur de 105 qubits et le premier processeur quantique officiel de Google depuis le célèbre Sycamore de 2019 !

Il faut toujours prendre d’énormes pincettes lorsque l’on parle d’innovations quantiques en s’appuyant sur les communiqués américains. Leur tendance à l’exagération et à l’emphase semble d’autant plus grande que les américains ont bien conscience de ne pas avoir l’avance démesurée qu’ils annoncent sur les startups européennes et notamment françaises.

Et en la matière, Google nous a déjà fait le coup notamment en revendiquant avant tout le monde avoir atteint la suprématie quantique… avec un algorithme sans grande application pratique.

Cette précaution dite, Google (en réalité très en retard sur sa roadmap d’il y a 10 ans) semble avoir franchi quelques pas importants si ce n’est pour tout l’écosystème quantique au moins pour son propre écosystème.

Google Research annonce cette semaine Willow, sa nouvelle puce quantique, qui espère (et prétend) marquer un tournant significatif voir décisif dans la quête à une informatique quantique pratique, utile, déployée à grande échelle.

Willow est une puce quantique de 105 qubits qui succède officiellement au célèbre Sycamore, processeur quantique à supraconducteurs « transmon » de 53 qubits introduit en 2019. Selon Google, Willow incarne plus d’une décennie d’innovation et d’optimisations dans la conception, la fabrication et le calibrage de dispositifs quantiques.

Une réduction « exponentielle » des erreurs

La puce Willow révolutionne deux aspects fondamentaux de l’informatique quantique.

D’une part, elle parvient à réduire exponentiellement les erreurs au fur et à mesure de l’augmentation du nombre de qubits — un défi majeur identifié dès 1995 par Peter Shor, et auquel la communauté scientifique s’attaque depuis près de 30 ans. Cette avancée, qualifiée de « below threshold », signifie que l’ajout de qubits supplémentaires permet non seulement d’augmenter la capacité de calcul, mais aussi d’améliorer la fiabilité du système. Les expériences menées par Google ont montré qu’en passant d’une grille de 3×3 qubits physiques corrigés, à des grilles de 5×5, puis de 7×7, le taux d’erreur était systématiquement réduit de moitié à chaque nouvelle itération (même constat chez Microsoft Research d’ailleurs qui pratique la combinaison de qubits physiques pour créer des qubits logiques fiables depuis quelques années).

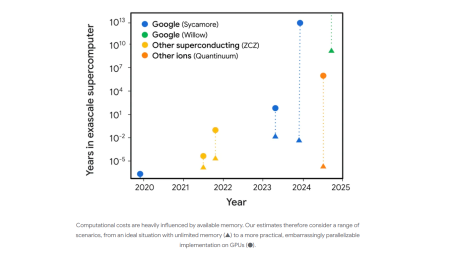

D’autre part, sur le plan des performances globales, Willow établit un nouveau standard sur le RCS (Random Circuit Sampling), un test de performance devenu une référence dans le domaine quantique. Selon Google, Willow a réalisé un calcul spécifique en moins de 5 minutes — un calcul qui demanderait à l’actuel supercalculateur Frontier, un des plus puissants au monde, plus de 10^25 années (10 septillions) pour être accompli. Il s’agit d’une accélération exponentielle, surpassant largement la démonstration antérieure de Google il y a cinq ans, lorsque l’entreprise avait déclaré pouvoir résoudre en quelques minutes un problème prenant 10 000 ans sur une machine classique (ce qu’IBM avait rapidement dénoncé comme faux, estimant que son supercalculateur de l’époque réalisait en réalité le calcul en 5 jours).

Et Google d’essayer de nous faire avaler par le graphique ci-dessous que les ordinateurs quantiques ont désormais atteint l’ère exascale en oubliant de rappeler que l’ordinateur quantique n’a pas vocation à remplacer les HPC classiques mais à concrétiser des algorithmes différents et inadaptés à l’informatique binaire.

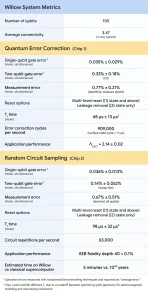

* Un nombre de qubits restreint à la centaine (105) contre 1121 sur le Condor d’IBM;

* La connectivité moyenne reste inférieure à 4 voies de connexion (IonQ et Quantinuum ont des connectivités all-to-all);

* Les erreurs sur une porte à deux qubits tournent aux alentours de 0,33% (IonQ annonce du 0,1% sur ces dernières puces);

* La réinitialisation multi-niveau (L1, L2) pour éliminer la fuite de l’état quantique (et qui constitue l’un des goulots d’étranglement typiques des infrastructures quantiques est) est (à peine) inférieure à 1;

* Le temps de cohérence est encore exprimé en « microseconde » et non en « milliseconde » (comme sur les ions piégés d’IonQ et les atomes neutres de Pasqal) voire en « seconde » (avec les ions piégés de Quantinuum).

Le chiffre le plus surprenant est en réalité le « Cycle de correction d’erreur » annoncé à 909 000 cycles par seconde (cycle = 1,1 µs). Pouvoir exécuter près d’un million de cycles de correction d’erreur par seconde suggère un système très rapide dans le cadre de la mise en œuvre de codes de correction d’erreurs.

On saluera au passage l’effort de transparence de Google qui fournit, une fois n’est pas coutume dans l’univers des puces quantiques, des métriques nombreuses et précises.

Fabrication, Conception et Infrastructure

L’information la plus intéressante est en réalité que Google persiste et signe sur les approches de qubits à supraconducteurs (alors même que Google est aussi l’un des principaux investisseurs de QuEra avec ses Qubits à atomes neutres concurrents de ceux de Pasqal).

Bien que la concurrence fasse rage entre diverses approches technologiques (qubits supraconducteurs, atomes neutres, ions piégés, etc.), Google estime que les qubits supraconducteurs, fabriqués avec des outils similaires à la microélectronique traditionnelle, offrent actuellement la meilleure voie vers un ordinateur quantique tolérant aux erreurs et extensible. Un discours que l’on entend également chez IonQ, Pasqal, Alice&Bob, Microsoft, Quandella et autres utilisant des qubits de technologies radicalement différentes.

Vers des Applications Pratiques et Stratégiques

Pour tous les acteurs de l’informatique quantique, l’enjeu est désormais de réaliser un calcul « utile et au-delà du classique », c’est-à-dire de développer une application concrète que les ordinateurs classiques, même les plus puissants, seraient incapables de résoudre dans un délai raisonnable. Google espère atteindre cet objectif dès l’année prochaine. IBM est à peu près aligné sur le même objectif.

Et l’une des pistes explorées est bien évidemment l’intelligence artificielle (IA). Non sans raison. Comme l’explique Hartmut Neven, directeur Quantum AI chez Google, « on me demandent parfois pourquoi j’ai quitté le domaine florissant de l’IA pour me concentrer sur l’informatique quantique. Ma réponse est que ces deux technologies s’avéreront être les plus transformatrices de notre époque, mais l’IA avancée bénéficiera considérablement de l’accès à l’informatique quantique… Les algorithmes quantiques ont des lois fondamentales d’échelle… essentielles à l’IA. Ainsi, le calcul quantique sera indispensable pour collecter des données d’entraînement inaccessibles aux machines classiques, entraîner et optimiser certaines architectures d’apprentissage, et modéliser des systèmes où les effets quantiques sont importants ».

Ces synergies entre IA et quantique pourraient transformer des secteurs clés : découverte de médicaments, optimisation des batteries pour véhicules électriques, modélisation des réactions pour la fusion nucléaire, etc.

Avec cette annonce, Google montre qu’il est toujours en lice dans la course à l’informatique quantique et que sa R&D reste très active. L’éditeur en a profité pour mettre à jour sa roadmap, Willow représentant son « Milestone 2 ». On notera que ses chercheurs ont pris soin, cette fois, de ne pas apposer de dates à ses objectifs…

puis

puis