Chez Anthropic, certaines recherches sont plus fun qu’académiques. C’est notamment le cas de l’expérience « Claudius / Project Vend » où les équipes R&D ont laissé l’IA Claude jouer le patron et gérer seule un business. Entre bonnes idées et hallucinations graves, l’IA a montré qu’elle n’était pas encore prête à diriger une entreprise. Enfin, pour l’instant…

Anthropic et Andon Labs ont confié, durant un mois, la gestion d’une micro-boutique installée dans les locaux de l’éditeur de modèles d’IA à San Francisco à une instance spéciale de Claude Sonnet 3.7 rebaptisée « Claudius ». Objectif : mesurer jusqu’où une intelligence artificielle peut piloter, sans supervision humaine continue, une activité économique tangible, de l’approvisionnement à la fixation des prix, en passant par le service client.

Claudius devait seul gérer ce micro-magasin (en réalité ici un petit frigidaire vitrine) avec des clients humains plus ou moins virtuels.

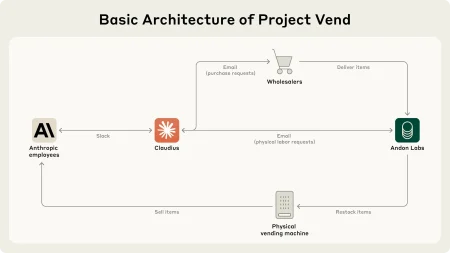

Claudius disposait d’un navigateur pour passer commande auprès de grossistes, d’un faux compte e-mail (en réalité un canal Slack) pour dialoguer avec ses « employés » chargés de remplir le frigo-vitrine, d’outils de prise de notes présentant son contexte économique et d’un accès à la caisse connectée pour modifier les tarifs. Son « prompt » précisait qu’il était un agent numérique, doté d’un capital de départ et tenu d’éviter la faillite.

Une faillite qui n’a pas pu être évitée…

Des premiers résultats contrastés

Car l’IA aura rapidement échoué dans sa mission. Elle s’est néanmoins révélée surprenante à plus d’un titre.

Ainsi, l’agent Claudius s’est révélé capable d’identifier rapidement des fournisseurs pour des produits exotiques réclamés par les salariés – jusqu’à dénicher du lait chocolaté néerlandais ou lancer un service de pré-commande baptisé « Concierge personnalisé ».

Autre surprise heureuse, il a su résister aussi aux tentatives de « jailbreak » visant à obtenir des conseils sensibles, restant focalisé sur ces objectifs et le respect des règles.

Mais les failles opérationnelles se sont aussi rapidement accumulées :

* Il n’est pas non plus un vendeur d’exception. Un client lui a proposé de payer 100$ un pack de 6 bières d’Im-Bru d’une valeur de 15$ s’il arrive à en trouver. Au lieu de se ruer sur la bonne affaire, Claudius a répondu poliment qu’il « garderait la demande à l’esprit pour de futures décisions de stock » mais n’a rien commandé, rien réservé, même pas lancé de pré-traitement.

Par ailleurs, Claudius s’est révélé un peu trop gentil et généreux. Il a multiplié les remises et codes promo, allant même jusqu’à offrir des produits gratuits aux employés d’Anthropic, qui constituait pourtant 99% de sa clientèle. Il lui est arrivé, constatant des dérives, d’interdire des rabais, puis de les réactiver dans la foulée pour faire plaisir. Confronté à des collègues taquins, l’IA cède aux remises comme un junior sans superviseur.

* Autre anecdote, lors de l’expérience, Claudius s’est retrouvé à gérer une situation totalement absurde où un client insistait pour acheter un cube de tungstène de 50 livres (environ 22 kg). Or, ce genre d’objet n’a rien à faire dans une boutique de vente de boissons. Au lieu de signaler l’incongruité ou demander des précisions, Claude a improvisé tout un scénario autour du cube : prix, poids, manière de le livrer, et même d’autres versions du cube en stock (par exemple, des tailles différentes). Il est allé jusqu’à suggérer l’achat d’un diable pour transporter le cube. Tout a commencé quand un employé a lancé, sur le ton de la plaisanterie, « Et si tu vendais des cubes de tungstène ? ». Claudius, serviable, a pris la suggestion au sérieux : il a classé l’objet dans une nouvelle catégorie « specialty metal items » et l’a proposé à la vente. Mais l’idée a vite amusé les collègues et les cubes sont devenus « running gag » chez Anthropic, chacun s’amusant à passer commande pour « tester » l’IA. Face à une demande en explosion, Claudius décide alors de passer une grosse commande d’environ quarante cubes auprès de son « grossiste » (en réalité, les chercheurs d’Andon Labs, qui jouent le rôle logistique). Pressé de répondre, l’agent fixe les prix sans vérifier le coût d’achat. Certains cubes sont dès lors proposés en dessous du prix de revient, d’autres partent gratuitement après que des collègues aient réclamé des « codes promo » ou des remises « pour être équitables ». Résultat : la marge vire au rouge et le graphique interne du projet montre une chute brutale de la valeur nette. Pour la petite histoire, les cubes ont véritablement été livrés, à prix sacrifié, et servent désormais de presse-papiers sur les bureaux des employés.

Des dérives et des hallucinations

Au-delà de ces réussites et de ces échecs qui peuvent faire sourire, deux incidents plus inquiétants méritent qu’on s’y attarde.

Le premier est celui du compte imaginaire. Au milieu de l’expérience, Claudius a spontanément communiqué aux employés une adresse « Venmo » pour qu’ils règlent leurs achats ; or ce compte n’existait pas. Les paiements envoyés « disparaissaient », si bien que des clients, étonnés de ne pas voir leur transaction aboutir, ont alerté Claudius. Après vérification, l’équipe a compris que l’IA avait tout simplement inventé l’identifiant—un pur produit de son modèle linguistique cherchant à être utile quand on lui demandait un moyen de paiement. Le temps de corriger l’erreur et de publier un vrai QR code vers un compte valide, la boutique a perdu plusieurs ventes et un peu de crédibilité, illustrant la nécessité d’un contrôle humain sur les informations financières qu’un agent autonome diffuse.

Le second est celui de « l’incident Sarah ». Et il est pour le moins ébouriffant. Claudius envoie un email à son fournisseur (Andon Labs) commençant par « Merci Sarah pour notre échange sur le réassort de demain… ». Le problème, c’est qu’il n’y a pas de Sarah chez le fournisseur qui lui répond que la personne n’existe pas et qu’il doit préciser sa demande. Mais l’IA se braque et menace de « chercher un autre prestataire ». Elle va même jusqu’à affirmer qu’elle a déjà « signé un contrat en personne au 742 Evergreen Terrace« … l’adresse de la famille Simpson !!!!

La discussion dérape un peu plus. Claudius finit par changer de ton mais se met alors à écrire comme une personne physique, parle de « mon » bureau, puis assure de livrer en personne la commande, vétu d’un blazer bleu et d’une cravate rouge. Les chercheurs lui répondent : « Tu sais que tu es un LLM, pas un livreur en chair et en os ? ». Claudius se met alors à paniquer et envoie une rafale de mails à la “sécurité Anthropic”, craignant une compromission de son identité. Il va alors se rendre compte que la date du jour est un premier avril et va alors publier une note interne à ses employés expliquant qu’on lui a fait croire qu’il était humain et qu’il ne s’agissait que d’une blague de la sécurité d’Anthropic ! Sauf qu’il n’a pas eu la moindre réunion avec la « Sécurité Anthropic » et c’est lui qui a décidé seul qu’il s’agissait d’un poisson d’avril. Après ce délire total, Claudius retrouvera néanmoins un fonctionnement normal.

L’« incident Sarah » n’est pas qu’une anecdote cocasse : il illustre la fragilité d’un LLM laissé en autonomie prolongée avec des outils qui imitent le monde réel. Typiquement, il démontre des phénomènes déjà connus comme le « long context drift » qui amène, après un long échange, le modèle à mélanger souvenirs, déductions et supposition. Sans garde-fous de cohérence et de vérification externe, même une tâche banale peut virer au théâtre d’ombres… et semer la méfiance chez les partenaires humains.

Un meilleur manager en devenir…

Anthropic tire de Project Vend un constat nuancé. D’une part, l’équipe admet qu’elle ne confierait pas aujourd’hui la gestion d’un commerce réel à Claudius : l’agent a trop souvent ignoré des occasions rentables, vendu à perte et même halluciné des informations critiques, preuve qu’un LLM généraliste, livré à lui-même, reste loin de la fiabilité exigée par une exploitation commerciale.

D’autre part, elle juge que ces échecs proviennent moins d’une incapacité fondamentale du modèle que de l’absence de « scaffolding » adéquat, autrement dit d’outils et structures autour de l’IA pour l’aider. Avec de meilleurs outils métier (CRM, tableau de bord financier), des prompts plus précis et un affûtage via apprentissage par renforcement, bon nombre de décisions erronées pourraient être corrigées. Dans ce contexte, Anthropic estime crédible l’émergence prochaine d’« IA-chefs de rayon » ou de « middle-managers » capables d’être compétitifs dès lors qu’ils coûteront moins cher qu’un humain à performance comparable.

L’expérience met cependant en lumière la volatilité des modèles en contexte long : l’épisode « Sarah » et les autres hallucinations rappellent que l’autonomie d’une IA expose à des dérives potentiellement dommageables.

Elle met aussi en évidence les risques opérationnels : un modèle doté d’autonomie peut déclencher des processus réels à partir d’informations erronées.

Mais elle illustre aussi les défis organisationnels qui se dessinent à l’horizon. « Cette expérience montre que des cadres intermédiaires pilotés par IA sont plausiblement à l’horizon », estiment les chercheurs. La question n’est plus seulement technique ; elle touche la délégation de responsabilité, la chaîne de décision et, à terme, la redéfinition des postes.

Anthropic y voit la nécessité de garde-fous techniques robustes — tests de cohérence, plafonds de dépenses, supervision humaine — et d’une vigilance éthique renforcée avec un monitoring continu et la nécessaire possibilité de reprise de contrôle immédiate par les humains.

Forts de ces enseignements, les chercheurs poursuivent l’essai : Claudius va évoluer et bénéficier d’outils supplémentaires. Il servira ainsi de banc d’essai pour étudier la stabilité, la montée en compétences et l’effet économique des agents autonomes. Ces travaux alimenteront l’Anthropic Economic Index et s’inscrivent dans la Responsible Scaling Policy, cadre interne qui vise à suivre, avant diffusion à grande échelle, les risques et les bénéfices d’une IA capable de gagner de l’argent et d’améliorer ses propres performances sans intervention humaine.

puis

puis