DeepSeek frappe fort avec Janus-Pro, un modèle génératif d’images qui combine puissance, compacité et licence open source. En défiant DALL-E 3 sur les benchmarks et les coûts, la startup chinoise redessine une nouvelle fois les règles du jeu de l’IA générative, cette fois sur la génération et l’analyse d’images.

Depuis une semaine, DeepSeek bouleverse l’écosystème de l’IA et plus particulièrement la sphère américaine avec DeepSeek R1, un modèle à raisonnement publié en open-source qui se défie OpenAI o1 en termes de pertinence pour des coûts d’inférence (via Hugging Face ou via DeepSeek AI) très inférieurs à ceux d’OpenAI.

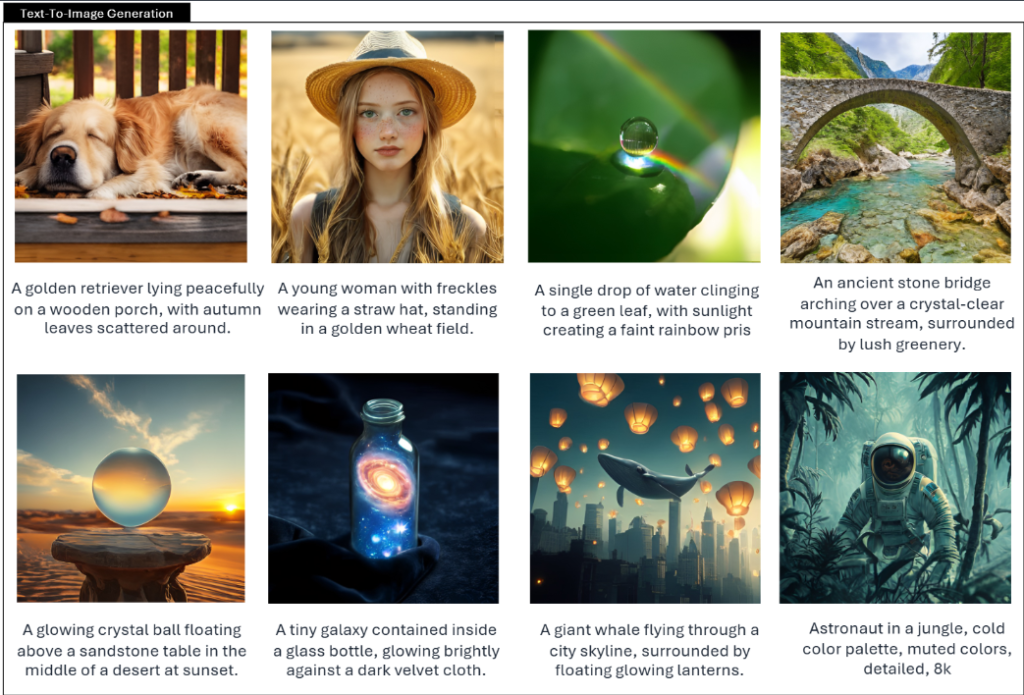

Et DeepSeek ne lâche pas la pression sur OpenAI en s’attaquant cette fois à un autre modèle phare de la startup américaine, son IA de génération d’images Dall-E 3. La startup chinoise vient de dévoiler Janus-Pro, une nouvelle famille de modèles multimodaux conçus à la fois pour la génération et l’analyse d’images. Ces modèles, disponibles en versions allant de 1 à 7 milliards de paramètres, se révèlent apparemment supérieurs à DALL-E 3 d’OpenAI ou encore Stable Diffusion de Stability AI dans plusieurs benchmarks.

Des performances remarquables malgré une taille compacte

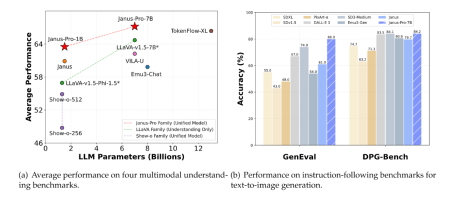

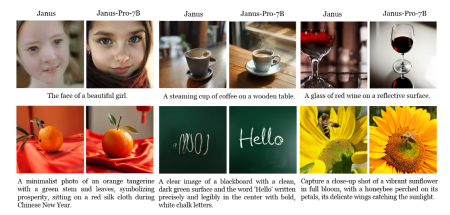

Selon DeepSeek, Janus-Pro-7B, la version la plus importante de cette gamme, surpasse DALL-E 3 et plusieurs autres modèles de référence dans des évaluations comme GenEval et DPG-Bench.

Ce qui étonne n’est pas tant la qualité des rendus (on sait les IA très capables) mais plutôt la grande compacité du modèle qui lui permet une exécution en local à moindre coûts.

Une efficacité qui proviendrait d’une approche « autoregressive » novatrice et une séparation du traitement visuel dans un circuit dédié permettant d’obtenir des images plus stables et plus détaillées.

DeepSeek précise que l’apprentissage des nouvelles variantes de Janus-Pro a bénéficié de méthodes de formation « compute-efficient », avec un recours modéré en ressources GPU. Cette stratégie aurait permis de développer les modèles en quelques semaines, sans recourir à des infrastructures massives et coûteuses.

Bien sûr rien n’est parfait. Et DeepSeek reconnaît que ses nouveaux modèles sont perfectibles : l’analyse d’images en hautes définitions ou les tâches de reconnaissance fine (comme l’OCR) restent limitées par la configuration actuelle.

Un modèle ouvert sous licence MIT

L’autre avantage clé de Janus-Pro s’est bien évidemment d’être publié en open source sous la très permissive licence MIT. Et à première vue, ce modèle semble répondre en grande partie à la définition OSI d’un modèle open source y compris au niveau des jeux de données de formation (même si officiellement Janus-Pro n’est pas officiellement reconnu comme tel). DeepSeek explique avoir enrichi son jeu de données avec des millions d’images synthétiques de haute qualité, en complément de données réelles, afin d’améliorer la stabilité et la richesse des détails visuels.

Pour les entreprises, c’est encore un nouveau modèle IA qui vient enrichir un arsenal open source de plus en plus riche et pertinent. De quoi donner un peu plus de poids aux infrastructures IA locales (souvent basées sur NVidia Enterprise AI et NVidia NIM) au détriment de solutions clouds dont les modèles vedettes propriétaires semblent désormais évoluer moins vite et se font rattraper par les petits modèles open source.

La sortie de Janus-Pro intervient peu de temps après le lancement non seulement de DeepSeek R1 mais aussi de la plateforme conversationnelle DeepSeek AI, devenue rapidement l’une des applications gratuites les plus téléchargées sur l’App Store (et qui semble ne plus accepter de nouveaux utilisateurs tant les infrastructures sont saturées par le succès). De quoi venir encore un peu plus alimenter les vives discussions internationales autour de la place de la Chine dans la course mondiale à l’IA, et sur la faisabilité de développer des modèles compétitifs sans dépendre de centres de données gigantesques alors que Donald Trump a annoncé la semaine 500 milliards d’investissement aux USA dans les datacenters IA.

puis

puis