L’institut AI2, créé par Paul Allen, donne un nouveau souffle à l’écosystème des modèles « véritablement open source », selon la définition de l’OSI, avec sa nouvelle famille de LLM compacts OLMo 2 très prometteurs.

Les modèles véritablement open source, selon la définition récemment établie par l’OSI, se comptent sur les doigts d’une main. Typiquement des modèles « ouverts » très réputés comme LLama de Meta ou Mistral 7B ne sont pas considérés comme open source pour l’OSI. Une réalité qui éclaire l’annonce de l’association AI2 (Allen Institute for AI) d’un jour nouveau. Cette dernière vient de publier un nouveau « petit » LLM, OLMo 2, réellement open source selon les termes de l’OSI, dont les performances surpassent sur les Benchmarks le très populaire et omniprésent modèle LLama 3.1 8B.

Pour rappel, l’Allen Institute for AI a été fondé en 2014 par Paul Allen (le cofondateur de Microsoft avec Bill Gates, décédé en 2018) avec pour mission de faire avancer les recherches en IA au travers d’outils ouverts et transparents. On lui doit notamment le moteur de recherche académique « Semantic Scholar », la bibliothèque NLP open source « AllenNLP », les modèles textuels « OLMo » ainsi que le modèle multimodal ‘MOLMO’ (lancé en septembre dernier).

Dérivant de OLMo 1 (lancé en mai 2023), OLMo 2 est en réalité une nouvelle famille de modèles LLM textuels compacts comportant de 7 à 13 milliards de paramètres entraînés à partir de 5 000 milliards de tokens. Ces derniers sont issus d’ensembles de données d’entraînement provenant d’articles académiques, de sources de données open-source reconnues, de sites web « filtrés pour leur haute qualité », de forums Q&A, et de cahiers d’exercices mathématiques « synthétiques et générés par des humains ».

« OLMo 2 a été développé de A à Z avec des données d’entraînement ouvertes et accessibles, un code d’entraînement open source, des procédures d’entraînement reproductibles, des évaluations transparentes, des points de contrôle intermédiaires, et plus encore, » explique l’institut dans un billet de blog.

Un modèle très performant, économe et personnalisable

En tant que modèles LLM textuels, OLMo 2 7B et OLMo 2 13B s’affichent en concurrent direct des Mistral 7B, Ministral 8B et LLama 3.1 8B/13B. Ils visent à satisfaire les usages classiques d’IA conversationnelles, d’IA de génération de résumés et même d’IA de génération de code informatique.

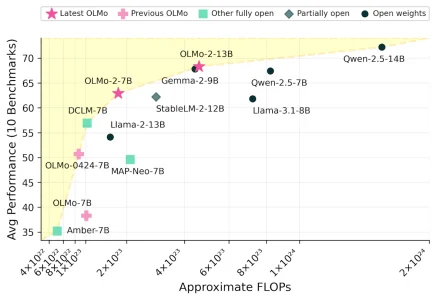

Les tests montrent qu’OLMo 2 surpasse bien des modèles « ouverts » de taille équivalente à commencer par les populaires Gemma-2-9B (de Google), Llama 3.1-8B (de Meta), MAP-Neo-7B et affiche des performances similaires à Qwen 2.5 (la famille de modèles d’Alibaba Cloud) tout en se montrant bien plus économe en ressources informatiques.

Les tests montrent qu’OLMo 2 surpasse bien des modèles « ouverts » de taille équivalente à commencer par les populaires Gemma-2-9B (de Google), Llama 3.1-8B (de Meta), MAP-Neo-7B et affiche des performances similaires à Qwen 2.5 (la famille de modèles d’Alibaba Cloud) tout en se montrant bien plus économe en ressources informatiques.

En appliquant les méthodes de post-entraînement de Tülu 3, AI2 a également développé une variante dénommée OLMo 2-Instruct qui peut aisément être personnalisé par les entreprises avec leurs propres jeux de données. Ce modèle affiche des performances compétitives sur des benchmarks évaluant le suivi des instructions, la restitution des connaissances et le raisonnement mathématique, surpassant certains modèles de référence comme Qwen 2.5 14B Instruct et LLama 3.1 8B Instruct.

Les modèles OLMo 2, ainsi que tous leurs composants, sont disponibles en téléchargement sur le site d’AI2. Distribués sous licence Apache 2.0, ils peuvent être utilisés librement, y compris pour des applications commerciales.

La sortie d’OLMo 2 vient une nouvelle fois éclairer les progrès réalisés dans la pertinence des petits modèles et dans les technologies d’apprentissage, alors que les débats autour des consommations d’énergie excessives des grands modèles se sont encore intensifiés. Elle vient aussi offrir au monde « Open Source » une nouvelle alternative qui répond à la définition de l’OSI tout en affichant des performances dignes des meilleurs modèles moins ouverts ou propriétaires (à taille équivalente). Nul doute que ces modèles vont désormais rapidement rejoindre les bibliothèques de modèles intégrés aux offres des fournisseurs de plateformes IA (NVidia Enterprise AI, Nutanix GPT-In-A-Box et sa stack NAI ‘Nutanix Enterprise AI’, HPE Private Cloud AI, Dell AI Factory, Pure GenAI Pod, Google Vertex AI, Amazon Bedrock, Azure AI Foundry, Hugging Face, etc.)

Avec OLMo 2, AI2 renforce son engagement en faveur de l’ouverture et de la transparence dans le domaine de l’intelligence artificielle. « En partageant ouvertement nos données, nos procédures et nos découvertes, nous espérons fournir à la communauté open source les ressources nécessaires pour découvrir de nouvelles approches innovantes » affirment les responsables de AI2.

puis

puis