Pour répondre aux défis des workloads IA générative, Pure Storage introduit « GenAI Pod » une plateforme clé en main combinant infrastructure, logiciels et intégrations avancées basée sur sa plateforme Purity et la couche logiciel « Enterprise AI » de NVidia.

Comme tous les acteurs du stockage, Pure Storage cède aux sirènes de l’IA en dévoilant une solution clé en main destinée à réduire la complexité et le coût des projets d’intelligence artificielle générative (IA générative). Il est vrai que l’apprentissage des modèles génératifs d’un côté et les inférences couplées aux approches RAG d’un autre côté nécessitent d’intenses flux de données et donc les meilleures performances de stockage possibles. C’est pourquoi tous les acteurs de stockage ont ces derniers mois (notamment Nutanix, HPE et Dell) proposé des solutions spécialement calibrées pour les Workloads IA.

Pure Storage en fait de même en complétant son offre d’une nouvelle solution dénommée « GenAI Pod », une solution « full stack » construite sur ses plateformes et qui s’éloigne un peu de l’univers des baies pour s’aventurer sur celui des appliances tout-en-un. Conçue pour simplifier les déploiements d’IA, la solution associe des designs validés et une intégration technologique avancée et vise à satisfaire les besoins IA de secteurs variés, tels que la santé, la finance et la gestion des connaissances.

Une solution complète pour relever les défis de l’IA

Les solutions GenAI Pod semblent sur le papier dériver des précédents designs intégrés de Pure Storage dédiés à l’IA que son AIRI et FlashStack.

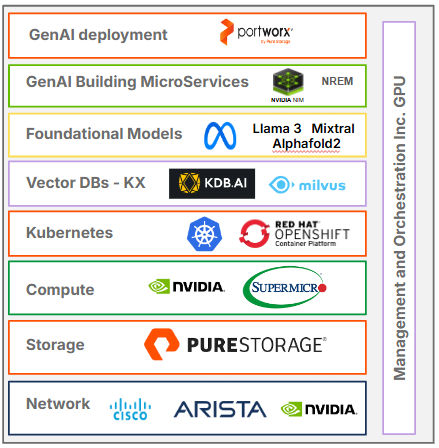

Le GenAI Pod se distingue néanmoins par son intégration très forte et très complète qui comporte du matériel (avec bien évidemment un stockage Pure et son système Purity mais aussi des noeuds de calculs NVidia ou Super Micro), un logiciel de gestion de cluster (Portworx), une plateforme MLOps (signée NVidia) et des modèles fondamentaux pré-entraînés (dont ceux de Meta) dans une solution prête à l’emploi. Avec des fonctionnalités comme les déploiements en un clic et la gestion simplifiée des opérations quotidiennes, il vise à démocratiser l’accès aux technologies d’IA avancées.

Pour concrétiser son design « GenAI Pod », Pure Storage s’appuie sur des collaborations stratégiques avec des partenaires technologiques tels que NVIDIA, Cisco et Meta. Parmi ces partenariats, figure l’intégration de la plateforme logicielle NVIDIA AI Enterprise, qui permet l’automatisation de microservices comme NeMo et NIM, ainsi que l’utilisation de la base de données vectorielle Milvus.

Avec GenAI Pod et sa solution Portworx intégrée, Pure Storage veut aller encore plus loin dans la simplification des déploiement IA que ne le propose une plateforme comme NVidia NIM. » Tout le monde sait que ce n’est pas seulement une question de lancer des déploiements, nous avons ici également rationalisé et automatisé la gestion du cycle de vie et les opérations, afin que les équipes IT puissent rester concentrées sur l’innovation en IA, et non sur la gestion des dépendances et de l’infrastructure » explique Pure Storage.

Les applications initiales d’une telle solution « clé en main » incluent la découverte de médicaments, la recherche financière et les chatbots, notamment grâce à la génération augmentée par récupération (RAG).

Une disponibilité prévue pour 2025

Le GenAI Pod sera accessible au grand public au cours du premier semestre 2025. Cette solution s’inscrit dans la stratégie de Pure Storage visant à simplifier l’adoption de l’IA et à réduire les délais de rentabilisation pour les entreprises.

Selon Dan Kogan, vice-président de Pure Storage, « cette nouvelle solution réduit les risques opérationnels et accélère la création de valeur pour les entreprises grâce à une approche holistique des besoins technologiques ».

Certification FlashBlade//S500 avec NVIDIA DGX SuperPOD

Parallèlement, Pure Storage a certifié son système FlashBlade//S500 avec le DGX SuperPOD de NVidia. Cette certification garantit une performance optimisée, une efficacité énergétique accrue et une compatibilité Ethernet, répondant aux besoins d’entraînement de modèles IA complexes.

puis

puis