Azure annonce de nouvelles VM calibrées pour les travaux IA les plus exigeants mais aussi une nouvelle génération de « containers confidentiels » pour une meilleure isolation et protection des workloads sensibles containerisés.

En annonçant GPT-4 cette semaine, OpenAI mettait en évidence le rôle d’Azure et de l’infrastructure HPC bâtie par Microsoft pour répondre aux besoins d’apprentissage de GPT-4. La firme dirigée par Satya Nadella a ainsi déployé 10.000 GPU Nvidia interconnectés sur un réseau Infiniband à une échelle sans précédent dans le cloud. L’éditeur aurait même dépassé les limites jusqu’ici testées par les équipementiers s’aventurant dans « des terres inconnues » et développant des mécanismes originaux et spécifiques de refroidissement et de fiabilisation.

Nidhi Chappell, chef de produit Microsoft pour le calcul haute performance et l’IA d’Azure, explique ainsi que « parce que ces tâches concernent des milliers de GPU, vous devez vous assurer que vous disposez d’une infrastructure fiable, et que vous avez le réseau en arrière-plan pour pouvoir communiquer plus rapidement et être en mesure de le faire pendant des semaines sans interruption. Il ne s’agit donc pas d’acheter tout un tas de GPU, de les brancher ensemble et de les faire fonctionner ensemble. Il y a beaucoup d’optimisation au niveau du système pour obtenir les meilleures performances, un effort rendu possible par une longue d’expérience acquise sur plusieurs générations. »

De nouvelles VM pour l’IA avec GPU NVidia H100

C’est justement cette expérience assez unique que Microsoft veut désormais mettre à disposition des entreprises. Azure annonce la disponibilité en Preview de ses nouvelles instances VM « ND H100 v5 » pour des Workloads IA nécessitant de 8 à des milliers de GPU NVidia H100 interconnectés par un réseau Nvidia Quantum-2 Infiniband.

Plus concrètement, ces nouvelles VM qui succèdes aux « ND A100 v4 » (basées sur l’ancienne génération de GPU NVidia A100) sont 9 fois plus rapides en phase d’apprentissage et 30 fois plus rapides en inférence. Elles offrent les caractéristiques suivantes :

– CPU Intel Xeon Scalable de 4 ème génération

– 8 GPU Tensor Core NVidia H100 interconnectés par NVSwitch next gen et NVLink 4.0

– 3,2 Tb/sec de bande passante par VM

– 3,6 To/s de bande passant entre les 8 GPU de chaque VM

– 16 canaux mémoire DDR5 à 4800 MHz.

Des containers très « confidentiels »

Si l’IA est sans aucun doute l’un des terrains d’innovation qui accaparent le plus les ingénieurs d’Azure, il existe un autre domaine qui leur inspire des innovations : l’informatique confidentielle (confidential computing).

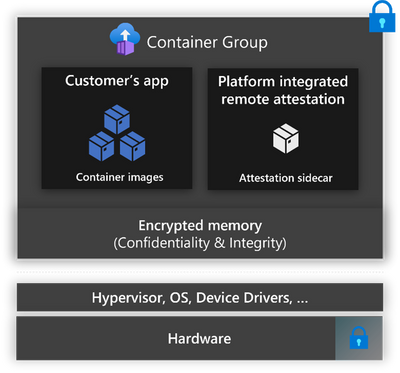

L’informatique confidentielle vise à sécuriser davantage les environnements multi-tenant des clouds. Elle regroupe un ensemble de techniques mais aussi de technologies intégrées au cœur des processeurs visant à protéger les applications et les données durant leur traitement (un moment critique où les données sont classiquement vulnérables car déchiffrées pour être traitées).

Jusqu’ici l’informatique confidentielle exploitait des VM exécutées dans des environnements d’execution de confiance (TEE – Trusted Exécution Environment) s’appuyant sur un mécanisme d’enclave créée au sein du processeur pour isoler traitements et données d’une même VM. Le système s’appuie sur des clés de chiffrement uniquement accessibles au code de l’application désignée de sorte que les données en mémoire vive restent chiffrées jusqu’à leur utilisation par le processeur. Ainsi, même si un tenant est perverti et profite d’une faille dans l’hyperviseur pour sortir de son espace et accéder à la mémoire vive utilisées par les autres tenants, les données restent inexploitables.

Ainsi, Microsoft propose des VM confidentielles depuis 2019 et propose même depuis 2020 des clusters Kubernetes AKS « confidentiels » (reposant sur un usage original des VM pour permettre de combiner des pools de nœuds confidentiels et des pools de nœuds non confidentiels pour accueillir et exécuter les containers).

« Les clients d’Azure se tournent de plus en plus vers des applications cloud-natives, basées sur des conteneurs, pour prendre en charge leurs charges de travail. Cependant, ces clients recherchent également des options d’hébergement en nuage qui offrent les niveaux les plus élevés de protection des données, ce qui nécessite souvent une gestion et une expertise complexes de l’infrastructure » explique Peter Pogorski, product manager Azure Containers. « Pour relever ces défis, nous avons développé des conteneurs confidentiels sur Azure Container Instances. Cette plateforme serverless permet d’exécuter des conteneurs Linux au sein d’un environnement d’exécution sécurisé (TEE) basé sur du matériel certifié, offrant la simplicité d’une plateforme de conteneurs sans serveur avec la sécurité renforcée de l’informatique confidentielle ».

puis

puis