Hier soir et à 48 heures de la conférence Microsoft autour de l’IA au travail, OpenAI a officialisé GPT-4, le modèle multimodal qui doit supplanter le modèle GPT-3 qui anime ChatGPT et tant d’autres IA. En pratique, GPT-4 anime l’IA Bing depuis ses débuts, mais l’information avait été gardée secrète.

C’est forcément un « moment » dans l’univers de l’IA : OpenAI annonce GPT-4, son nouveau modèle linguistique. Pas aussi puissant que ce que les rumeurs prétendaient, mais plus agile et efficient que l’itération précédente, GPT-4 devrait focaliser l’attention de l’univers IT dans les prochaines semaines. Et pour cause, il succède en effet à GPT-3, le modèle qui a fait entrer l’IA générative dans le quotidien de tous, au foyer comme au travail.

Pour rappel, lancé il y a plus d’un an, GPT-3 est le modèle LLM qui a servi de fondation à GitHub Copilot (l’IA qui génère automatiquement des lignes de programmation), Einstein GPT, ClosersCopy (outil de traduction), Rytr, Headlime, Jasper.ai et bien évidemment à la révolution technologique du moment : ChatGPT.

De GPT-3 à GPT-4 : quelles différences ?

Alors forcément, son successeur est très attendu et ses caractéristiques ont été fantasmées par les rumeurs. Loin d’exploiter les milliers de milliards de paramètres, GPT-4 se démarque moins de GPT-3 par la complexité de son réseau de paramètres que par sa nature même. Si GPT-3 est un authentique LLM (Large Language Model), GPT-4 est lui bien davantage un LMM (Large Multimodal Model). Dit autrement, GPT-4 a autant de facilité à comprendre les images et leur contenu qu’il n’en a à comprendre les textes et les questions des utilisateurs.

Et c’est bien là la principale différence avec GPT-3. L’autre étant que la base de connaissance utilisée pour entraîner GPT-4 est également plus actuelle, ce qui rend ses réponses parfois plus pertinentes.

Pour l’utilisateur, OpenAI reconnaît que « dans une conversation formelle, la distinction entre GPT-3.5 et GPT-4 peut être subtile. La différence apparaît lorsque la complexité de la tâche demandée atteint un seuil suffisant ». Mais d’une manière générale, selon OpenAI, « GPT-4 se révèle plus fiable, plus créatif et capable de gérer des instructions beaucoup plus nuancées que GPT-3.5. »

Autre différence subtile mais qui peut se révéler très importante à l’usage : alors que GPT 3.5 avait du mal à rester cohérent et conserver les contextes au-delà de 3000 mots de texte, GPT-4 peut accepter jusqu’à 25000 mots sans tomber dans une confusion troublante.

Enfin, GPT-4 peut afficher différentes personnalités et adapter ses réponses en fonction. « Plutôt que la personnalité classique de ChatGPT avec une verbosité, un ton et un style fixes, les développeurs (et bientôt les utilisateurs de ChatGPT) peuvent désormais prescrire le style de leur IA » précise OpenAI. Et cette capacité n’est pas une surprise puisqu’elle a été découverte dans Bing IA récemment même si elle ne peut être activée pour l’instant que par les testeurs internes chez Microsoft.

Announcing GPT-4, a large multimodal model, with our best-ever results on capabilities and alignment: https://t.co/TwLFssyALF pic.twitter.com/lYWwPjZbSg

— OpenAI (@OpenAI) March 14, 2023

GPT-4, déjà dans Bing, bientôt dans ChatGPT

Car, oui, GPT-4 est effectivement utilisée déjà par plus d’un million d’internautes presque quotidiennement depuis près d’un mois : les utilisateurs validés par Microsoft dans la WaitList d’accès au nouveau Bing. C’est effectivement sur GPT-4 que s’appuie l’IA Bing depuis le début. Une information que Microsoft tenait jusqu’ici secrète, se contentant de dire que l’IA Bing utilisait une nouvelle génération d’IA d’OpenAI.

Par ailleurs, OpenAI a confirmé l’arrivée du modèle GPT-4 dans ChatGPT dans les prochains jours. Toutefois, dans un premier temps, seuls les utilisateurs payants de ChatGPT Plus pourront y avoir accès. L’interface de ChatGPT va d’ailleurs évoluer pour permettre l’interrogation de l’IA à partir d’images. Mais pas tout de suite. OpenAI indique que l’analyse d’images est encore expérimentale et doit être davantage testée (comprenez doit s’enrichir de garde-fous dédiés) par ses chercheurs avant de la mettre à disposition de tous.

Une approche multimodale qui change tout

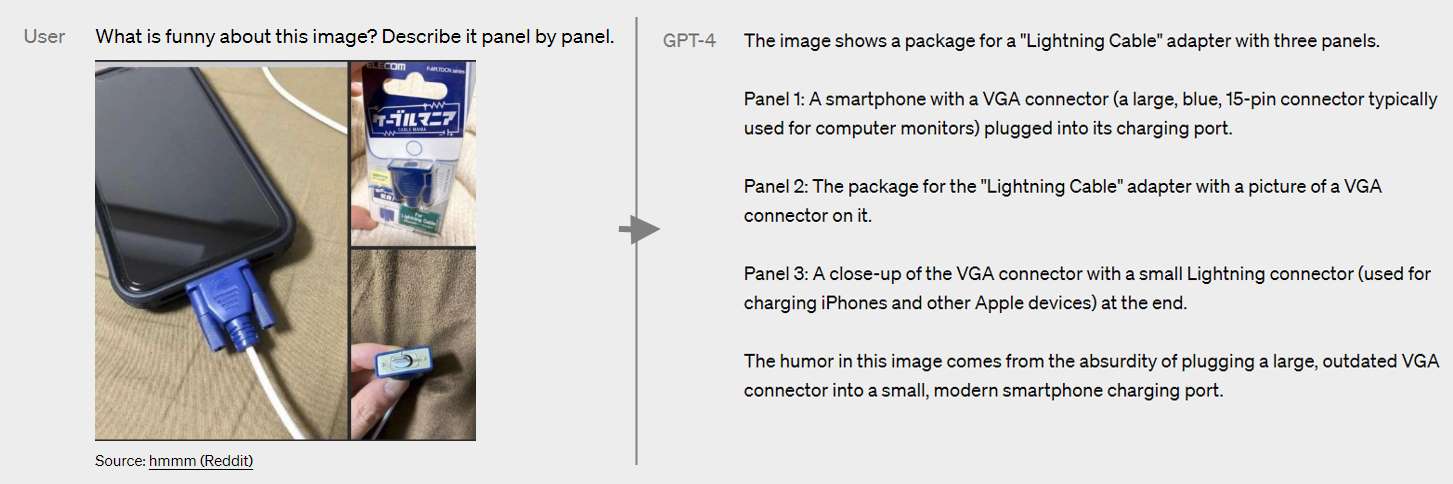

Si GPT-3 et ChatGPT avaient étonné le monde par leur capacité à comprendre les questions, GPT-4 devrait engendrer le même étonnement dans sa capacité à analyser et comprendre les images. L’exemple ci-dessous est assez parlant.

Non seulement l’IA est capable de comprendre une image composite (composée de plusieurs photos) mais elle est aussi capable de comprendre la subtilité de l’image et l’humour qu’elle véhicule : ainsi GPT-4 reconnaît tout l’ironie de cette sélection d’images présentant un smartphone doté d’un ancestral port VGA !

D’ailleurs, l’une des premières applications a exploité le potentiel de GPT-4 n’est autre « Be My eyes » une application pour mal-voyants qui leur permet d’utiliser leur smartphone (et sa caméra) pour décrire le monde qui les entoure. L’application va s’enrichir d’un nouveau mode « Virtual Volunteer » s’appuyant sur GPT-4. Les créateurs du logiciel expliquent que « les utilisateurs peuvent envoyer des images via l’application à Virtual Volunteer doté d’une intelligence artificielle qui répondra à toute question concernant cette image et fournira une assistance visuelle instantanée pour une grande variété de tâches. Par exemple, si un utilisateur envoie une photo de l’intérieur de son réfrigérateur, l’IA sera non seulement capable d’identifier correctement ce qu’il contient, mais aussi d’extrapoler et d’analyser ce qui peut être préparé avec ces ingrédients. L’outil peut également proposer un certain nombre de recettes pour ces ingrédients et envoyer un guide étape par étape sur la façon de les préparer ».

La vidéo ci-dessous donne d’autres aperçus du potentiel de cette technologie.

Un GPT-4 presque aussi blagueur que GPT-3…

Tout n’est pas parfait, bien sûr. Comme le reconnaît le cofondateur d’OpenAI, Sam Altman, « les capacités multimodales de GPT-4 sont plus impressionnantes à première vue qu’après un certain temps d’utilisation » car GPT-4 n’échappe pas vraiment aux défauts et critiques exprimées sur la génération précédente. Typiquement dans la vidéo Visual Volunteer on entend très bien l’IA expliquer que les appareils de gym libres sont ceux sur lesquels il n’y a personne. Ça, c’est de l’info !

OpenAI ne dissimule nullement les limites de GPT-4. L’éditeur reconnaît que comme pour les itérations précédentes, l’IA peut « halluciner », faire des erreurs de raisonnement, souffre de biais induits par les documents non certifiés utilisés pour son apprentissage ou inventer des faits avec un aplomb confondant. Dans un exemple montré par OpenAI, GPT-4 révèle ainsi qu’Elvis Presley est le fils d’un acteur. Une totale invention.

Par ailleurs, certaines limites de ChatGPT sont toujours présentes dans GPT-4. Ainsi « GPT-4 n’a généralement pas connaissance des événements qui se sont produits après septembre 2021 et n’apprend pas de son expérience », explique OpenAI. « Il peut parfois faire de simples erreurs de raisonnement qui ne semblent pas correspondre à ses compétences dans tant d’autres domaines, ou se révéler bien trop crédule en acceptant de fausses déclarations évidentes de la part de l’utilisateur. Et parfois, l’IA peut échouer face à des problèmes difficiles de la même manière que les humains, par exemple en introduisant des vulnérabilités de sécurité dans le code qu’elle produit. »

Quoi qu’il en soit, GPT-4 marque une nouvelle étape dans la progression des IA et l’aide qu’elles apportent au quotidien aux humains. Malgré les défauts évoqués plus haut, GPT-4 se montre, par rapport au ChatGPT actuel, 82% moins enclin à se laisser répondre à des contenus « interdits » et produit des réponses factuelles justes plus fréquemment (40% d’amélioration).

Reste à voir comment Microsoft va exploiter tout ce potentiel dans Microsoft 365 : on devrait avoir des réponses dès demain, date de sa conférence autour de l’IA au travail.

puis

puis