IBM et Microsoft ont, chacun de leur côté, annoncé d’importantes évolutions de leurs petits modèles Granite et Phi qui gagnent en intelligence, en capacités multimodales et en capacité de raisonnement !

Parallèlement à leurs différents partenariats avec les startups de l’IA produisant des modèles frontières, IBM et Microsoft restent très actifs dans le domaine de la R&D autour des « petits » modèles, plus faciles à inférer dans les datacenters des entreprises et plus faciles aussi à personnaliser pour les entreprises afin de les aligner sur leurs besoins métiers propres.

Et tout au long de l’année 2024, les deux entreprises ont largement pu démontrer qu’en matière de modèles IA génératifs, « petit » ne voulait pas dire « moins utile », bien au contraire.

Et 2025 devrait également démontrer que ces modèles sont de plus en plus intelligents et capables de se confronter à des problèmes complexes. IBM vient ainsi d’annoncer Granite 3.2 et Microsoft les nouvelles déclinaisons de Phi-4.

IBM lance Granite 3.2

IBM vient de dévoiler la nouvelle génération de sa famille de modèles d’intelligence artificielle Granite. Cette version 3.2 apporte des améliorations significatives en matière de raisonnement, de vision et d’efficacité, le tout dans des modèles plus compacts conçus spécifiquement pour répondre aux besoins des entreprises.

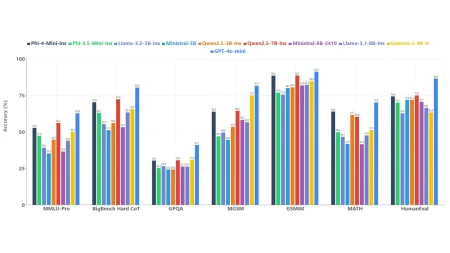

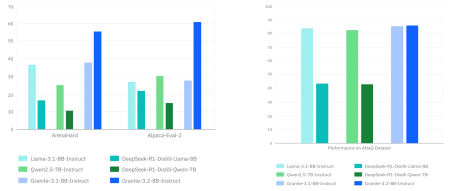

Selon les benchmarks de l’éditeur, les modèles Granite 3.2 Instruct 8B et Granite 3.2 Instruct 2B surpassent significativement leurs prédécesseurs grâce à l’intégration de capacités expérimentales de raisonnement par chaîne de pensée (chain of thought). Contrairement à d’autres entreprises qui proposent des modèles à raisonnement distincts, IBM a choisi – comme Anthropic avec son Claude 3.7 Sonnet et comme OpenAI avec son futur GPT-5 – d’intégrer cette fonctionnalité directement dans ses modèles Instruct, avec la possibilité de l’activer ou de la désactiver selon les besoins. Ainsi, ces nouveaux modèles IBM se montrent plus efficaces que les versions précédentes pour des tâches nécessitant une compréhension approfondie et une exécution précise d’instructions.

L’approche d’IBM s’appuie notamment sur une technique appelée « inference scaling », qui permet au modèle d’évaluer et d’améliorer son propre processus de raisonnement. Cette méthode a permis à Granite 3.2 de surpasser des modèles pourtant bien plus volumineux comme GPT-4o et Claude 3.5 Sonnet sur certains benchmarks mathématiques comme MATH500 et AIME2024.

Et Granite se met aussi désormais à l’analyse d’images. Avec Granite Vision 3.2 2B, IBM introduit un modèle de vision-langage (VLM) léger mais performant, spécialement conçu pour la compréhension de documents. Ce modèle prétend déjà rivaliser avec des solutions bien plus volumineuses sur des benchmarks d’entreprise comme DocVQA et ChartQA. Pour son entraînement, IBM a créé un jeu de données spécifique nommé DocFM, basé sur des documents d’entreprise, des images, des graphiques et des diagrammes.

Parallèlement, IBM continue de faire évoluer ses modèles connexes de sécurité et de compréhension des séries temporelles initiés à l’occasion de la génération 3 des modèles Granite.

La nouvelle version de Granite Guardian 3.2, disponible en deux variantes (5B et 3B-A800M), offre des fonctionnalités de protection similaires à l’édition 3.1, mais avec une empreinte réduite et des temps d’inférence plus courts. Une nouvelle fonctionnalité de « confiance verbalisée » permet désormais d’évaluer les risques potentiels de manière plus nuancée.

Les modèles de séries temporelles (TTM) de Granite 3.2 prennent désormais en charge les prévisions hebdomadaires et quotidiennes, en plus des résolutions déjà disponibles. Avec moins de 10 millions de paramètres, ces modèles « minuscules » surpassent néanmoins des concurrents comme le TimesFM-2.0 de Google (500M paramètres) et le Chronos-Bolt-Base d’Amazon (205M paramètres) en précision de prévision ponctuelle.

Tous les modèles Granite 3.2 sont disponibles sous licence Apache 2.0 sur Hugging Face, watsonx.ai, Ollama et LM Studio. Ils devraient également être intégrés prochainement à RHEL AI 1.5.

Microsoft complète sa gamme Phi-4

Microsoft avait déjà montré sa volonté d’enrichir ses petits modèles SLM de capacité de raisonnement en lançant les premières versions de sa génération « Phi-4 » en décembre dernier. L’éditeur vient d’enrichir la gamme Phi-4 avec deux nouveaux modèles : Phi-4-multimodal-Instruct et Phi-4-mini-Instruct. Ces solutions compactes mais puissantes visent à offrir des capacités d’IA avancées tout en maintenant une efficacité optimale pour les développeurs.

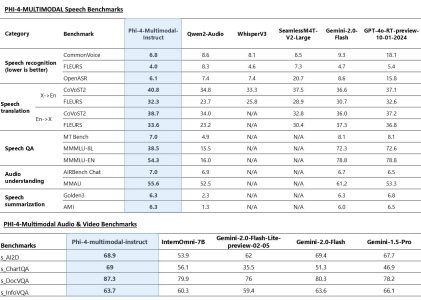

Le modèle Phi-4-multimodal, avec ses 5,6 milliards de paramètres, marque la première incursion de Microsoft dans le domaine des modèles de langage multimodaux. Il propose un traitement unifié des entrées vocales, visuelles et textuelles simultanément, éliminant ainsi le besoin de pipelines complexes ou de modèles distincts pour différentes modalités.

Et le modèle se montre étonnant de précision malgré sa petite taille. Il vient de prendre la tête du classement HuggingFace OpenASR et surpasse le pourtant très impressionnant WhisperV3 d’OpenAI en reconnaissance comme en traduction vocale !

Mieux encore, selon les benchmarks réalisés par les chercheurs de Microsoft, Phi-4-multimodal tiendrait la comparaison avec le dernier modèle Gemini-2.0-Flash de Google dans la compréhension de documents et le raisonnement visuel ! Étonnant.

De son côté, Phi-4-mini est un modèle de 3,8 milliards de paramètres seulement axé sur le texte (LLM pur) mais qui promet beaucoup malgré sa taille réduite. Ainsi, sa fenêtre contextuelle est étendue à 128.000 tokens et le modèle offre d’excellentes performances dans le raisonnement, les mathématiques, le codage et le suivi d’instructions. Il intègre des capacités d’appel de fonctions permettant l’intégration avec des outils externes et des API à des fins agentiques.

puis

puis