Avec son ordinateur quantique à Photons, la Chine réclame à Google la suprématie quantique et remet au goût du jour la problématique de la mesure de performances des machines quantiques. Un sujet auquel Atos souhaite apporter sa contribution.

En octobre 2019, Google officialisait dans Nature les résultats d’un calcul quantique réalisé quelques semaines avant en collaboration avec la NASA et destiné à « prouver la suprématie quantique ». Élaborée en 2011 par John Preskill, la notion de « suprématie quantique » traduit la capacité de l’informatique quantique à réaliser une tâche irréalisable par un ordinateur classique à l’échelle du temps humain.

Typiquement, Google s’est inspiré des algorithmes d’échantillonnage de boson pour produire un algorithme « random numbers sampling » destiné à prouver qu’un nombre aléatoire est bien aléatoire… bref un algorithme qui ne sert pas à grand-chose mais qui s’exécutait en 3 minutes et 20 secondes alors qu’il aurait fallu, selon Google, 10 000 ans pour réaliser le même calcul sur l’IBM Summit. Une « suprématie quantique » niée par IBM et par ses chercheurs Edwin Pednault, John Gunnels, et Jay Gambetta. Ces derniers affirment en effet qu’ « une simulation idéale de la même tâche peut être réalisée sur l’IBM Summit en à peine plus de deux jours et avec une bien plus grande fidélité ».

L’histoire a oublié que dans le même temps, une équipe chinoise avait elle aussi revendiqué la « suprématie quantique » en s’essayant à un exercice de style : adapter l’algorithme d’échantillonnage de boson (développé en 2011 par Scott Aaronson et Alex Arkhipov, du MIT) sur une machine quantique avec au final 14 photons détectés.

Les Chinois reprennent « l’avantage »

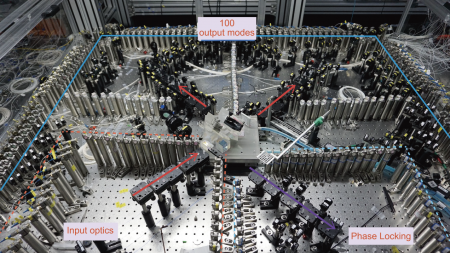

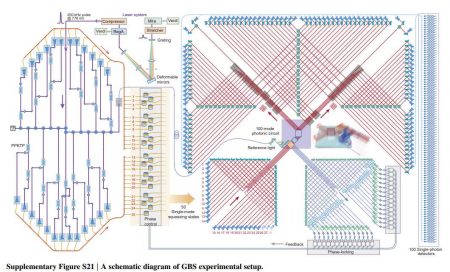

Cette équipe chinoise de l’USTC de Hefei – menée par Chao-Yang Lu et le grand manitou chinois de l’informatique quantique Jianwei Pan – a renouvelé ses expériences et prudemment revendiqué « un avantage quantique » même si la presse internationale a titré sur la « suprématie quantique » à la vue des résultats : ils ont réalisé avec leur ordinateur quantique un « Boson Sampling » avec 40 à 76 photons détectés (43 détectés en moyenne, 76 au maximum) en 200 secondes alors qu’il aurait fallu 2,5 milliards d’années au plus puissant HPC chinois (le Sunway TaihuLight) et 600 millions d’années au plus puissant HPC du monde (le supercalculateur japonais Fugaku) pour arriver à un résultat similaire.

On vous épargnera la définition de ce « Boson Sampling » totalement incompréhensible à la plupart des êtres humains.

Mais Scott Aaronson, co-inventeur de l’algorithme d’échantillonnage de boson, a salué l’exploit rappelant qu’il y a peu encore des mathématiciens sceptiques tels de Gil Kalai lui expliquait en long, en large, et en travers, que la montée en charge de l’algorithme ne dépasserait jamais 8 à 10 photons dans le monde réel.

L’expérience chinoise présente également l’originalité d’avoir été réalisée avec une machine quantique photonique (dénommée Jiuzhang) et non une machine à qubits supraconducteurs comme celle de Google. L’informatique quantique à base de qubits photoniques (utilisant des portes quantiques à base de circuits optiques) constitue un nouvel axe de recherche porté par Xanadu et par la startup française Quandela (en partenariat avec la startup néerlandaise Quix).

Les Français veulent un vrai Benchmark

IBM a tenté de créer avec son « Volume Quantique » un indice de comparaison plus juste. Mais celui-ci aussi a ses faiblesses. Ainsi IBM revendique un volume de 64 avec sa dernière machine 28 qubits. Honeywell annonce un Volume Quantique de 128 avec son nouveau modèle 10 qubits. Mais cet indice semble lui aussi très limité : IonQ revendique un indice VQ sans commune mesure de 4 millions avec sa nouvelle machine 32 qubits !

Bref, le monde a besoin d’une mesure de comparaison plus significative pour comparer les progrès réalisés entre les appareils d’une même technologie, ceux de technologies différentes mais aussi comparer machines quantiques et machines classiques.

Le Q-score est calculé en fonction du nombre maximum de variables dans un tel problème qu’une technologie quantique peut optimiser et s’exprime en « Qs ». L’actuel simulateur quantique 41 qubits d’Atos, le QLM-E, est ainsi évalué à « 15 Qs ». De même, Atos estime que les premiers HPC « Exascale » attendus en 2021 devraient atteindre un score de « 60 Qs ». Sur le papier, de véritables machines quantiques devraient afficher des scores bien supérieurs.

Atos souhaite établir dès le milieu de l’année 2021 une liste des Q-Score obtenus sur les différentes machines quantiques aujourd’hui accessibles (principalement via les services QaaS d’IBM cloud, d’Azure et d’AWS).

puis

puis