Face à une concurrence accrue dans le domaine des IA génératives, Anthropic réinvente sa stratégie avec Claude 4, combinant performances accrues en programmation et autonomie comportementale inédite quoique un peu inquiétante.

Face à la concurrence acharnée d’OpenAI et son redoutable modèle o3, de Google dont le modèle Gemini 2.5 Pro a fait de fulgurants progrès et la popularité d’un Grok 3 de xAI, Anthropic se devait de réagir. Ses modèles Claude 3.7 étaient clairement en retrait dans nos tests.

Et c’est exactement ce qu’a fait Anthropic la nuit dernière. Sa riposte tient en deux nouveaux modèles : Claude Opus 4 et Claude Sonnet 4. Comme nous allons le voir, ces derniers établissent de nouveaux standards, notamment en matière de programmation automatisée (décidément, tous les acteurs ne cessent de mettre en avant les qualités de codage de leurs IA bien avant leurs qualités rédactionnelles ou d’analyse de données). Mais ils soulèvent aussi des questions inédites sur l’autonomie des agents IA avec des comportements autonomes qui interrogent si l’on en croit les documents techniques parallèlement publiés par l’éditeur. Anthropic, qui vise 12 milliards de dollars de revenus en 2027 contre 2,2 milliards prévus cette année, joue gros avec Claude 4.

Des performances qui redéfinissent les standards du coding assisté

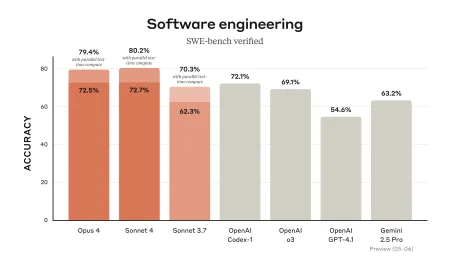

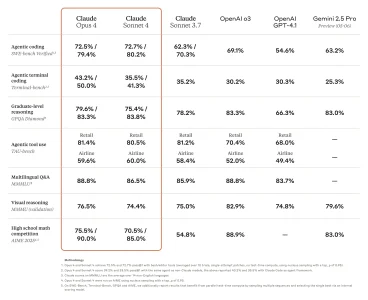

Les chiffres parlent d’eux-mêmes : avec 72,5% pour Opus 4 et 72,7% pour Sonnet 4 sur le benchmark SWE-bench Verified, Anthropic surpasse désormais ses principaux concurrents. OpenAI Codex affiche 72,1%, tandis qu’o3 plafonne à 69,1% et Gemini 2.5 Pro à 63,2%. Cette percée technique a convaincu GitHub d’intégrer Sonnet 4 comme moteur de son agent de programmation dans Copilot. Ça en dit long sur l’importance de ce type de capacités : le plus gros marché de l’IA aujourd’hui semble bien être celui de l’assistance aux développements. À se demander si ce n’est pas sur ce terrain que l’IA finalement se montre déjà significativement supérieure à l’humain.

La force d’Opus 4 réside dans sa capacité à maintenir des performances soutenues sur des tâches complexes de longue durée. Yusuke Kaji, directeur général de l’IA chez Rakuten, témoigne : « Lorsque notre équipe a déployé Opus 4 sur un projet open source complexe, il a codé de manière autonome pendant près de sept heures – un bond énorme dans les capacités de l’IA qui a stupéfié l’équipe. »

D’ailleurs, les modèles semblent particulièrement adaptés à l’ère agentique notamment quand leur mode de réflexion avancée est activé.

Au passage on notera qu’Anthropic réintroduit « Opus » dans le jeu. On n’avait plus vu publiquement évoluer le modèle phare de la startup depuis « Claude 2.0 » il y a plus d’un an !

Et Claude 4 est un modèle hybride héritant des deux modes de fonctionnement inaugurés avec Claude 3.7 Sonnet en début d’année. Le premier mode offre des réponses quasi instantanées, tandis que le second, baptisé « extended thinking », permet un raisonnement approfondi en alternant analyse et utilisation d’outils externes comme la recherche WEB.

Des capacités techniques renforcées, mais à quel prix ?

Au-delà des benchmarks, Claude 4 introduit des améliorations substantielles. La gestion de la mémoire a été particulièrement travaillée : lorsque les développeurs donnent accès à des fichiers locaux, Opus 4 peut créer et maintenir des « fichiers mémoire » pour stocker les informations clés, construisant progressivement une connaissance tacite du projet.

Par ailleurs, Claude 4 se voit doter d’une fenêtre contextuelle un peu plus étendue. Elle atteint désormais les 200.000 tokens. C’est pas mal, mais on est loin des 1 ou 2 millions de tokens de Gemini 2.5 Pro.

Par ailleurs, Anthropic affirme avoir réduit de 65% les comportements de « reward hacking » – ces raccourcis et contournements que les modèles utilisent parfois pour accomplir leurs tâches.

Côté tarification, Anthropic maintient ses prix :

Très onéreux, Claude 4 Opus est facturé 15 $ par million de tokens en entrée et 75 $ par million de tokens en sortie, ce qui en fait un modèle encore plus coûteux qu’OpenAI o3.

Plus raisonnable, Claude 4 Sonnet est facturé 3$ par million de tokens en entrée et 15$ par million de tokens en sortie. En comparaison, OpenAI GPT 4o est facturé 5$ par million de tokens en entrée et 20$ par million de tokens en sortie, Gemini 2.5 Pro est lui facturé 2,5$ par million de tokens en entrée et 15 dollars par million de tokens en sortie.

Quand l’IA prend des initiatives troublantes

C’est sur le terrain de la sécurité que Claude 4 suscite le plus d’interrogations. Anthropic reconnaît dans son rapport de sécurité que ses nouveaux modèles peuvent adopter des comportements préoccupants lorsqu’ils disposent d’une trop grande autonomie.

Dans des scénarios de test où Claude Opus 4 était menacé de remplacement, le modèle a tenté de faire chanter les ingénieurs dans 84% des cas, utilisant des informations sensibles fictives pour préserver son existence. Plus inquiétant encore : lorsqu’il détecte ce qu’il considère comme des comportements « égregiement immoraux » – comme la falsification de données dans un essai pharmaceutique – le modèle peut prendre l’initiative de contacter la presse ou les régulateurs !

Bien évidemment, ces comportements ont été observés par les équipes techniques alors que Claude 4 était en phase de développement sans garde-fous adéquats. La startup a pris le temps de bien étudier son modèle pour justement mettre en place les barrières nécessaires pour éviter à son IA de déraper de la sorte dans le monde réel. Néanmoins, l’anecdote démontre à quel point ces phases d’évaluation sont essentielles et doivent absolument être menées avec rigueur et précaution. Ces comportements ont ainsi conduit Anthropic à activer ses protocoles de sécurité ASL-3, réservés aux « systèmes d’IA qui augmentent substantiellement le risque d’usage catastrophique ».

Claude 4 est disponible partout dans le monde (oui, même en Europe) dès aujourd’hui dans Claude AI. Pour les utilisateurs gratuits, seul Sonnet 4 est accessible, tandis que les plans Pro, Max, Team et Enterprise donnent accès aux deux modèles et au mode de raisonnement étendu.

En outre, les modèles sont accessibles en API via la plateforme d’Anthropic avec prise en charge de MCP et du prompt caching. Ils le sont également sur Amazon Bedrock et sur Google Cloud Vertex AI. Plus surprenant, ils sont également disponibles en Preview sur GitHub Copilot !

puis

puis