OpenAI annonce une nouvelle intelligence artificielle au talent créatif surprenant. Elle démontre une nouvelle fois les étonnants progrès réalisés par l’IA en quelques années.

GPT-3 a encore frappé ! L’intelligence artificielle créée par OpenAI a sidéré le petit monde de la recherche en 2020 par sa capacité à générer du texte intelligible ou même des lignes de programmation. GPT-3 avait démontré qu’il était possible d’enseigner à un vaste réseau neuronal une variété de tâches de génération de textes à partir d’une idée ou d’une brève description. GPT-3 est aujourd’hui distribué sous licence exclusive par Microsoft, mais OpenAI continue de dériver son réseau pour l’entraîner à de nouvelles tâches surprenantes.

DALL-E dérive directement de GPT-3. Comme elle, cette nouvelle IA s’appuie sur un modèle de transformation linguistique. Mais contrairement à GPT-3, cette IA est entraînée en lui soumettant des images et des mots clés associés. Le modèle reçoit un flux de 1280 jetons (256 pour le texte, 1024 pour l’image) contenant à la fois le texte et l’image en un flux de données unique. Après le prétraitement, le modèle est ensuite entraîné en utilisant la probabilité maximale de générer tous les jetons séquentiellement et créé l’image correspondant au texte demandé. Le modèle comporte 12 milliards de paramètres afin d’offrir le niveau d’intelligence nécessaire pour lui permettre de créer en combinant les éléments de base qui lui ont été enseignés.

DALL-E est ainsi à même de créer des images plausibles pour une grande variété de phrases. Selon OpenAI, une fois entraînée, cette IA s’est révélée capable de créer des versions anthropomorphisées d’animaux et d’objets, de combiner de manière plausible des concepts pourtant sans rapport, et d’appliquer des transformations aux images existantes.

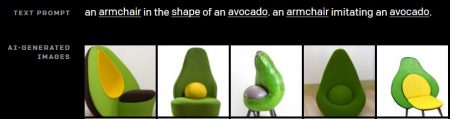

Typiquement, si on lui demande de dessiner « un fauteuil ayant la forme d’un avocat », elle produit un ensemble de propositions répondant de façon étonnante à la description textuelle fournie :

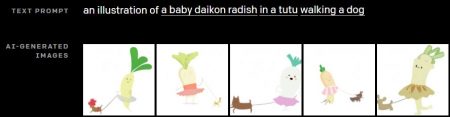

Autre exemple bluffant : si on lui demande quelque chose de plus délirant comme « une illustration d’un bébé radis en tutu promenant un chien », elle propose des résultats très cartoonesques. Ainsi créer « un radis en tutu » et lui « faire promener un chien » lui inspire les résultats suivants combinant plusieurs objets et concepts :

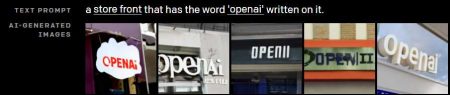

Dall-E sait ainsi jouer avec les formes, les perspectives et les lettres. Si on lui demande de « créer une devanture avec le mot « OpenAI » écrit dessus », elle propose des photographies fictives et virtuelles mais d’un surprenant réalisme :

Il est aussi possible d’instruire à Dall-E de créer des compositions. Typiquement si on lui demande « une photo d’un chat au-dessus avec son illustration crayonnée en dessous », elle produit le résultat suivant :

Elle est aussi capable de générer des images photoréalistes. Par exemple, si on lui demande « une photo du Golden Gate de San Francisco de nuit », elle génèrera une photo alternative et virtuelle à partir de celles qu’elle a reçues en apprentissage s’assurant d’ajuster la luminosité pour obtenir un effet nocturne et se montre même capable d’allumer les projecteurs ou d’éclairer les fenêtres des immeubles.

L’IA connaît même les concepts de temps (un photo d’un téléphone de 1920) ou de géographie…

La qualité des résultats dépend intrinsèquement de la formulation du texte en entrée. Mais Dall-E n’est encore qu’une enfant. Un peu de complexité l’amène rapidement à ses limites. Si on lui demande de combiner un trop grand nombre d’objets, elle se met à cafouiller, confondant les associations entre les objets, les concepts, les couleurs pour arriver à des résultats très différents de la demande initiale.

Vous pouvez vous même expérimenter le fonctionnement de Dall-E et ses limites en jouant avec les exemples interactifs proposés par OpenAI sur son site : DALL·E: Creating Images from Text

OpenAI prévoit de fournir plus de détails sur la formation et l’architecture de DALL-E dans les prochaines semaines. Son expérience démontre que les modèles transformateurs peuvent arriver à des résultats dignes des GANs (Réseaux génératifs adversariaux) en matière de réalisme visuel. Elle marque une nouvelle étape dans la recherche sur le Deep Learning et les réseaux de neurones tout en laissant entrevoir ce que les IA seront capables de faire dans les prochaines années. Une chose est certaine, elles progressent à une vitesse bien plus élevée que ce qu’il était possible d’imaginer il y a encore 10 ans.

puis

puis