Plus un modèle LLM est grand, plus il réclame de ressources aussi bien dans sa formation que dans son inférence (son exécution), et dès lors il coûte cher… aux entreprises comme à la planète. Avec GPT-4o Mini, OpenAI lance un « petit » modèle qui fait presque aussi bien que GPT-4o pour beaucoup moins cher… Et la planète lui dit merci…

En 18 mois, OpenAI nous a livré GPT 3.5 (le LLM de la toute première version de ChatGPT), GPT 3.5 Turbo, GPT-4, GPT-4 Vision, GPT-4 Turbo, GPT-4o, à chaque fois des modèles toujours plus puissants, toujours plus performants mais aussi toujours plus voraces en ressources et donc toujours plus chers. Au point que pour rester compétitif face aux prix plus agressifs de Google avec Gemini ou de concurrents comme Mistral AI, OpenAI continuait de proposer GPT 3.5 Turbo aux utilisateurs gratuits de ChatGPT et aux entreprises en quête d’un LLM moins onéreux que son fleuron du moment, le « GPT-4 omni » aussi appelé « GPT-4o ».

Mais ça, c’était avant… Avant qu’OpenAI n’annonce avoir rétréci GPT-4o !

Dénommé « GPT-4o mini », le nouveau modèle d’OpenAI est une version allégée et optimisée de son dernier modèle LLM « GPT-4o » qui anime les versions payantes de ChatGPT.

Un modèle moins onéreux

Comme c’est désormais presque toujours le cas, la startup ne précise pas exactement de combien de paramètres est constitué son modèle mini. Elle se contente de le comparer à Gemini Flash et Claude Haiku dont on ne connaît pas le nombre de paramètres non plus. Il est généralement admis que ces modèles se situent dans une fourchette comprise entre 30 et 120 milliards de paramètres. Ce sont donc davantage des « petits LLM » que des « SLM » (small language model) qui n’ont pas vocation à s’exécuter en local.

Sa taille est toutefois suffisamment compacte pour permettre à OpenAI de proposer un « GPT-4o mini » à un prix 60% inférieur à celui de « GPT 3.5 Turbo » (son LLM le plus accessible) : GPT-4o mini est facturé 15 centimes par million de tokens en entrée et 60 centimes par million de tokens en sortie. En comparaison le modèle étendu « GPT-4o » coûte 5 dollars par million de tokens en entrée et 15 dollars par million de tokens en sortie. Oui, vous calculez bien, « GPT-4o mini » est environ 30 fois moins cher à utiliser que son grand frère « GPT-4o ».

Un modèle presque aussi pertinent

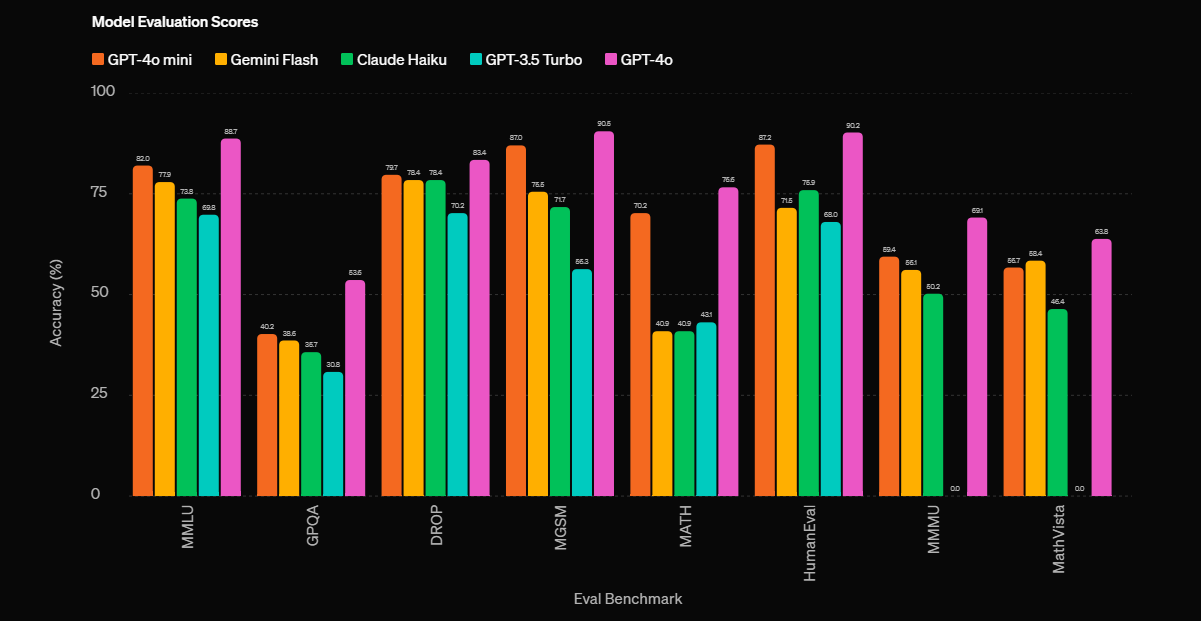

Or à en juger par les benchmarks fournis par OpenAI, il est loin – mais alors très loin – d’être 30 fois moins pertinents. En réalité, il fait presque jeu égal avec « GPT-4o » et surclasse très largement « GPT 3.5 Turbo », Claude Haiku et Gemini Flash. Au point d’ailleurs qu’OpenAI a déjà retiré « GPT 3.5 Turbo » de ChatGPT et encourage tous les clients à migrer vers ce LLM « mini ».

D’autant que contrairement à GPT 3.5 Turbo, GPT-4o mini est un modèle multimodal qui sait analyser en entrée des documents textuels mais aussi des images, des enregistrements sonores, et même des vidéos. Il devrait même pouvoir produire des images en sortie dans un très proche avenir. Il offre en outre une fenêtre contextuelle de 128 000 tokens.

OpenAI précise que « GPT-4o mini permet une large gamme de tâches grâce à son faible coût et sa faible latence. En l’occurrence des tâches telles que des applications qui enchaînent ou parallélisent plusieurs appels au modèle (par exemple, appeler plusieurs API), transmettent un grand volume de contexte au modèle (par exemple, une base de code complète ou l’historique d’une conversation), ou interagissent avec les clients par des réponses textuelles rapides en temps réel (par exemple, des chatbots de support client) ».

Un modèle plus sûr

En outre, « GPT-4o mini » se veut le modèle le plus sûr à ce jour d’OpenAI. Il implémente une nouvelle technique de contrôle dénommée « hiérarchie d’instructions » qui renforce les défenses du modèle contre les mauvais usages, les utilisations abusives, les instructions non autorisées. Cette technique permet de contrer certaines attaques qui utilisent des prompts spécialement forgés pour lui faire oublier les instructions générales gravées dans le modèle.

Cette technologie a été développée pour rendre les modèles comme GPT-4 plus sûrs à l’usage et doit servir aux futures « Agents AI » d’OpenAI pour s’assurer que les agents restent dans les limites d’usage qui leur sont assignées. Elle n’empêche toutefois pas les modèles LLM d’halluciner et d’inventer des contre-vérités… Un défaut classique des modèles de types « GPT / Transformers ».

« GPT 4o Mini » est déjà disponible dans ChatGPT version gratuite, ChatGPT Plus (la version payante), sur la plateforme API d’OpenAI mais aussi sur celle de son principal partenaire Microsoft qui annonce la disponibilité immédiate du modèle dans Azure AI, sur Azure OpenAI Service et sur la zone de tests gratuite Azure OpenAI Studio Playground.

puis

puis